3.5. 验证曲线:绘制分数以评估模型#

每个估计器都有其优点和缺点。其泛化误差可以分解为偏差、方差和噪声。估计器的偏差是它在不同训练集上的平均误差。估计器的方差表示它对不同训练集变化的敏感程度。噪声是数据的属性。

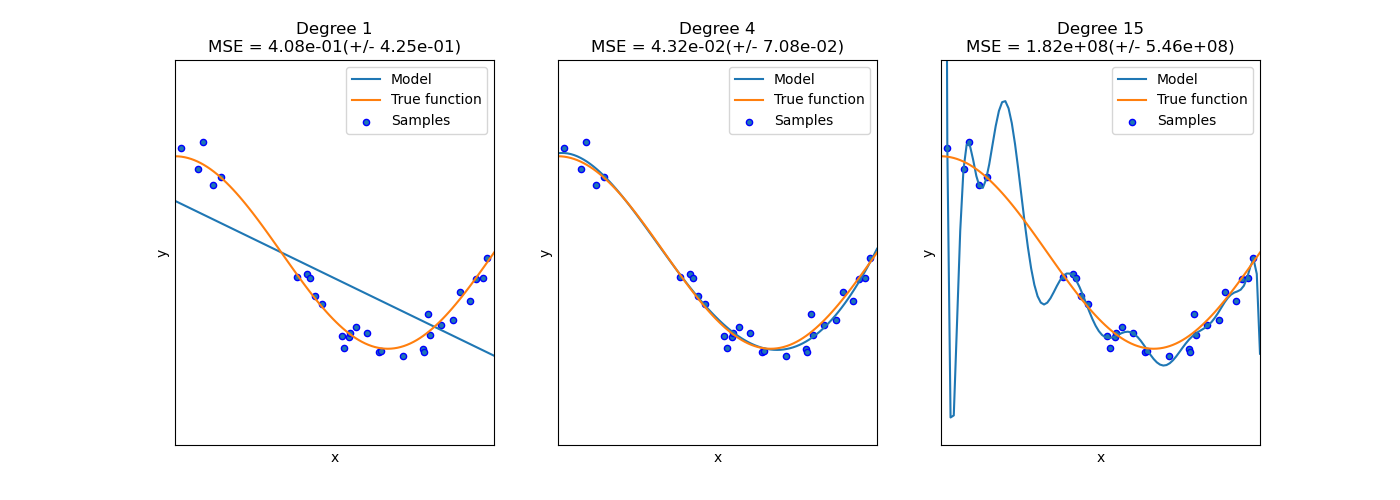

在下面的图中,我们看到一个函数 \(f(x) = \cos (\frac{3}{2} \pi x)\) 以及来自该函数的一些带噪声样本。我们使用三个不同的估计器来拟合该函数:分别具有 1、4 和 15 次多项式特征的线性回归。我们看到,第一个估计器充其量只能对样本和真实函数提供较差的拟合,因为它过于简单(高偏差);第二个估计器几乎完美地近似了它;最后一个估计器完美地近似了训练数据,但对真实函数的拟合效果不是很好,也就是说,它对不同的训练数据非常敏感(高方差)。

偏差和方差是估计器的固有属性,我们通常必须选择学习算法和超参数,使偏差和方差都尽可能低(参见偏差-方差困境)。另一种减少模型方差的方法是使用更多的训练数据。但是,只有当真实函数过于复杂,以至于无法被方差较低的估计器近似时,才应该收集更多的训练数据。

在我们前面例子中看到的简单一维问题中,很容易看出估计器是受偏差还是方差的影响。然而,在高维空间中,模型可能变得非常难以可视化。因此,使用下面描述的工具通常很有帮助。

示例

3.5.1. 验证曲线#

为了验证模型,我们需要一个评分函数(参见指标和评分:量化预测质量),例如分类器的准确率。选择估计器多个超参数的正确方法当然是网格搜索或类似方法(参见调整估计器的超参数),这些方法会选择在验证集或多个验证集上得分最高的超参数。请注意,如果我们根据验证分数优化超参数,那么验证分数就会有偏差,不再是泛化能力的一个很好的估计。要获得对泛化能力的正确估计,我们必须在另一个测试集上计算分数。

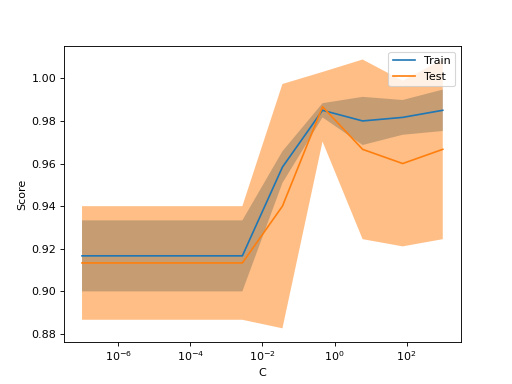

然而,有时绘制单个超参数对训练分数和验证分数的影响很有帮助,以便找出估计器在某些超参数值下是过拟合还是欠拟合。

函数 validation_curve 在这种情况下可以提供帮助

>>> import numpy as np

>>> from sklearn.model_selection import validation_curve

>>> from sklearn.datasets import load_iris

>>> from sklearn.svm import SVC

>>> np.random.seed(0)

>>> X, y = load_iris(return_X_y=True)

>>> indices = np.arange(y.shape[0])

>>> np.random.shuffle(indices)

>>> X, y = X[indices], y[indices]

>>> train_scores, valid_scores = validation_curve(

... SVC(kernel="linear"), X, y, param_name="C", param_range=np.logspace(-7, 3, 3),

... )

>>> train_scores

array([[0.90, 0.94, 0.91, 0.89, 0.92],

[0.9 , 0.92, 0.93, 0.92, 0.93],

[0.97, 1 , 0.98, 0.97, 0.99]])

>>> valid_scores

array([[0.9, 0.9 , 0.9 , 0.96, 0.9 ],

[0.9, 0.83, 0.96, 0.96, 0.93],

[1. , 0.93, 1 , 1 , 0.9 ]])

如果您只打算绘制验证曲线,则类 ValidationCurveDisplay 比手动使用 matplotlib 处理对 validation_curve 的调用结果更直接。您可以像使用 validation_curve 一样使用方法 from_estimator 来生成和绘制验证曲线

from sklearn.datasets import load_iris

from sklearn.model_selection import ValidationCurveDisplay

from sklearn.svm import SVC

from sklearn.utils import shuffle

X, y = load_iris(return_X_y=True)

X, y = shuffle(X, y, random_state=0)

ValidationCurveDisplay.from_estimator(

SVC(kernel="linear"), X, y, param_name="C", param_range=np.logspace(-7, 3, 10)

)

如果训练分数和验证分数都很低,则估计器将欠拟合。如果训练分数高而验证分数低,则估计器过拟合;否则它工作得非常好。低训练分数和高验证分数通常是不可能的。

3.5.2. 学习曲线#

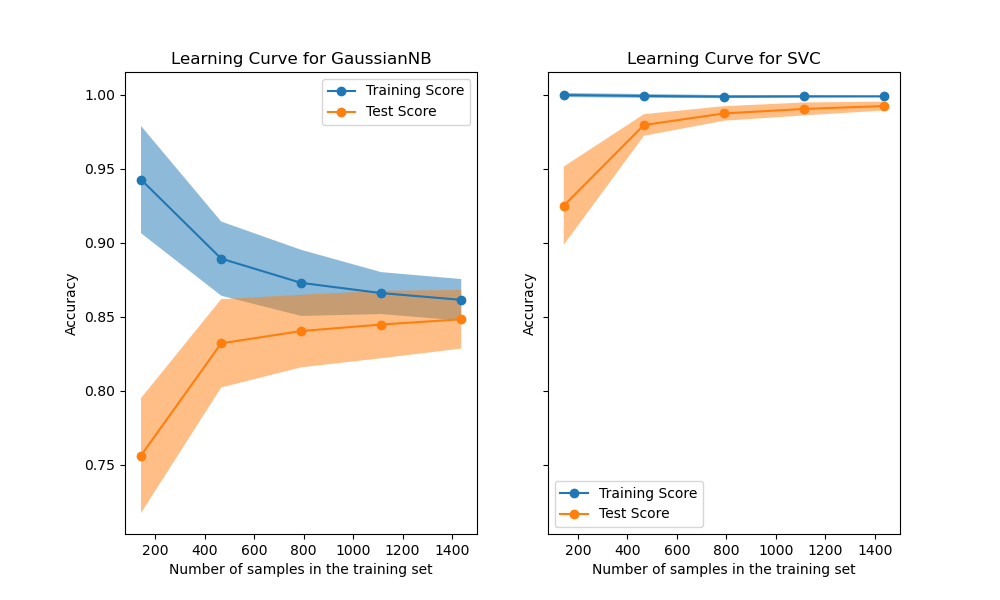

学习曲线显示了估计器在不同数量训练样本下的验证分数和训练分数。它是一种工具,用于找出增加更多训练数据能带来多少好处,以及估计器是受方差误差还是偏差误差的影响更大。考虑下面的示例,我们绘制了朴素贝叶斯分类器和 SVM 的学习曲线。

对于朴素贝叶斯,随着训练集大小的增加,验证分数和训练分数都收敛到一个相当低的值。因此,我们可能不会从更多的训练数据中受益太多。

相比之下,对于少量数据,SVM 的训练分数远大于验证分数。增加更多的训练样本很可能会提高泛化能力。

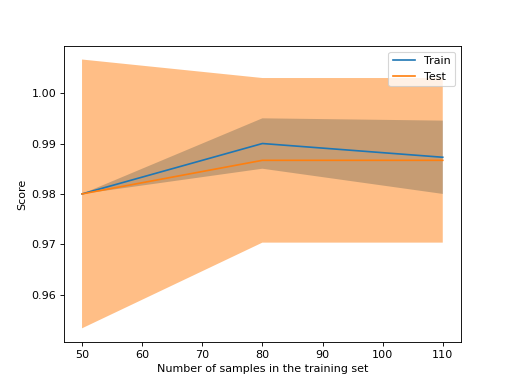

我们可以使用函数 learning_curve 来生成绘制此类学习曲线所需的值(已使用的样本数、训练集上的平均分数和验证集上的平均分数)

>>> from sklearn.model_selection import learning_curve

>>> from sklearn.svm import SVC

>>> train_sizes, train_scores, valid_scores = learning_curve(

... SVC(kernel='linear'), X, y, train_sizes=[50, 80, 110], cv=5)

>>> train_sizes

array([ 50, 80, 110])

>>> train_scores

array([[0.98, 0.98 , 0.98, 0.98, 0.98],

[0.98, 1. , 0.98, 0.98, 0.98],

[0.98, 1. , 0.98, 0.98, 0.99]])

>>> valid_scores

array([[1. , 0.93, 1. , 1. , 0.96],

[1. , 0.96, 1. , 1. , 0.96],

[1. , 0.96, 1. , 1. , 0.96]])

如果您只打算绘制学习曲线,则类 LearningCurveDisplay 将更容易使用。您可以像使用 learning_curve 一样使用方法 from_estimator 来生成和绘制学习曲线

from sklearn.datasets import load_iris

from sklearn.model_selection import LearningCurveDisplay

from sklearn.svm import SVC

from sklearn.utils import shuffle

X, y = load_iris(return_X_y=True)

X, y = shuffle(X, y, random_state=0)

LearningCurveDisplay.from_estimator(

SVC(kernel="linear"), X, y, train_sizes=[50, 80, 110], cv=5)

示例

请参阅 绘制学习曲线并检查模型的扩展性,了解使用学习曲线检查预测模型扩展性的示例。