OAS#

- class sklearn.covariance.OAS(*, store_precision=True, assume_centered=False)[source]#

Oracle Approximating Shrinkage 估计器。

更多信息请参见用户指南。

- 参数:

- store_precisionbool,默认为 True

指定是否存储估计的精度。

- assume_centeredbool,默认为 False

如果为 True,数据在计算前将不进行中心化处理。当处理均值接近但不完全为零的数据时,此参数很有用。如果为 False(默认),数据在计算前将进行中心化处理。

- 属性:

- covariance_形状为 (n_features, n_features) 的 ndarray

估计的协方差矩阵。

- location_形状为 (n_features,) 的 ndarray

估计的位置,即估计的均值。

- precision_形状为 (n_features, n_features) 的 ndarray

估计的伪逆矩阵。(仅当 store_precision 为 True 时存储)

- shrinkage_float

用于计算收缩估计的凸组合中的系数。范围为 [0, 1]。

- n_features_in_int

在拟合 (fit) 过程中所见的特征数量。

0.24 版本新增。

- feature_names_in_形状为 (

n_features_in_,) 的 ndarray 在拟合 (fit) 过程中所见的特征名称。仅当

X的所有特征名称均为字符串时定义。1.0 版本新增。

另请参见

EllipticEnvelope一个用于检测高斯分布数据集中异常值的对象。

EmpiricalCovariance最大似然协方差估计器。

GraphicalLasso使用 l1 惩罚估计器进行稀疏逆协方差估计。

GraphicalLassoCV通过交叉验证选择 l1 惩罚的稀疏逆协方差。

LedoitWolfLedoitWolf 估计器。

MinCovDet最小协方差行列式(协方差的鲁棒估计器)。

ShrunkCovariance带收缩的协方差估计器。

备注

正则化协方差为

(1 - shrinkage) * cov + shrinkage * mu * np.identity(n_features),

其中 mu = trace(cov) / n_features,shrinkage 由 OAS 公式给出(参见 [1])。

此处实现的收缩公式与[1]中的公式 23 不同。在原始文章中,公式 (23) 指出,分子和分母中都乘以 2/p(p 是特征数量)乘以 Trace(cov*cov),但此操作被省略了,因为对于较大的 p,2/p 的值非常小,以至于它不影响估计器的值。

参考文献

示例

>>> import numpy as np >>> from sklearn.covariance import OAS >>> from sklearn.datasets import make_gaussian_quantiles >>> real_cov = np.array([[.8, .3], ... [.3, .4]]) >>> rng = np.random.RandomState(0) >>> X = rng.multivariate_normal(mean=[0, 0], ... cov=real_cov, ... size=500) >>> oas = OAS().fit(X) >>> oas.covariance_ array([[0.7533, 0.2763], [0.2763, 0.3964]]) >>> oas.precision_ array([[ 1.7833, -1.2431 ], [-1.2431, 3.3889]]) >>> oas.shrinkage_ np.float64(0.0195)

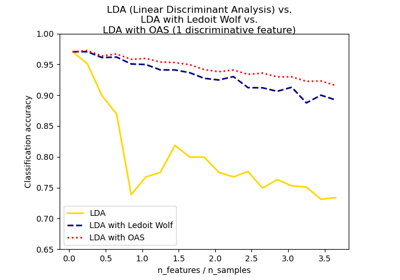

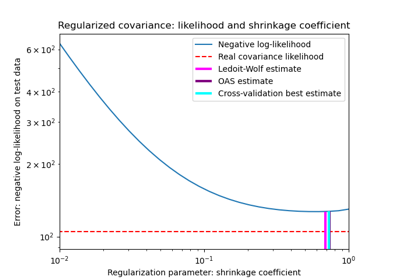

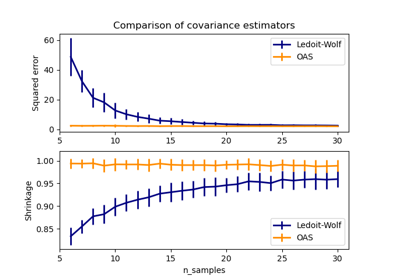

有关更详细的示例,另请参见 收缩协方差估计:LedoitWolf 与 OAS 和最大似然 和 Ledoit-Wolf 与 OAS 估计。

- error_norm(comp_cov, norm='frobenius', scaling=True, squared=True)[source]#

计算两个协方差估计器之间的均方误差。

- 参数:

- comp_cov形状为 (n_features, n_features) 的类数组

用于比较的协方差。

- norm{“frobenius”, “spectral”},默认为 “frobenius”

用于计算误差的范数类型。可用的误差类型:- 'frobenius'(默认):sqrt(tr(A^t.A)) - 'spectral':sqrt(max(eigenvalues(A^t.A)),其中 A 是误差

(comp_cov - self.covariance_)。- scalingbool,默认为 True

如果为 True(默认),则均方误差范数将除以 n_features。如果为 False,则均方误差范数不进行重新缩放。

- squaredbool,默认为 True

是否计算均方误差范数或误差范数。如果为 True(默认),则返回均方误差范数。如果为 False,则返回误差范数。

- 返回:

- resultfloat

self和comp_cov协方差估计器之间的均方误差(Frobenius 范数意义上的)。

- fit(X, y=None)[source]#

将 Oracle Approximating Shrinkage 协方差模型拟合到 X。

- 参数:

- X形状为 (n_samples, n_features) 的类数组

训练数据,其中

n_samples是样本数量,n_features是特征数量。- y忽略

不使用,按约定为保持 API 一致性而存在。

- 返回:

- self对象

返回实例本身。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查看用户指南,了解路由机制的工作原理。

- 返回:

- routingMetadataRequest

一个封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool,默认为 True

如果为 True,将返回此估计器以及所包含的作为估计器的子对象的参数。

- 返回:

- paramsdict

参数名称及其对应值的映射。

- mahalanobis(X)[source]#

计算给定观测值的马哈拉诺比斯距离平方。

- 参数:

- X形状为 (n_samples, n_features) 的类数组

我们计算其马哈拉诺比斯距离的观测值。观测值被假定来自与拟合数据相同的分布。

- 返回:

- dist形状为 (n_samples,) 的 ndarray

观测值的马哈拉诺比斯距离平方。

- score(X_test, y=None)[source]#

计算估计高斯模型下

X_test的对数似然。高斯模型由其均值和协方差矩阵定义,分别由

self.location_和self.covariance_表示。- 参数:

- X_test形状为 (n_samples, n_features) 的类数组

用于计算似然的测试数据,其中

n_samples是样本数量,n_features是特征数量。X_test假定与拟合数据(包括中心化)来自相同的分布。- y忽略

不使用,按约定为保持 API 一致性而存在。

- 返回:

- resfloat

在

self.location_和self.covariance_分别作为高斯模型均值和协方差矩阵的估计器时,X_test的对数似然。