TruncatedSVD#

- class sklearn.decomposition.TruncatedSVD(n_components=2, *, algorithm='randomized', n_iter=5, n_oversamples=10, power_iteration_normalizer='auto', random_state=None, tol=0.0)[source]#

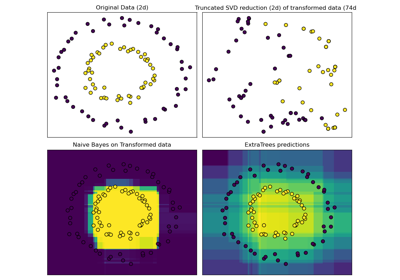

使用截断SVD(亦称LSA)进行降维。

此转换器通过截断奇异值分解(SVD)执行线性降维。与PCA不同,此估计器在计算奇异值分解之前不对数据进行中心化。这意味着它可以高效地处理稀疏矩阵。

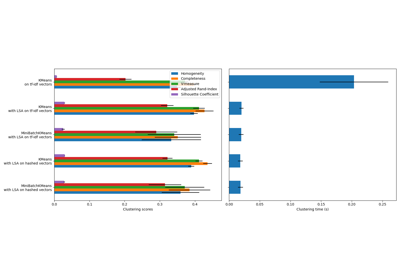

特别是,截断SVD适用于`sklearn.feature_extraction.text`中向量化器返回的词频/tf-idf矩阵。在这种情况下,它被称为潜在语义分析(LSA)。

此估计器支持两种算法:一种是快速随机SVD求解器,另一种是“朴素”算法,它使用ARPACK作为`X * X.T`或`X.T * X`(取其中更高效者)的特征求解器。

请参阅用户指南了解更多信息。

- 参数:

- n_componentsint, default=2

输出数据的目标维度。如果算法为’arpack’,则必须严格小于特征数量。如果算法为’randomized’,则必须小于或等于特征数量。默认值对于可视化很有用。对于LSA,建议值为100。

- algorithm{‘arpack’, ‘randomized’}, default=’randomized’

要使用的SVD求解器。可以是SciPy中ARPACK包装器(scipy.sparse.linalg.svds)的“arpack”,或者Halko(2009)提出的随机算法的“randomized”。

- n_iterint, default=5

随机SVD求解器的迭代次数。ARPACK不使用此参数。默认值大于

randomized_svd中的默认值,以处理可能具有缓慢衰减大谱的稀疏矩阵。- n_oversamplesint, default=10

随机SVD求解器的过采样数量。ARPACK不使用此参数。有关完整说明,请参阅

randomized_svd。在 1.1 版本中新增。

- power_iteration_normalizer{‘auto’, ‘QR’, ‘LU’, ‘none’}, default=’auto’

随机SVD求解器的幂迭代归一化器。ARPACK不使用此参数。有关更多详细信息,请参阅

randomized_svd。在 1.1 版本中新增。

- random_stateint, RandomState instance or None, default=None

在随机SVD期间使用。传递一个整数可在多次函数调用中获得可重现的结果。请参阅术语表。

- tolfloat, default=0.0

ARPACK的容差。0表示机器精度。随机SVD求解器忽略此参数。

- 属性:

- components_形状为 (n_components, n_features) 的ndarray

输入数据的右奇异向量。

- explained_variance_形状为 (n_components,) 的ndarray

训练样本经过投影到每个分量后的方差。

- explained_variance_ratio_形状为 (n_components,) 的ndarray

每个选定分量解释的方差百分比。

- singular_values_形状为 (n_components,) 的ndarray

与每个选定分量对应的奇异值。奇异值等于低维空间中`n_components`变量的2-范数。

- n_features_in_int

在fit期间看到的特征数量。

在 0.24 版本中新增。

- feature_names_in_形状为 (`n_features_in_`,) 的str对象ndarray

在fit期间看到的特征名称。仅当`X`的所有特征名称均为字符串时定义。

在 1.0 版本中新增。

另请参阅

DictionaryLearning查找稀疏编码数据的字典。

FactorAnalysis一个具有高斯潜在变量的简单线性生成模型。

IncrementalPCA增量主成分分析。

KernelPCA核主成分分析。

NMF非负矩阵分解。

PCA主成分分析。

备注

SVD存在一个被称为“符号不确定性”的问题,这意味着`components_`的符号以及变换的输出取决于算法和随机状态。为了解决这个问题,请将此类的实例一次性拟合到数据,然后保留该实例以进行后续变换。

参考文献

示例

>>> from sklearn.decomposition import TruncatedSVD >>> from scipy.sparse import csr_matrix >>> import numpy as np >>> np.random.seed(0) >>> X_dense = np.random.rand(100, 100) >>> X_dense[:, 2 * np.arange(50)] = 0 >>> X = csr_matrix(X_dense) >>> svd = TruncatedSVD(n_components=5, n_iter=7, random_state=42) >>> svd.fit(X) TruncatedSVD(n_components=5, n_iter=7, random_state=42) >>> print(svd.explained_variance_ratio_) [0.0157 0.0512 0.0499 0.0479 0.0453] >>> print(svd.explained_variance_ratio_.sum()) 0.2102 >>> print(svd.singular_values_) [35.2410 4.5981 4.5420 4.4486 4.3288]

- fit(X, y=None)[source]#

在训练数据 X 上拟合模型。

- 参数:

- X形状为 (n_samples, n_features) 的{array-like, 稀疏矩阵}

训练数据。

- y忽略

未使用,按惯例在此处是为了API一致性。

- 返回:

- self对象

返回转换器对象。

- fit_transform(X, y=None)[source]#

将模型拟合到X并在X上执行降维。

- 参数:

- X形状为 (n_samples, n_features) 的{array-like, 稀疏矩阵}

训练数据。

- y忽略

未使用,按惯例在此处是为了API一致性。

- 返回:

- X_new形状为 (n_samples, n_components) 的ndarray

X的降维版本。这将始终是一个密集数组。

- get_feature_names_out(input_features=None)[source]#

获取变换的输出特征名称。

输出特征名称将以小写类名作为前缀。例如,如果转换器输出3个特征,则输出特征名称为:`["class_name0", "class_name1", "class_name2"]`。

- 参数:

- input_featuresstr或None的array-like, default=None

仅用于验证特征名称与`fit`中看到的名称。

- 返回:

- feature_names_outstr对象的ndarray

转换后的特征名称。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查看用户指南了解路由机制的工作原理。

- 返回:

- routingMetadataRequest

封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool, default=True

如果为True,将返回此估计器及其包含的作为估计器的子对象的参数。

- 返回:

- paramsdict

参数名称映射到其值。

- inverse_transform(X)[source]#

将X变换回其原始空间。

返回一个数组 X_original,其变换结果为X。

- 参数:

- X形状为 (n_samples, n_components) 的array-like

新数据。

- 返回:

- X_original形状为 (n_samples, n_features) 的ndarray

请注意,这始终是一个密集数组。

- set_output(*, transform=None)[source]#

设置输出容器。

请参阅引入set_output API以获取如何使用该API的示例。

- 参数:

- transform{“default”, “pandas”, “polars”}, default=None

配置`transform`和`fit_transform`的输出。

"default": 转换器的默认输出格式"pandas": DataFrame 输出"polars": Polars 输出None: 变换配置保持不变

在 1.4 版本中新增: 添加了

"polars"选项。

- 返回:

- self估计器实例

估计器实例。