RandomForestClassifier#

- class sklearn.ensemble.RandomForestClassifier(n_estimators=100, *, criterion='gini', max_depth=None, min_samples_split=2, min_samples_leaf=1, min_weight_fraction_leaf=0.0, max_features='sqrt', max_leaf_nodes=None, min_impurity_decrease=0.0, bootstrap=True, oob_score=False, n_jobs=None, random_state=None, verbose=0, warm_start=False, class_weight=None, ccp_alpha=0.0, max_samples=None, monotonic_cst=None)[source]#

一个随机森林分类器。

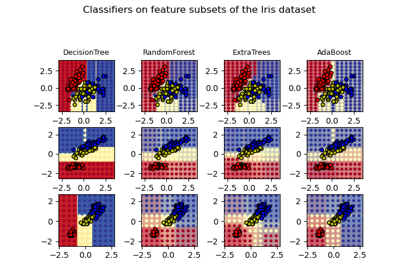

随机森林是一种元估计器,它在数据集的各种子样本上拟合多个决策树分类器,并使用平均值来提高预测准确性并控制过拟合。森林中的树使用最佳分裂策略,即等效于向底层

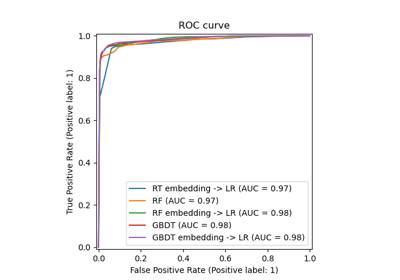

DecisionTreeClassifier传递splitter="best"。如果bootstrap=True(默认),子样本大小由max_samples参数控制,否则使用整个数据集来构建每棵树。关于基于树的集成模型的比较,请参见示例 比较随机森林和直方图梯度提升模型。

此估计器原生支持缺失值(NaNs)。在训练期间,树生长器根据潜在增益,在每个分裂点学习具有缺失值的样本应该进入左子节点还是右子节点。在预测时,具有缺失值的样本相应地分配给左子节点或右子节点。如果在训练期间给定特征没有遇到缺失值,则具有缺失值的样本将映射到具有最多样本的子节点。

在 用户指南 中了解更多信息。

- 参数:

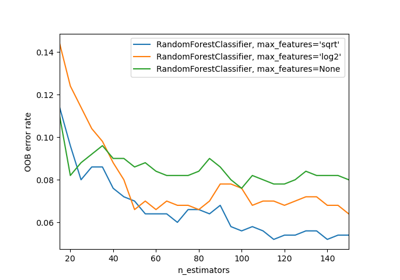

- n_estimatorsint, 默认=100

森林中的树木数量。

0.22 版本中的更改:

n_estimators的默认值在 0.22 版本中从 10 更改为 100。- criterion{“gini”, “entropy”, “log_loss”}, 默认=”gini”

用于衡量分裂质量的函数。支持的标准包括用于基尼不纯度的“gini”,以及用于香农信息增益的“log_loss”和“entropy”,详见 数学公式。注意:此参数是树特有的。

- max_depthint, 默认=None

树的最大深度。如果为 None,则节点会一直扩展,直到所有叶子节点都是纯的,或者直到所有叶子节点包含的样本少于 min_samples_split 样本。

- min_samples_splitint 或 float, 默认=2

分裂内部节点所需的最小样本数

如果为 int,则将

min_samples_split视为最小数量。如果为 float,则

min_samples_split是一个比例,并且ceil(min_samples_split * n_samples)是每次分裂的最小样本数。

0.18 版本中的更改: 添加了浮点值以表示比例。

- min_samples_leafint 或 float, 默认=1

叶子节点所需的最小样本数。只有当分裂点在左右分支中都至少保留

min_samples_leaf个训练样本时,才会考虑任意深度的分裂点。这可能具有平滑模型的效果,尤其是在回归中。如果为 int,则将

min_samples_leaf视为最小数量。如果为 float,则

min_samples_leaf是一个比例,并且ceil(min_samples_leaf * n_samples)是每个节点的最小样本数。

0.18 版本中的更改: 添加了浮点值以表示比例。

- min_weight_fraction_leaffloat, 默认=0.0

叶子节点所需的(所有输入样本)总权重和的最小加权分数。未提供 sample_weight 时,样本权重相等。

- max_features{“sqrt”, “log2”, None}, int 或 float, 默认=”sqrt”

寻找最佳分裂时要考虑的特征数量

如果为 int,则在每次分裂时考虑

max_features个特征。如果为 float,则

max_features是一个比例,并且在每次分裂时考虑max(1, int(max_features * n_features_in_))个特征。如果为 “sqrt”,则

max_features=sqrt(n_features)。如果为 “log2”,则

max_features=log2(n_features)。如果为 None,则

max_features=n_features。

1.1 版本中的更改:

max_features的默认值从"auto"更改为"sqrt"。注意:分裂搜索不会停止,直到找到至少一个有效的节点样本分区,即使这需要有效地检查超过

max_features个特征。- max_leaf_nodesint, 默认=None

以最佳优先方式生长树,使其具有

max_leaf_nodes。最佳节点定义为不纯度的相对减少。如果为 None,则叶子节点数量不受限制。- min_impurity_decreasefloat, 默认=0.0

如果分裂导致不纯度减少大于或等于此值,则节点将被分裂。

加权不纯度减少公式如下

N_t / N * (impurity - N_t_R / N_t * right_impurity - N_t_L / N_t * left_impurity)

其中

N是样本总数,N_t是当前节点的样本数,N_t_L是左子节点中的样本数,N_t_R是右子节点中的样本数。如果传递了

sample_weight,则N、N_t、N_t_R和N_t_L都指加权和。0.19 版本新增。

- bootstrapbool, 默认=True

构建树时是否使用 bootstrap 样本。如果为 False,则使用整个数据集构建每棵树。

- oob_scorebool 或 callable, 默认=False

是否使用袋外 (out-of-bag) 样本来估计泛化分数。默认情况下,使用

accuracy_score。提供一个签名为metric(y_true, y_pred)的可调用对象以使用自定义度量。仅当bootstrap=True时可用。- n_jobsint, 默认=None

并行运行的作业数量。

fit、predict、decision_path和apply都在树上并行化。None表示 1,除非在joblib.parallel_backend上下文中。-1表示使用所有处理器。有关更多详细信息,请参见 术语表。- random_stateint, RandomState 实例或 None, 默认=None

控制构建树时使用的样本引导(如果

bootstrap=True)的随机性,以及在每个节点寻找最佳分裂时要考虑的特征的抽样(如果max_features < n_features)。有关详细信息,请参见 术语表。- verboseint, 默认=0

控制拟合和预测时的详细程度。

- warm_startbool, 默认=False

设置为

True时,重用上次调用 fit 的解决方案并向集成中添加更多估计器,否则,将拟合一个全新的森林。有关详细信息,请参见 术语表 和 拟合额外的树。- class_weight{“balanced”, “balanced_subsample”}, dict 或 dict 列表, 默认=None

与类别相关的权重,形式为

{class_label: weight}。如果未给出,则所有类别都被认为权重为一。对于多输出问题,可以按照 y 的列的相同顺序提供 dict 列表。请注意,对于多输出(包括多标签)问题,每个列的每个类别的权重都应在其各自的 dict 中定义。例如,对于四类多标签分类,权重应为 [{0: 1, 1: 1}, {0: 1, 1: 5}, {0: 1, 1: 1}, {0: 1, 1: 1}] 而不是 [{1:1}, {2:5}, {3:1}, {4:1}]。

“balanced” 模式使用 y 的值自动调整权重,使其与输入数据中的类别频率成反比,计算公式为

n_samples / (n_classes * np.bincount(y))“balanced_subsample” 模式与 “balanced” 相同,但权重是根据每棵生长树的 bootstrap 样本计算的。

对于多输出,y 的每列的权重将相乘。

请注意,如果指定了 sample_weight,这些权重将与 sample_weight(通过 fit 方法传递)相乘。

- ccp_alpha非负浮点数, 默认=0.0

用于最小成本复杂度剪枝的复杂度参数。将选择成本复杂度最大但小于

ccp_alpha的子树。默认情况下不执行剪枝。有关详细信息,请参见 最小成本复杂度剪枝。有关此类剪枝的示例,请参见 使用成本复杂度剪枝后剪枝决策树。0.22 版本新增。

- max_samplesint 或 float, 默认=None

如果 bootstrap 为 True,则从 X 中抽取样本以训练每个基础估计器的数量。

如果为 None(默认),则抽取

X.shape[0]个样本。如果为 int,则抽取

max_samples个样本。如果为 float,则抽取

max(round(n_samples * max_samples), 1)个样本。因此,max_samples应该在区间(0.0, 1.0]内。

0.22 版本新增。

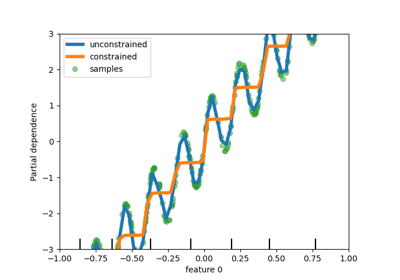

- monotonic_cst形状为 (n_features) 的 int 数组,默认=None

- 指示对每个特征施加的单调性约束。

1: 单调递增

0: 无约束

-1: 单调递减

如果 monotonic_cst 为 None,则不应用任何约束。

- 不支持单调性约束的情形:

多类别分类(即当

n_classes > 2时),多输出分类(即当

n_outputs_ > 1时),在具有缺失值的数据上训练的分类。

这些约束适用于正类的概率。

在 用户指南 中了解更多信息。

1.4 版本新增。

- 属性:

- estimator_

DecisionTreeClassifier 用于创建拟合子估计器集合的子估计器模板。

1.2 版本新增:

base_estimator_已重命名为estimator_。- estimators_DecisionTreeClassifier 列表

拟合的子估计器集合。

- classes_形状为 (n_classes,) 的 ndarray 或此类数组的列表

类别标签(单输出问题),或类别标签数组列表(多输出问题)。

- n_classes_int 或 list

类别数量(单输出问题),或包含每个输出的类别数量的列表(多输出问题)。

- n_features_in_int

在 拟合 期间看到的特征数量。

0.24 版本新增。

- feature_names_in_形状为 (

n_features_in_,) 的 ndarray 在 拟合 期间看到的特征名称。仅当

X的所有特征名称都是字符串时才定义。1.0 版本新增。

- n_outputs_int

执行

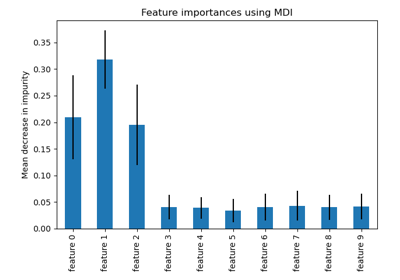

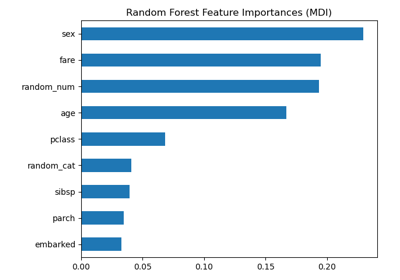

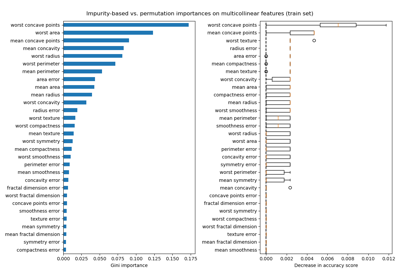

fit时输出的数量。feature_importances_形状为 (n_features,) 的 ndarray基于不纯度的特征重要性。

- oob_score_float

使用袋外估计获得的训练数据集分数。此属性仅当

oob_score为 True 时存在。- oob_decision_function_形状为 (n_samples, n_classes) 或 (n_samples, n_classes, n_outputs) 的 ndarray

使用训练集上的袋外估计计算的决策函数。如果 n_estimators 很小,可能存在数据点在 bootstrap 期间从未被排除在外的情况。在这种情况下,

oob_decision_function_可能包含 NaN。此属性仅当oob_score为 True 时存在。estimators_samples_数组列表每个基础估计器抽取的样本子集。

- estimator_

另请参阅

sklearn.tree.DecisionTreeClassifier一个决策树分类器。

sklearn.ensemble.ExtraTreesClassifier高度随机树分类器的集成。

sklearn.ensemble.HistGradientBoostingClassifier一种基于直方图的梯度提升分类树,对于大型数据集(n_samples >= 10_000)非常快。

注意

控制树大小的参数(例如

max_depth、min_samples_leaf等)的默认值会导致树完全生长且未经剪枝,这在某些数据集上可能变得非常大。为了减少内存消耗,应通过设置这些参数值来控制树的复杂性和大小。特征在每次分裂时总是随机排列的。因此,即使训练数据相同,且

max_features=n_features和bootstrap=False,如果在搜索最佳分裂期间列举的几个分裂的准则改进相同,则找到的最佳分裂可能有所不同。为了在拟合期间获得确定性行为,必须固定random_state。参考文献

[1]Breiman, “Random Forests”, Machine Learning, 45(1), 5-32, 2001.

示例

>>> from sklearn.ensemble import RandomForestClassifier >>> from sklearn.datasets import make_classification >>> X, y = make_classification(n_samples=1000, n_features=4, ... n_informative=2, n_redundant=0, ... random_state=0, shuffle=False) >>> clf = RandomForestClassifier(max_depth=2, random_state=0) >>> clf.fit(X, y) RandomForestClassifier(...) >>> print(clf.predict([[0, 0, 0, 0]])) [1]

- apply(X)[source]#

将森林中的树应用于 X,返回叶子索引。

- 参数:

- X形状为 (n_samples, n_features) 的 {array-like, 稀疏矩阵}

输入样本。在内部,其 dtype 将转换为

dtype=np.float32。如果提供了稀疏矩阵,它将被转换为稀疏csr_matrix。

- 返回:

- X_leaves形状为 (n_samples, n_estimators) 的 ndarray

对于 X 中的每个数据点 x 和森林中的每棵树,返回 x 最终所在的叶子索引。

- decision_path(X)[source]#

返回森林中的决策路径。

0.18 版本新增。

- 参数:

- X形状为 (n_samples, n_features) 的 {array-like, 稀疏矩阵}

输入样本。在内部,其 dtype 将转换为

dtype=np.float32。如果提供了稀疏矩阵,它将被转换为稀疏csr_matrix。

- 返回:

- indicator形状为 (n_samples, n_nodes) 的稀疏矩阵

返回一个节点指示矩阵,其中非零元素表示样本通过这些节点。该矩阵为 CSR 格式。

- n_nodes_ptr形状为 (n_estimators + 1,) 的 ndarray

来自 indicator[n_nodes_ptr[i]:n_nodes_ptr[i+1]] 的列给出第 i 个估计器的指示值。

- fit(X, y, sample_weight=None)[source]#

从训练集 (X, y) 构建一个树的森林。

- 参数:

- X形状为 (n_samples, n_features) 的 {array-like, 稀疏矩阵}

训练输入样本。在内部,其 dtype 将转换为

dtype=np.float32。如果提供了稀疏矩阵,它将被转换为稀疏csc_matrix。- y形状为 (n_samples,) 或 (n_samples, n_outputs) 的 array-like

目标值(分类中的类别标签,回归中的实数)。

- sample_weight形状为 (n_samples,) 的 array-like, 默认=None

样本权重。如果为 None,则样本权重相等。在每个节点搜索分裂时,将忽略会创建净零或负权重子节点的分裂。在分类情况下,如果分裂会导致任何单个类在任一子节点中带有负权重,也将忽略该分裂。

- 返回:

- self对象

已拟合的估计器。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查看 用户指南 以了解路由机制的工作原理。

- 返回:

- routingMetadataRequest

一个封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool, 默认=True

如果为 True,将返回此估计器及其包含的作为估计器的子对象的参数。

- 返回:

- paramsdict

参数名称及其对应的值。

- predict(X)[source]#

预测 X 的类别。

输入样本的预测类别是森林中各树的投票,并由它们的概率估计加权。也就是说,预测类别是所有树中平均概率估计最高的那个。

- 参数:

- X形状为 (n_samples, n_features) 的 {array-like, 稀疏矩阵}

输入样本。在内部,其 dtype 将转换为

dtype=np.float32。如果提供了稀疏矩阵,它将被转换为稀疏csr_matrix。

- 返回:

- y形状为 (n_samples,) 或 (n_samples, n_outputs) 的 ndarray

预测的类别。

- predict_log_proba(X)[source]#

预测 X 的类别对数概率。

输入样本的预测类别对数概率计算为森林中树的平均预测类别概率的对数。

- 参数:

- X形状为 (n_samples, n_features) 的 {array-like, 稀疏矩阵}

输入样本。在内部,其 dtype 将转换为

dtype=np.float32。如果提供了稀疏矩阵,它将被转换为稀疏csr_matrix。

- 返回:

- p形状为 (n_samples, n_classes) 的 ndarray,或此类数组的列表

输入样本的类别概率。类别的顺序与属性 classes_ 中的顺序一致。

- predict_proba(X)[source]#

预测 X 的类别概率。

输入样本的预测类别概率计算为森林中树的平均预测类别概率。单棵树的类别概率是叶子中属于同一类别的样本的比例。

- 参数:

- X形状为 (n_samples, n_features) 的 {array-like, 稀疏矩阵}

输入样本。在内部,其 dtype 将转换为

dtype=np.float32。如果提供了稀疏矩阵,它将被转换为稀疏csr_matrix。

- 返回:

- p形状为 (n_samples, n_classes) 的 ndarray,或此类数组的列表

输入样本的类别概率。类别的顺序与属性 classes_ 中的顺序一致。

- score(X, y, sample_weight=None)[source]#

返回给定数据和标签的 准确率。

在多标签分类中,这是子集准确率,它是一个严苛的度量标准,因为它要求每个样本的每个标签集都必须被正确预测。

- 参数:

- X形状为 (n_samples, n_features) 的 array-like

测试样本。

- y形状为 (n_samples,) 或 (n_samples, n_outputs) 的 array-like

X的真实标签。- sample_weight形状为 (n_samples,) 的 array-like, 默认=None

样本权重。

- 返回:

- scorefloat

self.predict(X)相对于y的平均准确率。

- set_fit_request(*, sample_weight: bool | None | str = '$UNCHANGED$') RandomForestClassifier[source]#

请求传递给

fit方法的元数据。请注意,此方法仅当

enable_metadata_routing=True时才相关(参见sklearn.set_config)。请参阅 用户指南 以了解路由机制的工作原理。每个参数的选项是

True: 请求元数据,如果提供,则传递给fit。如果未提供元数据,则请求被忽略。False: 不请求元数据,元估计器不会将其传递给fit。None: 不请求元数据,如果用户提供元数据,元估计器将引发错误。str: 应将元数据以给定别名而非原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求,而不更改其他参数的请求。1.3 版本新增。

注意

此方法仅当此估计器用作元估计器的子估计器时才相关,例如在

Pipeline中使用时。否则,它没有效果。- 参数:

- sample_weightstr, True, False 或 None, 默认=sklearn.utils.metadata_routing.UNCHANGED

fit方法中sample_weight参数的元数据路由。

- 返回:

- self对象

更新后的对象。

- set_params(**params)[source]#

设置此估计器的参数。

此方法适用于简单的估计器以及嵌套对象(例如

Pipeline)。后者具有<component>__<parameter>形式的参数,以便可以更新嵌套对象的每个组件。- 参数:

- **paramsdict

估计器参数。

- 返回:

- self估计器实例

估计器实例。

- set_score_request(*, sample_weight: bool | None | str = '$UNCHANGED$') RandomForestClassifier[source]#

请求传递给

score方法的元数据。请注意,此方法仅当

enable_metadata_routing=True时才相关(参见sklearn.set_config)。请参阅 用户指南 以了解路由机制的工作原理。每个参数的选项是

True: 请求元数据,如果提供,则传递给score。如果未提供元数据,则请求被忽略。False: 不请求元数据,元估计器不会将其传递给score。None: 不请求元数据,如果用户提供元数据,元估计器将引发错误。str: 应将元数据以给定别名而非原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求,而不更改其他参数的请求。1.3 版本新增。

注意

此方法仅当此估计器用作元估计器的子估计器时才相关,例如在

Pipeline中使用时。否则,它没有效果。- 参数:

- sample_weightstr, True, False 或 None, 默认=sklearn.utils.metadata_routing.UNCHANGED

score方法中sample_weight参数的元数据路由。

- 返回:

- self对象

更新后的对象。