MiniBatchSparsePCA#

- class sklearn.decomposition.MiniBatchSparsePCA(n_components=None, *, alpha=1, ridge_alpha=0.01, max_iter=1000, callback=None, batch_size=3, verbose=False, shuffle=True, n_jobs=None, method='lars', random_state=None, tol=0.001, max_no_improvement=10)[source]#

小批量稀疏主成分分析。

找到一组可以最优地重建数据的稀疏分量。稀疏程度可通过L1惩罚项的系数(由参数alpha给出)进行控制。

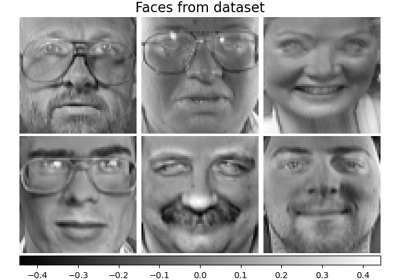

有关稀疏PCA与PCA比较的示例,请参阅 人脸数据集分解

在 用户指南 中阅读更多内容。

- 参数:

- n_components整型, 默认为None

要提取的稀疏原子的数量。如果为 None,则

n_components将设置为n_features。- alpha整型, 默认为1

稀疏性控制参数。值越高,分量越稀疏。

- ridge_alpha浮点型, 默认为0.01

在调用转换方法时,为改善条件而应用的岭收缩量。

- max_iter整型, 默认为1_000

在独立于任何早期停止准则启发式方法之外,对整个数据集进行迭代的最大次数。

1.2 版本新增。

- callback可调用对象, 默认为None

每五次迭代调用一次的回调函数。

- batch_size整型, 默认为3

每个小批量中包含的特征数量。

- verbose整型或布尔型, 默认为False

控制详细程度;值越高,消息越多。默认为0。

- shuffle布尔型, 默认为True

在将数据分成批次之前是否进行洗牌。

- n_jobs整型, 默认为None

要运行的并行作业数。

None表示 1,除非在joblib.parallel_backend上下文中。-1表示使用所有处理器。有关更多详细信息,请参阅 术语表。- method{‘lars’, ‘cd’}, 默认为’lars’

用于优化的方法。lars:使用最小角度回归方法解决lasso问题 (linear_model.lars_path);cd:使用坐标下降方法计算Lasso解 (linear_model.Lasso)。如果估计的分量是稀疏的,Lars 会更快。

- random_state整型, RandomState 实例或None, 默认为None

在在线字典学习期间,当

shuffle设置为True时用于随机洗牌。传入一个整型值以在多次函数调用中获得可重现的结果。参见 术语表。- tol浮点型, 默认为1e-3

根据字典在两个步骤之间的差异范数控制早期停止。

要禁用基于字典变化的早期停止,请将

tol设置为 0.0。1.1 版本新增。

- max_no_improvement整型或None, 默认为10

根据连续未能在平滑成本函数上产生改进的小批量数量控制早期停止。

要禁用基于成本函数的收敛检测,请将

max_no_improvement设置为None。1.1 版本新增。

- 属性:

- components_形状为 (n_components, n_features) 的 ndarray

从数据中提取的稀疏分量。

- n_components_整型

估计的分量数量。

0.23 版本新增。

- n_iter_整型

运行的迭代次数。

- mean_形状为 (n_features,) 的 ndarray

根据训练集估计的每个特征的经验平均值。等于

X.mean(axis=0)。- n_features_in_整型

在 fit 期间见到的特征数量。

0.24 版本新增。

- feature_names_in_形状为 (

n_features_in_,) 的 ndarray 在 fit 期间见到的特征名称。仅当

X的特征名称全部为字符串时才定义。1.0 版本新增。

另请参阅

DictionaryLearning查找稀疏编码数据的字典。

IncrementalPCA增量主成分分析。

PCA主成分分析。

SparsePCA稀疏主成分分析。

TruncatedSVD使用截断SVD进行降维。

示例

>>> import numpy as np >>> from sklearn.datasets import make_friedman1 >>> from sklearn.decomposition import MiniBatchSparsePCA >>> X, _ = make_friedman1(n_samples=200, n_features=30, random_state=0) >>> transformer = MiniBatchSparsePCA(n_components=5, batch_size=50, ... max_iter=10, random_state=0) >>> transformer.fit(X) MiniBatchSparsePCA(...) >>> X_transformed = transformer.transform(X) >>> X_transformed.shape (200, 5) >>> # most values in the components_ are zero (sparsity) >>> np.mean(transformer.components_ == 0) np.float64(0.9)

- fit(X, y=None)[source]#

根据X中的数据拟合模型。

- 参数:

- X形状为 (n_samples, n_features) 的类数组对象

训练向量,其中

n_samples是样本数量,n_features是特征数量。- y忽略

未使用,在此处是为了API一致性约定。

- 返回:

- self对象

返回实例本身。

- fit_transform(X, y=None, **fit_params)[source]#

拟合数据,然后进行转换。

使用可选参数

fit_params将转换器拟合到X和y,并返回X的转换版本。- 参数:

- X形状为 (n_samples, n_features) 的类数组对象

输入样本。

- y形状为 (n_samples,) 或 (n_samples, n_outputs) 的类数组对象, 默认为None

目标值(无监督转换时为 None)。

- **fit_params字典

额外的拟合参数。

- 返回:

- X_new形状为 (n_samples, n_features_new) 的 ndarray 数组

转换后的数组。

- get_feature_names_out(input_features=None)[source]#

获取转换的输出特征名称。

输出特征名称将以小写类名作为前缀。例如,如果转换器输出3个特征,则输出特征名称为:

["class_name0", "class_name1", "class_name2"]。- 参数:

- input_features字符串类数组对象或None, 默认为None

仅用于根据

fit中看到的名称验证特征名称。

- 返回:

- feature_names_out字符串对象的 ndarray

转换后的特征名称。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查阅 用户指南 以了解路由机制的工作原理。

- 返回:

- routingMetadataRequest

一个封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deep布尔型, 默认为True

如果为 True,将返回此估计器及其包含的作为估计器的子对象的参数。

- 返回:

- params字典

参数名称及其对应的值。

- inverse_transform(X)[source]#

将数据从潜在空间转换回原始空间。

这种逆变换是一种近似,因为前向分解会导致信息丢失。

1.2 版本新增。

- 参数:

- X形状为 (n_samples, n_components) 的 ndarray

潜在空间中的数据。

- 返回:

- X_original形状为 (n_samples, n_features) 的 ndarray

在原始空间中重建的数据。

- set_output(*, transform=None)[source]#

设置输出容器。

请参阅 set_output API 介绍,了解如何使用该API的示例。

- 参数:

- transform{“default”, “pandas”, “polars”}, 默认为None

配置

transform和fit_transform的输出。"default": 转换器的默认输出格式"pandas": DataFrame 输出"polars": Polars 输出None: 转换配置不变

1.4 版本新增: 添加了

"polars"选项。

- 返回:

- self估计器实例

估计器实例。