SGDClassifier#

- class sklearn.linear_model.SGDClassifier(loss='hinge', *, penalty='l2', alpha=0.0001, l1_ratio=0.15, fit_intercept=True, max_iter=1000, tol=0.001, shuffle=True, verbose=0, epsilon=0.1, n_jobs=None, random_state=None, learning_rate='optimal', eta0=0.0, power_t=0.5, early_stopping=False, validation_fraction=0.1, n_iter_no_change=5, class_weight=None, warm_start=False, average=False)[source]#

使用 SGD 训练的线性分类器(SVM、逻辑回归等)。

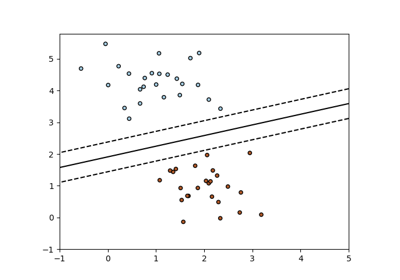

该估计器实现了带有随机梯度下降(SGD)学习的正则化线性模型:损失的梯度一次估计一个样本,模型在训练过程中以递减强度计划(即学习率)更新。SGD 允许通过

partial_fit方法进行小批量(在线/核外)学习。为了使用默认学习率计划获得最佳结果,数据应具有零均值和单位方差。此实现适用于表示为特征的浮点值的密集或稀疏数组的数据。它所拟合的模型可以通过损失参数控制;默认情况下,它拟合一个线性支持向量机(SVM)。

正则化项是添加到损失函数中的一个惩罚,它使用平方欧几里得范数 L2 或绝对范数 L1 或两者的组合(弹性网络)将模型参数收缩到零向量。如果参数更新由于正则化项而超过 0.0 值,则更新将被截断为 0.0,以允许学习稀疏模型并实现在线特征选择。

更多详情请阅读 用户指南。

- 参数:

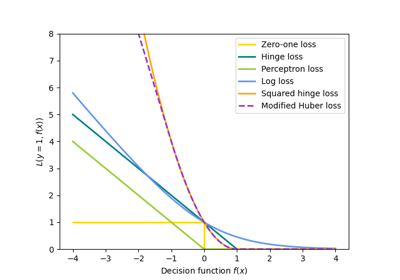

- loss{'hinge', 'log_loss', 'modified_huber', 'squared_hinge', 'perceptron', 'squared_error', 'huber', 'epsilon_insensitive', 'squared_epsilon_insensitive'},默认='hinge'

要使用的损失函数。

'hinge' 给出线性 SVM。

'log_loss' 给出逻辑回归,一个概率分类器。

'modified_huber' 是另一种平滑损失,它既能容忍异常值又能提供概率估计。

'squared_hinge' 类似于 hinge 但受到二次惩罚。

'perceptron' 是感知器算法使用的线性损失。

其他损失,'squared_error'、'huber'、'epsilon_insensitive' 和 'squared_epsilon_insensitive' 是为回归设计的,但也可用于分类;有关说明,请参阅

SGDRegressor。

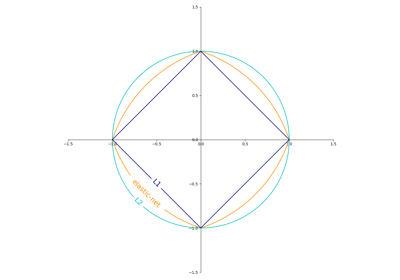

- penalty{'l2', 'l1', 'elasticnet', None},默认='l2'

要使用的惩罚(也称正则化项)。默认为 'l2',这是线性 SVM 模型的标准正则化器。'l1' 和 'elasticnet' 可能会给模型带来 'l2' 无法实现的稀疏性(特征选择)。设置为

None时不添加惩罚。您可以在 SGD:惩罚 中看到惩罚的可视化。

- alpha浮点数,默认=0.0001

乘以正则化项的常数。值越高,正则化越强。当

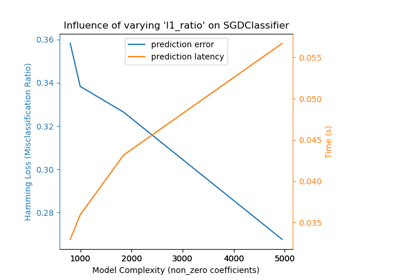

learning_rate设置为 'optimal' 时,也用于计算学习率。值必须在[0.0, inf)范围内。- l1_ratio浮点数,默认=0.15

弹性网络混合参数,0 <= l1_ratio <= 1。l1_ratio=0 对应 L2 惩罚,l1_ratio=1 对应 L1。仅当

penalty为 'elasticnet' 时使用。值必须在[0.0, 1.0]范围内,或者如果penalty不是elasticnet,则可以为None。1.7 版本中的变更: 当

penalty不是 "elasticnet" 时,l1_ratio可以为None。- fit_intercept布尔值,默认=True

是否估计截距。如果为 False,则假定数据已居中。

- max_iter整数,默认=1000

训练数据的最大遍历次数(又称 epochs)。它只影响

fit方法的行为,而不影响partial_fit方法。值必须在[1, inf)范围内。0.19 版本新增。

- tol浮点数或 None,默认=1e-3

停止准则。如果不是 None,当连续

n_iter_no_change个 epochs 的损失都满足 (loss > best_loss - tol) 时,训练将停止。收敛性根据early_stopping参数检查训练损失或验证损失。值必须在[0.0, inf)范围内。0.19 版本新增。

- shuffle布尔值,默认=True

每个 epoch 后是否打乱训练数据。

- verbose整数,默认=0

详细程度。值必须在

[0, inf)范围内。- epsilon浮点数,默认=0.1

epsilon 不敏感损失函数中的 Epsilon;仅当

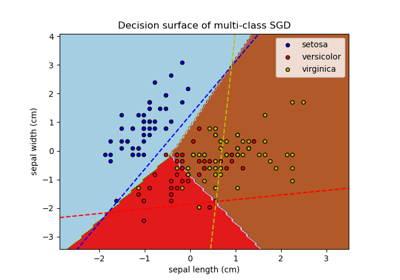

loss为 'huber'、'epsilon_insensitive' 或 'squared_epsilon_insensitive' 时。对于 'huber',它决定了预测准确性变得不那么重要的阈值。对于 epsilon 不敏感,当前预测与正确标签之间的任何差异,如果小于此阈值,则被忽略。值必须在[0.0, inf)范围内。- n_jobs整数,默认=None

用于 OVA(一对多,用于多类别问题)计算的 CPU 数量。

None表示 1,除非在joblib.parallel_backend上下文中。-1表示使用所有处理器。有关详细信息,请参阅术语表。- random_state整数、RandomState 实例,默认=None

当

shuffle设置为True时,用于打乱数据。传入一个整数以在多次函数调用中获得可重现的输出。请参阅术语表。整数值必须在[0, 2**32 - 1]范围内。- learning_rate字符串,默认='optimal'

学习率计划

'constant':

eta = eta0'optimal':

eta = 1.0 / (alpha * (t + t0)),其中t0是由 Leon Bottou 提出的启发式方法选择的。'invscaling':

eta = eta0 / pow(t, power_t)'adaptive':

eta = eta0,只要训练损失持续下降。每次连续 n_iter_no_change 个 epoch 未能将训练损失降低 tol 或未能将验证分数提高 tol(如果early_stopping为True),当前学习率将除以 5。

0.20 版本新增: 添加了 'adaptive' 选项。

- eta0浮点数,默认=0.0

'constant'、'invscaling' 或 'adaptive' 计划的初始学习率。默认值为 0.0,因为默认计划 'optimal' 不使用 eta0。值必须在

[0.0, inf)范围内。- power_t浮点数,默认=0.5

反比例学习率的指数。值必须在

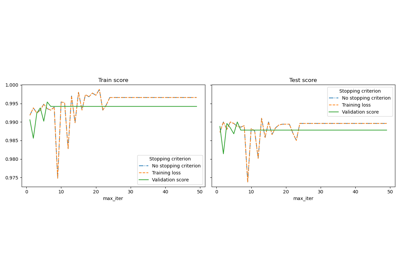

(-inf, inf)范围内。- early_stopping布尔值,默认=False

当验证分数没有改善时,是否使用早期停止来终止训练。如果设置为

True,它将自动留出训练数据的一个分层部分作为验证集,并在score方法返回的验证分数在连续 n_iter_no_change 个 epoch 中未能至少提高 tol 时终止训练。有关早期停止效果的示例,请参阅 随机梯度下降的早期停止。

0.20 版本新增: 添加了 'early_stopping' 选项

- validation_fraction浮点数,默认=0.1

留作早期停止验证集的训练数据比例。必须在 0 到 1 之间。仅当

early_stopping为 True 时使用。值必须在(0.0, 1.0)范围内。0.20 版本新增: 添加了 'validation_fraction' 选项

- n_iter_no_change整数,默认=5

在停止拟合之前,无改进的迭代次数。收敛性根据

early_stopping参数检查训练损失或验证损失。整数值必须在[1, max_iter)范围内。0.20 版本新增: 添加了 'n_iter_no_change' 选项

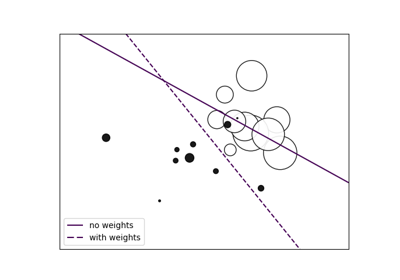

- class_weight字典,{class_label: weight} 或 "balanced",默认=None

class_weight 拟合参数的预设值。

与类别相关的权重。如果未给出,则所有类别都被认为权重为一。

"balanced" 模式使用 y 的值自动调整权重,使其与输入数据中类别频率成反比,即

n_samples / (n_classes * np.bincount(y))。- warm_start布尔值,默认=False

设置为 True 时,重用上次调用 fit 的解决方案作为初始化,否则,擦除之前的解决方案。请参阅术语表。

当 warm_start 为 True 时,重复调用 fit 或 partial_fit 可能会导致与仅调用 fit 一次不同的解决方案,这是因为数据打乱方式的不同。如果使用动态学习率,学习率会根据已经看到的样本数量进行调整。调用

fit会重置此计数器,而partial_fit将导致现有计数器增加。- average布尔值或整数,默认=False

当设置为

True时,计算所有更新的平均 SGD 权重,并将结果存储在coef_属性中。如果设置为大于 1 的整数,则一旦看到的样本总数达到average,就开始平均。因此,average=10将在看到 10 个样本后开始平均。整数值必须在[1, n_samples]范围内。

- 属性:

- coef_如果 n_classes == 2,则为 (1, n_features) 形状的 ndarray,否则为 (n_classes, n_features) 形状的 ndarray

分配给特征的权重。

- intercept_如果 n_classes == 2,则为 (1,) 形状的 ndarray,否则为 (n_classes,) 形状的 ndarray

决策函数中的常数。

- n_iter_整数

达到停止准则前的实际迭代次数。对于多类别拟合,它是所有二元拟合中的最大值。

- classes_(n_classes,) 形状的数组

- t_整数

训练期间执行的权重更新次数。与

(n_iter_ * n_samples + 1)相同。- n_features_in_整数

拟合期间看到的特征数量。

0.24 版本新增。

- feature_names_in_(

n_features_in_,) 形状的 ndarray 拟合期间看到的特征名称。仅当

X的所有特征名称均为字符串时才定义。1.0 版本新增。

另请参阅

sklearn.svm.LinearSVC线性支持向量分类。

LogisticRegression逻辑回归。

Perceptron继承自 SGDClassifier。

Perceptron()等同于SGDClassifier(loss="perceptron", eta0=1, learning_rate="constant", penalty=None)。

示例

>>> import numpy as np >>> from sklearn.linear_model import SGDClassifier >>> from sklearn.preprocessing import StandardScaler >>> from sklearn.pipeline import make_pipeline >>> X = np.array([[-1, -1], [-2, -1], [1, 1], [2, 1]]) >>> Y = np.array([1, 1, 2, 2]) >>> # Always scale the input. The most convenient way is to use a pipeline. >>> clf = make_pipeline(StandardScaler(), ... SGDClassifier(max_iter=1000, tol=1e-3)) >>> clf.fit(X, Y) Pipeline(steps=[('standardscaler', StandardScaler()), ('sgdclassifier', SGDClassifier())]) >>> print(clf.predict([[-0.8, -1]])) [1]

- decision_function(X)[source]#

预测样本的置信度分数。

样本的置信度分数与该样本到超平面的有符号距离成比例。

- 参数:

- X(n_samples, n_features) 形状的 {类数组或稀疏矩阵}

我们想要获取置信度分数的数据矩阵。

- 返回:

- scores(n_samples,) 或 (n_samples, n_classes) 形状的 ndarray

每

(n_samples, n_classes)组合的置信度分数。在二元分类情况下,self.classes_[1]的置信度分数,其中 >0 表示将预测为该类别。

- densify()[source]#

将系数矩阵转换为密集数组格式。

将

coef_成员(恢复)为 numpy.ndarray。这是coef_的默认格式,并且拟合时需要,因此仅在之前已被稀疏化的模型上才需要调用此方法;否则,它是一个空操作。- 返回:

- self

已拟合的估计器。

- fit(X, y, coef_init=None, intercept_init=None, sample_weight=None)[source]#

使用随机梯度下降拟合线性模型。

- 参数:

- X{类数组或稀疏矩阵},形状 (n_samples, n_features)

训练数据。

- y(n_samples,) 形状的 ndarray

目标值。

- coef_init(n_classes, n_features) 形状的 ndarray,默认=None

用于热启动优化的初始系数。

- intercept_init(n_classes,) 形状的 ndarray,默认=None

用于热启动优化的初始截距。

- sample_weight类数组,形状 (n_samples,),默认=None

应用于单个样本的权重。如果未提供,则假定均匀权重。如果指定了 class_weight,这些权重将与 class_weight(通过构造函数传递)相乘。

- 返回:

- self对象

返回 self 的实例。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查看用户指南,了解路由机制的工作原理。

- 返回:

- routingMetadataRequest

封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deep布尔值,默认=True

如果为 True,将返回此估计器及其包含的作为估计器的子对象的参数。

- 返回:

- params字典

参数名称映射到它们的值。

- partial_fit(X, y, classes=None, sample_weight=None)[source]#

对给定样本执行一个 epoch 的随机梯度下降。

在内部,此方法使用

max_iter = 1。因此,不保证在调用一次后达到成本函数的最小值。目标收敛、早期停止和学习率调整等事项应由用户处理。- 参数:

- X{类数组或稀疏矩阵},形状 (n_samples, n_features)

训练数据的子集。

- y(n_samples,) 形状的 ndarray

目标值的子集。

- classes(n_classes,) 形状的 ndarray,默认=None

对 partial_fit 的所有调用中的类别。可以通过

np.unique(y_all)获取,其中 y_all 是整个数据集的目标向量。此参数在第一次调用 partial_fit 时是必需的,后续调用可以省略。请注意,y 不需要包含classes中的所有标签。- sample_weight类数组,形状 (n_samples,),默认=None

应用于单个样本的权重。如果未提供,则假定均匀权重。

- 返回:

- self对象

返回 self 的实例。

- predict(X)[source]#

预测 X 中样本的类别标签。

- 参数:

- X(n_samples, n_features) 形状的 {类数组或稀疏矩阵}

我们想要获取预测的数据矩阵。

- 返回:

- y_pred(n_samples,) 形状的 ndarray

包含每个样本类别标签的向量。

- predict_log_proba(X)[source]#

概率估计的对数。

此方法仅适用于对数损失和修正 Huber 损失。

当 loss="modified_huber" 时,概率估计可能为硬零和一,因此无法取对数。

详情请参阅

predict_proba。- 参数:

- X(n_samples, n_features) 形状的 {类数组或稀疏矩阵}

用于预测的输入数据。

- 返回:

- T(n_samples, n_classes) 形状的类数组

返回模型中每个类别的样本对数概率,类别按

self.classes_中的顺序排列。

- predict_proba(X)[source]#

概率估计。

此方法仅适用于对数损失和修正 Huber 损失。

多类别概率估计是通过二元(一对多)估计通过简单归一化得到的,如 Zadrozny 和 Elkan 所建议。

当 loss="modified_huber" 时,二元概率估计由 (clip(decision_function(X), -1, 1) + 1) / 2 给出。对于其他损失函数,有必要通过使用

CalibratedClassifierCV封装分类器来执行适当的概率校准。- 参数:

- X{类数组或稀疏矩阵},形状 (n_samples, n_features)

用于预测的输入数据。

- 返回:

- (n_samples, n_classes) 形状的 ndarray

返回模型中每个类别的样本概率,类别按

self.classes_中的顺序排列。

参考文献

Zadrozny 和 Elkan,“将分类器分数转换为多类别概率估计”,SIGKDD’02,https://dl.acm.org/doi/pdf/10.1145/775047.775151

loss="modified_huber" 情况下的公式依据在附录 B 中:http://jmlr.csail.mit.edu/papers/volume2/zhang02c/zhang02c.pdf

- score(X, y, sample_weight=None)[source]#

返回给定数据和标签的准确率。

在多标签分类中,这是子集准确率,它是一个严苛的指标,因为它要求每个样本的每个标签集都必须正确预测。

- 参数:

- X(n_samples, n_features) 形状的类数组

测试样本。

- y(n_samples,) 或 (n_samples, n_outputs) 形状的类数组

X的真实标签。- sample_weight(n_samples,) 形状的类数组,默认=None

样本权重。

- 返回:

- score浮点数

self.predict(X)相对于y的平均准确率。

- set_fit_request(*, coef_init: bool | None | str = '$UNCHANGED$', intercept_init: bool | None | str = '$UNCHANGED$', sample_weight: bool | None | str = '$UNCHANGED$') SGDClassifier[source]#

请求传递给

fit方法的元数据。请注意,此方法仅在

enable_metadata_routing=True时才相关(请参阅sklearn.set_config)。请参阅用户指南,了解路由机制的工作原理。每个参数的选项是

True: 请求元数据,如果提供则传递给fit。如果未提供元数据,则请求被忽略。False: 不请求元数据,并且元估计器不会将其传递给fit。None: 不请求元数据,如果用户提供元数据,元估计器将引发错误。str: 元数据应以给定的别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。1.3 版本新增。

注意

此方法仅当此估计器用作元估计器的子估计器时才相关,例如在

Pipeline内部使用时。否则它没有效果。- 参数:

- coef_init字符串、True、False 或 None,默认=sklearn.utils.metadata_routing.UNCHANGED

fit方法中coef_init参数的元数据路由。- intercept_init字符串、True、False 或 None,默认=sklearn.utils.metadata_routing.UNCHANGED

fit方法中intercept_init参数的元数据路由。- sample_weight字符串、True、False 或 None,默认=sklearn.utils.metadata_routing.UNCHANGED

fit方法中sample_weight参数的元数据路由。

- 返回:

- self对象

更新后的对象。

- set_params(**params)[source]#

设置此估计器的参数。

该方法适用于简单估计器以及嵌套对象(例如

Pipeline)。后者具有<component>__<parameter>形式的参数,以便可以更新嵌套对象的每个组件。- 参数:

- **params字典

估计器参数。

- 返回:

- self估计器实例

估计器实例。

- set_partial_fit_request(*, classes: bool | None | str = '$UNCHANGED$', sample_weight: bool | None | str = '$UNCHANGED$') SGDClassifier[source]#

请求传递给

partial_fit方法的元数据。请注意,此方法仅在

enable_metadata_routing=True时才相关(请参阅sklearn.set_config)。请参阅用户指南,了解路由机制的工作原理。每个参数的选项是

True: 请求元数据,如果提供则传递给partial_fit。如果未提供元数据,则请求被忽略。False: 不请求元数据,并且元估计器不会将其传递给partial_fit。None: 不请求元数据,如果用户提供元数据,元估计器将引发错误。str: 元数据应以给定的别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。1.3 版本新增。

注意

此方法仅当此估计器用作元估计器的子估计器时才相关,例如在

Pipeline内部使用时。否则它没有效果。- 参数:

- classes字符串、True、False 或 None,默认=sklearn.utils.metadata_routing.UNCHANGED

partial_fit方法中classes参数的元数据路由。- sample_weight字符串、True、False 或 None,默认=sklearn.utils.metadata_routing.UNCHANGED

partial_fit方法中sample_weight参数的元数据路由。

- 返回:

- self对象

更新后的对象。

- set_score_request(*, sample_weight: bool | None | str = '$UNCHANGED$') SGDClassifier[source]#

请求传递给

score方法的元数据。请注意,此方法仅在

enable_metadata_routing=True时才相关(请参阅sklearn.set_config)。请参阅用户指南,了解路由机制的工作原理。每个参数的选项是

True: 请求元数据,如果提供则传递给score。如果未提供元数据,则请求被忽略。False: 不请求元数据,并且元估计器不会将其传递给score。None: 不请求元数据,如果用户提供元数据,元估计器将引发错误。str: 元数据应以给定的别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。1.3 版本新增。

注意

此方法仅当此估计器用作元估计器的子估计器时才相关,例如在

Pipeline内部使用时。否则它没有效果。- 参数:

- sample_weight字符串、True、False 或 None,默认=sklearn.utils.metadata_routing.UNCHANGED

score方法中sample_weight参数的元数据路由。

- 返回:

- self对象

更新后的对象。

- sparsify()[source]#

将系数矩阵转换为稀疏格式。

将

coef_成员转换为 scipy.sparse 矩阵,对于 L1-正则化模型,这比通常的 numpy.ndarray 表示法在内存和存储方面效率更高。intercept_成员未转换。- 返回:

- self

已拟合的估计器。

注意事项

对于非稀疏模型,即当

coef_中没有很多零时,这实际上可能会增加内存使用量,因此请谨慎使用此方法。经验法则是,零元素的数量(可以用(coef_ == 0).sum()计算)必须超过 50% 才能提供显著的好处。调用此方法后,除非您调用 densify,否则使用 partial_fit 方法(如果有)将无法继续拟合。