lasso_path#

- sklearn.linear_model.lasso_path(X, y, *, eps=0.001, n_alphas=100, alphas=None, precompute='auto', Xy=None, copy_X=True, coef_init=None, verbose=False, return_n_iter=False, positive=False, **params)[source]#

使用坐标下降计算 Lasso 路径。

Lasso 优化函数对于单输出和多输出有所不同。

对于单输出任务,它是

(1 / (2 * n_samples)) * ||y - Xw||^2_2 + alpha * ||w||_1

对于多输出任务,它是

(1 / (2 * n_samples)) * ||Y - XW||^2_Fro + alpha * ||W||_21

其中

||W||_21 = \sum_i \sqrt{\sum_j w_{ij}^2}

即每行范数之和。

在用户指南中阅读更多内容。

- 参数:

- Xshape 为 (n_samples, n_features) 的 {array-like, sparse matrix}

训练数据。直接作为Fortran连续数据传递以避免不必要的内存复制。如果

y是单输出,则X可以是稀疏的。- y{array-like, sparse matrix} of shape (n_samples,) or (n_samples, n_targets)

目标值。

- epsfloat, default=1e-3

路径的长度。

eps=1e-3表示alpha_min / alpha_max = 1e-3。- n_alphasint, default=100

正则化路径上alpha的数量。

- alphasarray-like, default=None

计算模型的 alpha 列表。如果为

None,则自动设置 alpha。- precompute‘auto’, bool or array-like of shape (n_features, n_features), default=’auto’

是否使用预计算的Gram矩阵来加快计算速度。如果设置为

'auto',则由我们决定。Gram矩阵也可以作为参数传入。- Xyarray-like of shape (n_features,) or (n_features, n_targets), default=None

可以预计算的Xy = np.dot(X.T, y)。仅当Gram矩阵预计算时有用。

- copy_Xbool, default=True

如果为

True,X将被复制;否则,它可能会被覆盖。- coef_initarray-like of shape (n_features, ), default=None

系数的初始值。

- verbosebool or int, default=False

冗余度级别。

- return_n_iterbool, default=False

是否返回迭代次数。

- positivebool, default=False

如果设置为True,强制系数为正。(仅当

y.ndim == 1时允许)。- **paramskwargs

传递给坐标下降求解器的关键字参数。

- 返回:

- alphasndarray of shape (n_alphas,)

计算模型的路径上的alphas。

- coefsndarray of shape (n_features, n_alphas) or (n_targets, n_features, n_alphas)

路径上的系数。

- dual_gapsndarray of shape (n_alphas,)

每个alpha优化结束时的对偶间隙。

- n_iterslist of int

坐标下降优化器为每个 alpha 达到指定容差所花费的迭代次数。

另请参阅

lars_pathCompute Least Angle Regression or Lasso path using LARS algorithm.

LassoLasso 是一种估计稀疏系数的线性模型。

LassoLars使用最小角回归(又名 Lars)拟合的 Lasso 模型。

LassoCV具有沿正则化路径迭代拟合的 Lasso 线性模型。

LassoLarsCV使用 LARS 算法的交叉验证 Lasso。

sklearn.decomposition.sparse_encode可用于将信号转换为来自固定原子的稀疏线性组合的估计器。

注意事项

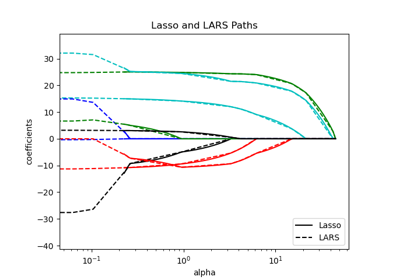

有关示例,请参阅examples/linear_model/plot_lasso_lasso_lars_elasticnet_path.py。

为避免不必要的内存复制,fit方法的X参数应直接作为Fortran连续的numpy数组传递。

请注意,在某些情况下,Lars 求解器实现此功能可能明显更快。特别是,可以使用线性插值来检索 lars_path 输出值之间的模型系数。

底层的坐标下降求解器使用间隙安全筛选规则来加快拟合时间,请参阅坐标下降用户指南。

示例

比较 lasso_path 和带插值的 lars_path

>>> import numpy as np >>> from sklearn.linear_model import lasso_path >>> X = np.array([[1, 2, 3.1], [2.3, 5.4, 4.3]]).T >>> y = np.array([1, 2, 3.1]) >>> # Use lasso_path to compute a coefficient path >>> _, coef_path, _ = lasso_path(X, y, alphas=[5., 1., .5]) >>> print(coef_path) [[0. 0. 0.46874778] [0.2159048 0.4425765 0.23689075]]

>>> # Now use lars_path and 1D linear interpolation to compute the >>> # same path >>> from sklearn.linear_model import lars_path >>> alphas, active, coef_path_lars = lars_path(X, y, method='lasso') >>> from scipy import interpolate >>> coef_path_continuous = interpolate.interp1d(alphas[::-1], ... coef_path_lars[:, ::-1]) >>> print(coef_path_continuous([5., 1., .5])) [[0. 0. 0.46915237] [0.2159048 0.4425765 0.23668876]]