CalibratedClassifierCV#

- class sklearn.calibration.CalibratedClassifierCV(estimator=None, *, method='sigmoid', cv=None, n_jobs=None, ensemble='auto')[source]#

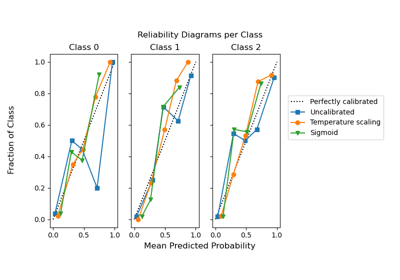

使用等渗、sigmoid 或温度缩放校准概率。

此类别使用交叉验证来估计分类器的参数并随后校准分类器。当

ensemble=True时,对于每个交叉验证分割,它将基分类器的副本拟合到训练子集,并使用测试子集对其进行校准。对于预测,预测概率在这些单独校准的分类器之间进行平均。当ensemble=False时,交叉验证用于通过cross_val_predict获得无偏预测,然后将其用于校准。对于预测,使用使用所有数据训练的基分类器。这是当SVC和NuSVC估计器设置probabilities=True时实现的预测方法(详情请参阅 用户指南)。已拟合的分类器可以通过将其包装在

FrozenEstimator中进行校准。在这种情况下,所有提供的数据都用于校准。用户必须手动确保用于模型拟合和校准的数据是分离的。校准基于

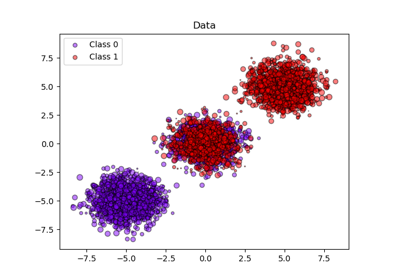

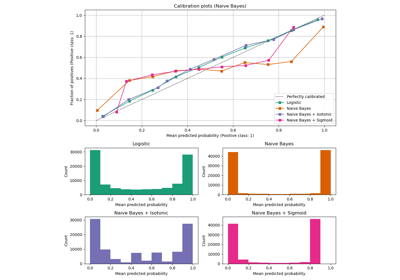

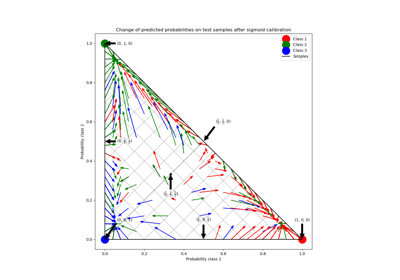

estimator的 decision_function 方法(如果存在),否则基于 predict_proba。在 用户指南 中阅读更多内容。为了了解有关 CalibratedClassifierCV 类的更多信息,请参阅以下校准示例:分类器概率校准、概率校准曲线 和 3 类分类的概率校准。

- 参数:

- estimatorestimator instance, default=None

需要校准其输出以提供更准确的

predict_proba输出的分类器。默认分类器是LinearSVC。1.2 版本新增。

- method{‘sigmoid’, ‘isotonic’, ‘temperature’}, default=’sigmoid’

用于校准的方法。可以是:

‘sigmoid’,对应于 Platt 方法(即二元逻辑回归模型)。

‘isotonic’,一种非参数方法。

‘temperature’,温度缩放。

Sigmoid 和等渗校准方法原生仅支持二元分类器,并通过 One-vs-Rest (OvR) 策略扩展到多类分类,并进行事后归一化,即在校准后调整概率以确保它们相加为 1。

相比之下,温度缩放通过应用

softmax(classifier_logits/T)自然地支持多类校准,其中T(温度)值优化对数损失。对于非常不平衡的数据集上的未校准分类器,可能首选 sigmoid 校准,因为它会拟合一个额外的截距参数。当被校准的分类器偏向多数类时,这有助于适当移动决策边界。

当校准样本数量过低时(

≪1000),不建议使用等渗校准,因为它容易过拟合。版本 1.8 中更改: 添加了 'temperature' 选项。

- cvint, cross-validation generator, or iterable, default=None

确定交叉验证拆分策略。cv 的可能输入包括

None,使用默认的 5 折交叉验证,

整数,指定折数。

一个可迭代对象,产生索引数组形式的 (训练集, 测试集) 拆分。

对于整数/None 输入,如果

y是二元或多类,则使用StratifiedKFold。如果y既不是二元也不是多类,则使用KFold。请参阅 用户指南,了解此处可以使用的各种交叉验证策略。

版本 0.22 中已更改:如果为 None,

cv默认值从 3 折更改为 5 折。- n_jobsint, default=None

并行运行的作业数。

None表示 1,除非在joblib.parallel_backend上下文中。-1表示使用所有处理器。基估计器克隆在交叉验证迭代中并行拟合。

有关更多详细信息,请参阅词汇表。

0.24 版本新增。

- ensemblebool, or “auto”, default=”auto”

确定校准器如何拟合。

如果

estimator是FrozenEstimator,则“auto”将使用False,否则使用True。如果为

True,则estimator使用训练数据拟合,并使用测试数据校准,对于每个cv折叠都是如此。最终的估计器是n_cv个拟合分类器和校准器对的集合,其中n_cv是交叉验证折叠的数量。输出是所有对的平均预测概率。如果为

False,则使用cv通过cross_val_predict计算无偏预测,然后将其用于校准。在预测时,使用的分类器是使用所有数据训练的estimator。请注意,此方法也在sklearn.svm估计器中通过probabilities=True参数在内部实现。0.24 版本新增。

版本 1.6 中更改: 添加了 “auto” 选项并将其设置为默认值。

- 属性:

- classes_ndarray of shape (n_classes,)

类标签。

- n_features_in_int

在 fit 期间看到的特征数。仅当底层估计器在拟合时暴露此属性时才定义。

0.24 版本新增。

- feature_names_in_shape 为 (

n_features_in_,) 的 ndarray 拟合 期间看到的特征名称。仅当底层估计器在拟合时公开此类属性时才定义。

1.0 版本新增。

- calibrated_classifiers_list (len() equal to cv or 1 if

ensemble=False) 分类器和校准器对的列表。

当

ensemble=True时,n_cv个拟合的estimator和校准器对。n_cv是交叉验证折叠的数量。当

ensemble=False时,在所有数据上拟合的estimator和拟合的校准器。

版本 0.24 中更改: 当

ensemble=False时的单个校准分类器情况。

另请参阅

calibration_curve计算校准曲线的真实概率和预测概率。

References

[1]B. Zadrozny & C. Elkan. Obtaining calibrated probability estimates from decision trees and naive Bayesian classifiers, ICML 2001。

[2]B. Zadrozny & C. Elkan. Transforming Classifier Scores into Accurate Multiclass Probability Estimates, KDD 2002。

[3]J. Platt. Probabilistic Outputs for Support Vector Machines and Comparisons to Regularized Likelihood Methods, 1999。

[4]A. Niculescu-Mizil & R. Caruana. Predicting Good Probabilities with Supervised Learning, ICML 2005。

[5]Chuan Guo, Geoff Pleiss, Yu Sun, Kilian Q. Weinberger. On Calibration of Modern Neural Networks. Proceedings of the 34th International Conference on Machine Learning, PMLR 70:1321-1330, 2017。

示例

>>> from sklearn.datasets import make_classification >>> from sklearn.naive_bayes import GaussianNB >>> from sklearn.calibration import CalibratedClassifierCV >>> X, y = make_classification(n_samples=100, n_features=2, ... n_redundant=0, random_state=42) >>> base_clf = GaussianNB() >>> calibrated_clf = CalibratedClassifierCV(base_clf, cv=3) >>> calibrated_clf.fit(X, y) CalibratedClassifierCV(...) >>> len(calibrated_clf.calibrated_classifiers_) 3 >>> calibrated_clf.predict_proba(X)[:5, :] array([[0.110, 0.889], [0.072, 0.927], [0.928, 0.072], [0.928, 0.072], [0.072, 0.928]]) >>> from sklearn.model_selection import train_test_split >>> X, y = make_classification(n_samples=100, n_features=2, ... n_redundant=0, random_state=42) >>> X_train, X_calib, y_train, y_calib = train_test_split( ... X, y, random_state=42 ... ) >>> base_clf = GaussianNB() >>> base_clf.fit(X_train, y_train) GaussianNB() >>> from sklearn.frozen import FrozenEstimator >>> calibrated_clf = CalibratedClassifierCV(FrozenEstimator(base_clf)) >>> calibrated_clf.fit(X_calib, y_calib) CalibratedClassifierCV(...) >>> len(calibrated_clf.calibrated_classifiers_) 1 >>> calibrated_clf.predict_proba([[-0.5, 0.5]]) array([[0.936, 0.063]])

- fit(X, y, sample_weight=None, **fit_params)[source]#

拟合校准模型。

- 参数:

- Xshape 为 (n_samples, n_features) 的 array-like

训练数据。

- yarray-like of shape (n_samples,)

目标值。

- sample_weightshape 为 (n_samples,) 的 array-like, default=None

样本权重。如果为 None,则样本权重相等。

- **fit_paramsdict

要传递给底层分类器的

fit方法的参数。

- 返回:

- selfobject

Returns an instance of self.

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查阅 用户指南,了解路由机制如何工作。

- 返回:

- routingMetadataRouter

封装路由信息的

MetadataRouter。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool, default=True

如果为 True,将返回此估计器以及包含的子对象(如果它们是估计器)的参数。

- 返回:

- paramsdict

参数名称映射到其值。

- predict(X)[source]#

预测新样本的目标。

预测的类别是概率最高的类别,因此可能与未校准分类器的预测不同。

- 参数:

- Xshape 为 (n_samples, n_features) 的 array-like

样本,如

estimator.predict所接受。

- 返回:

- Cndarray of shape (n_samples,)

预测的类别。

- predict_proba(X)[source]#

校准后的分类概率。

此函数根据测试向量 X 上的每个类别返回校准后的分类概率。

- 参数:

- Xshape 为 (n_samples, n_features) 的 array-like

样本,如

estimator.predict_proba所接受。

- 返回:

- Cndarray of shape (n_samples, n_classes)

预测的概率。

- score(X, y, sample_weight=None)[source]#

返回在提供的数据和标签上的 准确率 (accuracy)。

在多标签分类中,这是子集准确率 (subset accuracy),这是一个严格的指标,因为它要求每个样本的每个标签集都被正确预测。

- 参数:

- Xshape 为 (n_samples, n_features) 的 array-like

测试样本。

- yshape 为 (n_samples,) 或 (n_samples, n_outputs) 的 array-like

X的真实标签。- sample_weightshape 为 (n_samples,) 的 array-like, default=None

样本权重。

- 返回:

- scorefloat

self.predict(X)相对于y的平均准确率。

- set_fit_request(*, sample_weight: bool | None | str = '$UNCHANGED$') CalibratedClassifierCV[source]#

配置是否应请求元数据以传递给

fit方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给fit。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给fit。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

fit方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。

- set_params(**params)[source]#

设置此估计器的参数。

此方法适用于简单的估计器以及嵌套对象(如

Pipeline)。后者具有<component>__<parameter>形式的参数,以便可以更新嵌套对象的每个组件。- 参数:

- **paramsdict

估计器参数。

- 返回:

- selfestimator instance

估计器实例。

- set_score_request(*, sample_weight: bool | None | str = '$UNCHANGED$') CalibratedClassifierCV[source]#

配置是否应请求元数据以传递给

score方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给score。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给score。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

score方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。