HuberRegressor#

- class sklearn.linear_model.HuberRegressor(*, epsilon=1.35, max_iter=100, alpha=0.0001, warm_start=False, fit_intercept=True, tol=1e-05)[source]#

对异常值鲁棒的 L2 正则化线性回归模型。

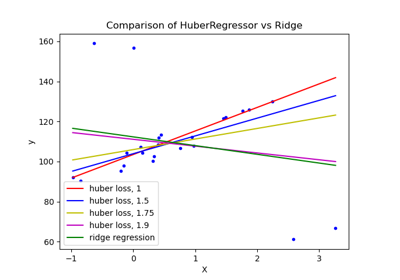

Huber Regressor 针对

|(y - Xw - c) / sigma| < epsilon的样本优化平方损失,针对|(y - Xw - c) / sigma| > epsilon的样本优化绝对损失。其中模型系数w、截距c和尺度参数sigma都是待优化的参数。参数sigma确保了即使y按一定因子放大或缩小,也无需重新缩放epsilon即可实现相同的鲁棒性。请注意,这没有考虑到X的不同特征可能具有不同尺度的事实。Huber 损失函数的优点在于它不受离群值严重影响,同时也没有完全忽略它们的作用。

在 用户指南 中阅读更多内容

版本 0.18 新增。

- 参数:

- epsilonfloat, default=1.35

参数 epsilon 控制应被分类为离群值的样本数量。epsilon 越小,对离群值的鲁棒性越强。epsilon 必须在范围

[1, inf)内。- max_iterint, default=100

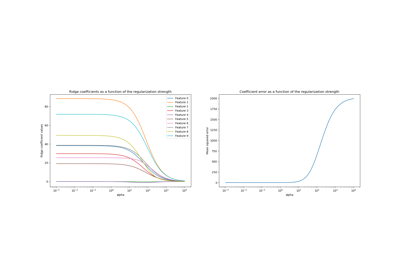

scipy.optimize.minimize(method="L-BFGS-B")应运行的最大迭代次数。- alphafloat, default=0.0001

平方 L2 正则化的强度。请注意,惩罚项等于

alpha * ||w||^2。必须在范围[0, inf)内。- warm_startbool, default=False

如果必须重用先前使用模型的存储属性,这将非常有用。如果设置为 False,则每次调用 fit 时都会重写系数。请参阅 词汇表。

- fit_interceptbool, default=True

是否拟合截距。如果数据已围绕原点居中,则可以将其设置为 False。

- tolfloat, default=1e-05

当

max{|proj g_i | i = 1, ..., n}<=tol时,迭代将停止,其中 pg_i 是投影梯度的第 i 个分量。

- 属性:

- coef_array, shape (n_features,)

通过优化 L2 正则化的 Huber 损失获得的特征。

- intercept_float

偏差。

- scale_float

|y - Xw - c|被缩小的因子。- n_features_in_int

在 拟合 期间看到的特征数。

0.24 版本新增。

- feature_names_in_shape 为 (

n_features_in_,) 的 ndarray 在 fit 期间看到的特征名称。仅当

X具有全部为字符串的特征名称时才定义。1.0 版本新增。

- n_iter_int

scipy.optimize.minimize(method="L-BFGS-B")运行的迭代次数。版本 0.20 中已更改: 在 SciPy <= 1.0.0 中,lbfgs 迭代次数可能超过

max_iter。n_iter_现在将最多报告max_iter。- outliers_array, shape (n_samples,)

一个布尔掩码,其中样本被识别为离群值时设置为 True。

另请参阅

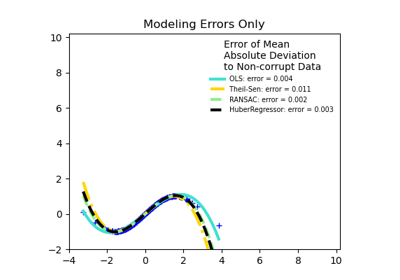

RANSACRegressorRANSAC (RANdom SAmple Consensus) 算法。

TheilSenRegressorTheil-Sen Estimator robust multivariate regression model.

SGDRegressor通过最小化正则化经验损失与 SGD 拟合。

References

[1]Peter J. Huber, Elvezio M. Ronchetti, Robust Statistics Concomitant scale estimates, p. 172

[2]Art B. Owen (2006), A robust hybrid of lasso and ridge regression.

示例

>>> import numpy as np >>> from sklearn.linear_model import HuberRegressor, LinearRegression >>> from sklearn.datasets import make_regression >>> rng = np.random.RandomState(0) >>> X, y, coef = make_regression( ... n_samples=200, n_features=2, noise=4.0, coef=True, random_state=0) >>> X[:4] = rng.uniform(10, 20, (4, 2)) >>> y[:4] = rng.uniform(10, 20, 4) >>> huber = HuberRegressor().fit(X, y) >>> huber.score(X, y) -7.284 >>> huber.predict(X[:1,]) array([806.7200]) >>> linear = LinearRegression().fit(X, y) >>> print("True coefficients:", coef) True coefficients: [20.4923... 34.1698...] >>> print("Huber coefficients:", huber.coef_) Huber coefficients: [17.7906... 31.0106...] >>> print("Linear Regression coefficients:", linear.coef_) Linear Regression coefficients: [-1.9221... 7.0226...]

- fit(X, y, sample_weight=None)[source]#

根据给定的训练数据拟合模型。

- 参数:

- Xarray-like, shape (n_samples, n_features)

训练向量,其中

n_samples是样本数,n_features是特征数。- yarray-like, shape (n_samples,)

相对于 X 的目标向量。

- sample_weightarray-like, shape (n_samples,)

赋予每个样本的权重。

- 返回:

- selfobject

已拟合的

HuberRegressor估计器。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查阅 用户指南,了解路由机制如何工作。

- 返回:

- routingMetadataRequest

封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool, default=True

如果为 True,将返回此估计器以及包含的子对象(如果它们是估计器)的参数。

- 返回:

- paramsdict

参数名称映射到其值。

- predict(X)[source]#

使用线性模型进行预测。

- 参数:

- Xarray-like or sparse matrix, shape (n_samples, n_features)

样本。

- 返回:

- Carray, shape (n_samples,)

返回预测值。

- score(X, y, sample_weight=None)[source]#

返回测试数据的 决定系数。

决定系数 \(R^2\) 定义为 \((1 - \frac{u}{v})\),其中 \(u\) 是残差平方和

((y_true - y_pred)** 2).sum(),\(v\) 是总平方和((y_true - y_true.mean()) ** 2).sum()。最好的分数是 1.0,分数也可以是负数(因为模型可能任意地差)。一个总是预测y期望值(不考虑输入特征)的常数模型将获得 \(R^2\) 分数 0.0。- 参数:

- Xshape 为 (n_samples, n_features) 的 array-like

测试样本。对于某些估计器,这可能是一个预先计算的核矩阵或一个通用对象列表,形状为

(n_samples, n_samples_fitted),其中n_samples_fitted是用于估计器拟合的样本数。- yshape 为 (n_samples,) 或 (n_samples, n_outputs) 的 array-like

X的真实值。- sample_weightshape 为 (n_samples,) 的 array-like, default=None

样本权重。

- 返回:

- scorefloat

self.predict(X)相对于y的 \(R^2\)。

注意事项

从版本 0.23 开始,在对回归器调用

score时使用的 \(R^2\) 分数使用multioutput='uniform_average',以与r2_score的默认值保持一致。这会影响所有多输出回归器(除了MultiOutputRegressor)的score方法。

- set_fit_request(*, sample_weight: bool | None | str = '$UNCHANGED$') HuberRegressor[source]#

配置是否应请求元数据以传递给

fit方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给fit。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给fit。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

fit方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。

- set_params(**params)[source]#

设置此估计器的参数。

此方法适用于简单的估计器以及嵌套对象(如

Pipeline)。后者具有<component>__<parameter>形式的参数,以便可以更新嵌套对象的每个组件。- 参数:

- **paramsdict

估计器参数。

- 返回:

- selfestimator instance

估计器实例。

- set_score_request(*, sample_weight: bool | None | str = '$UNCHANGED$') HuberRegressor[source]#

配置是否应请求元数据以传递给

score方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给score。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给score。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

score方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。