IsolationForest#

- class sklearn.ensemble.IsolationForest(*, n_estimators=100, max_samples='auto', contamination='auto', max_features=1.0, bootstrap=False, n_jobs=None, random_state=None, verbose=0, warm_start=False)[source]#

Isolation Forest 算法。

使用 IsolationForest 算法返回每个样本的异常分数。

IsolationForest 通过随机选择一个特征,然后随机选择该特征的最大值和最小值之间的一个分割值来“隔离”观测值。

由于递归划分可以表示为树结构,因此隔离一个样本所需的分割次数等同于从根节点到终止节点的路径长度。

这种路径长度(在由这些随机树组成的森林中取平均值)是衡量正常性的指标,也是我们的决策函数。

随机划分会为异常值生成明显更短的路径。因此,当一个随机树森林集体为特定样本生成更短的路径长度时,这些样本极有可能是异常值。

在用户指南中了解更多信息。

版本 0.18 新增。

- 参数:

- n_estimatorsint, default=100

The number of base estimators in the ensemble.

- max_samples“auto”, int or float, default=”auto”

用于训练每个基础估计器而从 X 中抽取的样本数量。

如果为 int,则抽取

max_samples个样本。如果为 float,则抽取

max_samples * X.shape[0]个样本。如果为 “auto”,则

max_samples=min(256, n_samples)。

如果 max_samples 大于提供的样本数量,则所有样本将用于所有树(不进行采样)。

- contamination‘auto’ or float, default=’auto’

数据集的污染程度,即数据集中异常值的比例。用于拟合时定义样本分数的阈值。

如果为 ‘auto’,则阈值按原始论文中的方式确定。

如果为 float,则污染程度应在范围 (0, 0.5] 内。

版本 0.22 中的更改:

contamination的默认值从 0.1 更改为'auto'。- max_featuresint or float, default=1.0

用于训练每个基础估计器而从 X 中抽取的特征数量。

If int, then draw

max_featuresfeatures.If float, then draw

max(1, int(max_features * n_features_in_))features.

注意:使用小于 1.0 的浮点数或小于特征数量的整数将启用特征子采样,并导致运行时间更长。

- bootstrapbool, default=False

如果为 True,则使用有放回抽样从训练数据的随机子集中拟合单个树。如果为 False,则执行无放回抽样。

- n_jobsint, default=None

为

fit并行运行的作业数。None表示 1,除非在joblib.parallel_backend上下文中。-1表示使用所有处理器。有关详细信息,请参阅词汇表。- random_stateint, RandomState instance or None, default=None

控制森林中每个分支步骤和每棵树的特征选择和分割值选择的伪随机性。

传入一个整数,以便在多次函数调用中获得可重现的结果。请参阅 词汇表。

- verboseint, default=0

控制树构建过程的详细程度。

- warm_startbool, default=False

设置为

True时,重用上一次调用 fit 的解决方案,并向集成中添加更多估计器;否则,只拟合一个全新的森林。请参阅词汇表。0.21 版本新增。

- 属性:

- estimator_

ExtraTreeRegressor实例 用于创建已拟合子估计器集合的子估计器模板。

版本 1.2 中新增:

base_estimator_已重命名为estimator_。- estimators_ExtraTreeRegressor 实例列表

已拟合子估计器的集合。

- estimators_features_ndarray 列表

The subset of drawn features for each base estimator.

estimators_samples_ndarray 列表每个基本估计器抽取的样本子集。

- max_samples_int

实际的样本数量。

- offset_float

用于根据原始分数定义决策函数的偏移量。我们有以下关系:

decision_function = score_samples - offset_。offset_定义如下。当 contamination 参数设置为“auto”时,offset 等于 -0.5,因为正常样本的分数接近 0,而异常样本的分数接近 -1。当提供了不同于“auto”的 contamination 参数时,offset 的定义方式使得我们在训练中获得预期的异常值数量(决策函数 < 0 的样本)。0.20 版本新增。

- n_features_in_int

在 拟合 期间看到的特征数。

0.24 版本新增。

- feature_names_in_shape 为 (

n_features_in_,) 的 ndarray 在 fit 期间看到的特征名称。仅当

X具有全部为字符串的特征名称时才定义。1.0 版本新增。

- estimator_

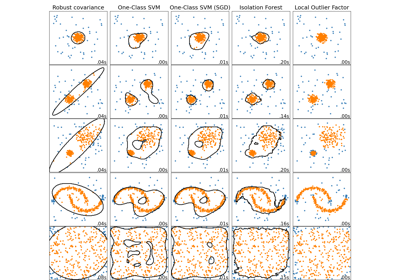

另请参阅

sklearn.covariance.EllipticEnvelope用于检测高斯分布数据集中异常值的对象。

sklearn.svm.OneClassSVM无监督异常值检测。估计高维分布的支持。实现基于 libsvm。

sklearn.neighbors.LocalOutlierFactor使用局部异常因子(LOF)的无监督异常值检测。

注意事项

实现基于 ExtraTreeRegressor 的集成。每棵树的最大深度设置为

ceil(log_2(n)),其中 \(n\) 是用于构建树的样本数量(有关详细信息,请参阅[1])。References

[1]F. T. Liu, K. M. Ting and Z. -H. Zhou. “Isolation forest.” 2008 Eighth IEEE International Conference on Data Mining (ICDM), 2008, pp. 413-422.

[2]F. T. Liu, K. M. Ting and Z. -H. Zhou. “Isolation-based anomaly detection.” ACM Transactions on Knowledge Discovery from Data (TKDD) 6.1 (2012): 1-39.

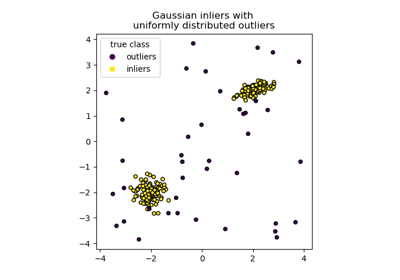

示例

>>> from sklearn.ensemble import IsolationForest >>> X = [[-1.1], [0.3], [0.5], [100]] >>> clf = IsolationForest(random_state=0).fit(X) >>> clf.predict([[0.1], [0], [90]]) array([ 1, 1, -1])

有关使用 isolation forest 进行异常值检测的示例,请参阅IsolationForest example。

- decision_function(X)[source]#

X 的基础分类器的平均异常分数。

输入样本的异常分数计算为森林中树的平均异常分数。

给定一棵树的观测值正常性度量是包含该观测值的叶节点的深度,这等同于隔离该点所需的分割次数。如果叶节点中有多个观测值 n_left,则添加 n_left 个样本隔离树的平均路径长度。

- 参数:

- Xshape 为 (n_samples, n_features) 的 {array-like, sparse matrix}

输入样本。在内部,它将转换为

dtype=np.float32,如果提供了稀疏矩阵,则转换为稀疏的csr_matrix。

- 返回:

- scoresndarray of shape (n_samples,)

输入样本的异常分数。分数越低,越异常。负分数表示异常值,正分数表示正常值。

注意事项

decision_function 方法可以通过设置 joblib 上下文并行化。这本身不使用在类中初始化的

n_jobs参数,该参数用于fit期间。这是因为对于少量样本(例如 1000 个或更少),计算分数在没有并行化的情况下可能更快。用户可以在 joblib 上下文中设置作业数量来控制并行作业数量。from joblib import parallel_backend # Note, we use threading here as the decision_function method is # not CPU bound. with parallel_backend("threading", n_jobs=4): model.decision_function(X)

- fit(X, y=None, sample_weight=None)[source]#

拟合估计器。

- 参数:

- Xshape 为 (n_samples, n_features) 的 {array-like, sparse matrix}

输入样本。使用

dtype=np.float32可获得最大效率。也支持稀疏矩阵,使用稀疏csc_matrix可获得最大效率。- y被忽略

未使用,按照惯例为保持 API 一致性而存在。

- sample_weightshape 为 (n_samples,) 的 array-like, default=None

样本权重。如果为 None,则样本权重相等。

- 返回:

- selfobject

拟合的估计器。

- fit_predict(X, y=None, **kwargs)[source]#

Perform fit on X and returns labels for X.

Returns -1 for outliers and 1 for inliers.

- 参数:

- Xshape 为 (n_samples, n_features) 的 {array-like, sparse matrix}

输入样本。

- y被忽略

未使用,按照惯例为保持 API 一致性而存在。

- **kwargsdict

要传递给

fit的参数。1.4 版本新增。

- 返回:

- yndarray of shape (n_samples,)

1 for inliers, -1 for outliers.

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查阅 用户指南,了解路由机制如何工作。

1.5 版本新增。

- 返回:

- routingMetadataRouter

封装路由信息的

MetadataRouter。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool, default=True

如果为 True,将返回此估计器以及包含的子对象(如果它们是估计器)的参数。

- 返回:

- paramsdict

参数名称映射到其值。

- predict(X)[source]#

预测特定样本是否为异常值。

- 参数:

- Xshape 为 (n_samples, n_features) 的 {array-like, sparse matrix}

输入样本。在内部,它将转换为

dtype=np.float32,如果提供了稀疏矩阵,则转换为稀疏的csr_matrix。

- 返回:

- is_inlierndarray of shape (n_samples,)

对于每个观测值,根据拟合模型判断其是否应被视为正常值(+1 或 -1)。

注意事项

predict 方法可以通过设置 joblib 上下文并行化。这本身不使用在类中初始化的

n_jobs参数,该参数用于fit期间。这是因为对于少量样本(例如 1000 个或更少),预测在没有并行化的情况下可能更快。用户可以在 joblib 上下文中设置作业数量来控制并行作业数量。from joblib import parallel_backend # Note, we use threading here as the predict method is not CPU bound. with parallel_backend("threading", n_jobs=4): model.predict(X)

- score_samples(X)[source]#

与原始论文中定义的异常分数相反。

输入样本的异常分数计算为森林中树的平均异常分数。

给定一棵树的观测值正常性度量是包含该观测值的叶节点的深度,这等同于隔离该点所需的分割次数。如果叶节点中有多个观测值 n_left,则添加 n_left 个样本隔离树的平均路径长度。

- 参数:

- Xshape 为 (n_samples, n_features) 的 {array-like, sparse matrix}

输入样本。

- 返回:

- scoresndarray of shape (n_samples,)

输入样本的异常分数。分数越低,越异常。

注意事项

score function 方法可以通过设置 joblib 上下文并行化。这本身不使用在类中初始化的

n_jobs参数,该参数用于fit期间。这是因为对于少量样本(例如 1000 个或更少),计算分数在没有并行化的情况下可能更快。用户可以在 joblib 上下文中设置作业数量来控制并行作业数量。from joblib import parallel_backend # Note, we use threading here as the score_samples method is not CPU bound. with parallel_backend("threading", n_jobs=4): model.score(X)

- set_fit_request(*, sample_weight: bool | None | str = '$UNCHANGED$') IsolationForest[source]#

配置是否应请求元数据以传递给

fit方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给fit。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给fit。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

fit方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。