Ridge#

- class sklearn.linear_model.Ridge(alpha=1.0, *, fit_intercept=True, copy_X=True, max_iter=None, tol=0.0001, solver='auto', positive=False, random_state=None)[source]#

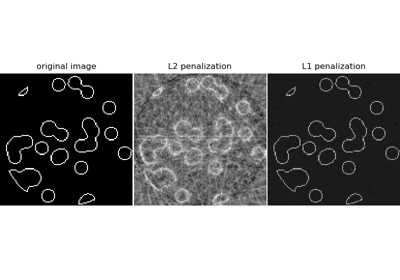

具有 l2 正则化的线性最小二乘。

最小化目标函数

||y - Xw||^2_2 + alpha * ||w||^2_2

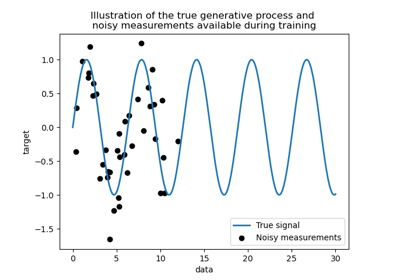

该模型解决的是一个回归问题,其中损失函数是线性最小二乘函数,正则化由l2范数给出。也被称为岭回归(Ridge Regression)或吉洪诺夫正则化(Tikhonov regularization)。该估计器内置支持多变量回归(即当y是形状为(n_samples, n_targets)的二维数组时)。

在用户指南中阅读更多内容。

- 参数:

- alpha{float, ndarray of shape (n_targets,)}, default=1.0

乘以L2项的常数,控制正则化强度。

alpha必须是非负浮点数,即在[0, inf)范围内。当

alpha = 0时,目标函数等同于普通最小二乘法,由LinearRegression对象求解。出于数值原因,不建议在Ridge对象中使用alpha = 0。相反,您应该使用LinearRegression对象。如果传入一个数组,则假定惩罚项是针对特定目标的。因此它们在数量上必须对应。

- fit_interceptbool, default=True

是否为该模型拟合截距。如果设置为false,计算中将不使用截距(即假定

X和y已中心化)。- copy_Xbool, default=True

如果为 True,X 将被复制;否则,它可能会被覆盖。

- max_iterint, default=None

共轭梯度求解器的最大迭代次数。对于‘sparse_cg’和‘lsqr’求解器,默认值由scipy.sparse.linalg确定。对于‘sag’求解器,默认值为1000。对于‘lbfgs’求解器,默认值为15000。

- tolfloat, default=1e-4

解(

coef_)的精度由tol决定,tol为每个求解器指定了不同的收敛标准‘svd’:

tol没有影响。‘cholesky’:

tol没有影响。‘sparse_cg’:残差范数小于

tol。‘lsqr’:

tol被设置为scipy.sparse.linalg.lsqr的atol和btol,它们控制残差向量相对于矩阵和系数范数的范数。‘sag’和‘saga’:系数的相对变化小于

tol。‘lbfgs’:绝对(投影)梯度的最大值=max|residuals|小于

tol。

版本1.2中更改:默认值从1e-3更改为1e-4,以便与其他线性模型保持一致。

- solver{‘auto’, ‘svd’, ‘cholesky’, ‘lsqr’, ‘sparse_cg’, ‘sag’, ‘saga’, ‘lbfgs’}, default=’auto’

计算例程中使用的求解器

‘auto’根据数据类型自动选择求解器。

‘svd’使用X的奇异值分解来计算岭系数。它是最稳定的求解器,对于奇异矩阵比‘cholesky’更稳定,代价是速度较慢。

‘cholesky’使用标准的

scipy.linalg.solve函数来获得闭式解。‘sparse_cg’使用

scipy.sparse.linalg.cg中的共轭梯度求解器。作为迭代算法,该求解器比‘cholesky’更适合大规模数据(可以设置tol和max_iter)。‘lsqr’使用专用的正则化最小二乘例程

scipy.sparse.linalg.lsqr。它是最快的,并使用迭代过程。‘sag’使用随机平均梯度下降(Stochastic Average Gradient descent),‘saga’使用其改进的无偏版本SAGA。这两种方法也都使用迭代过程,当n_samples和n_features都很大时,通常比其他求解器更快。请注意,‘sag’和‘saga’的快速收敛仅在特征具有大致相同尺度时得到保证。您可以使用

sklearn.preprocessing中的缩放器对数据进行预处理。‘lbfgs’使用

scipy.optimize.minimize中实现的L-BFGS-B算法。仅当positive为True时才能使用。

除‘svd’外的所有求解器都支持密集和稀疏数据。然而,只有‘lsqr’、‘sag’、‘sparse_cg’和‘lbfgs’在

fit_intercept为True时支持稀疏输入。版本0.17中新增:随机平均梯度下降求解器。

版本0.19中新增:SAGA求解器。

- positivebool, default=False

当设置为

True时,强制系数为正数。在这种情况下仅支持‘lbfgs’求解器。- random_stateint, RandomState instance, default=None

当

solver== ‘sag’或‘saga’时用于打乱数据。有关详细信息,请参阅词汇表。版本0.17中新增:

random_state以支持随机平均梯度。

- 属性:

- coef_ndarray of shape (n_features,) or (n_targets, n_features)

权重向量。

- intercept_float or ndarray of shape (n_targets,)

决策函数中的独立项。如果

fit_intercept = False,则设置为0.0。- n_iter_None or ndarray of shape (n_targets,)

每个目标的实际迭代次数。仅适用于‘sag’和‘lsqr’求解器。其他求解器将返回None。

版本0.17中新增。

- n_features_in_int

在 拟合 期间看到的特征数。

0.24 版本新增。

- feature_names_in_shape 为 (

n_features_in_,) 的 ndarray 在 fit 期间看到的特征名称。仅当

X具有全部为字符串的特征名称时才定义。1.0 版本新增。

- solver_str

拟合时由计算例程使用的求解器。

1.5 版本新增。

另请参阅

RidgeClassifier岭分类器。

RidgeCV内置交叉验证的岭回归。

KernelRidge核岭回归将岭回归与核技巧结合起来。

注意事项

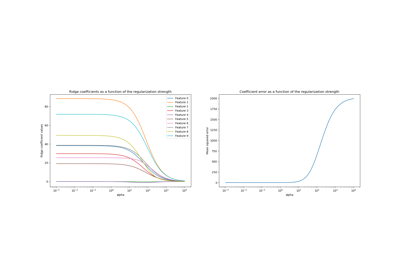

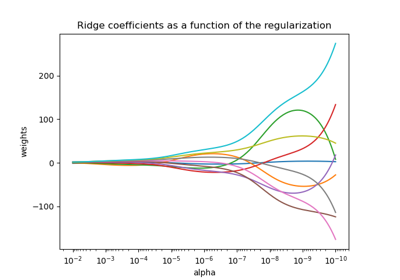

正则化改善了问题的条件性,并减少了估计量的方差。较大的值指定更强的正则化。Alpha对应于

LogisticRegression或LinearSVC等其他线性模型中的1 / (2C)。示例

>>> from sklearn.linear_model import Ridge >>> import numpy as np >>> n_samples, n_features = 10, 5 >>> rng = np.random.RandomState(0) >>> y = rng.randn(n_samples) >>> X = rng.randn(n_samples, n_features) >>> clf = Ridge(alpha=1.0) >>> clf.fit(X, y) Ridge()

- fit(X, y, sample_weight=None)[source]#

拟合岭回归模型。

- 参数:

- X{ndarray, sparse matrix} of shape (n_samples, n_features)

训练数据。

- yndarray of shape (n_samples,) or (n_samples, n_targets)

目标值。

- sample_weightfloat or ndarray of shape (n_samples,), default=None

每个样本的单独权重。如果给定一个浮点数,每个样本将具有相同的权重。

- 返回:

- selfobject

拟合的估计器。

- get_metadata_routing()[source]#

获取此对象的元数据路由。

请查阅 用户指南,了解路由机制如何工作。

- 返回:

- routingMetadataRequest

封装路由信息的

MetadataRequest。

- get_params(deep=True)[source]#

获取此估计器的参数。

- 参数:

- deepbool, default=True

如果为 True,将返回此估计器以及包含的子对象(如果它们是估计器)的参数。

- 返回:

- paramsdict

参数名称映射到其值。

- predict(X)[source]#

使用线性模型进行预测。

- 参数:

- Xarray-like or sparse matrix, shape (n_samples, n_features)

样本。

- 返回:

- Carray, shape (n_samples,)

返回预测值。

- score(X, y, sample_weight=None)[source]#

返回测试数据的 决定系数。

决定系数\(R^2\)定义为\((1 - \frac{u}{v})\),其中\(u\)是残差平方和

((y_true - y_pred)** 2).sum(),\(v\)是总平方和((y_true - y_true.mean()) ** 2).sum()。最佳可能分数为1.0,它也可以是负数(因为模型可能任意地差)。一个总是预测y期望值(忽略输入特征)的常数模型将获得0.0的\(R^2\)分数。- 参数:

- Xshape 为 (n_samples, n_features) 的 array-like

测试样本。对于某些估计器,这可能是一个预先计算的核矩阵或一个通用对象列表,形状为

(n_samples, n_samples_fitted),其中n_samples_fitted是用于估计器拟合的样本数。- yshape 为 (n_samples,) 或 (n_samples, n_outputs) 的 array-like

X的真实值。- sample_weightshape 为 (n_samples,) 的 array-like, default=None

样本权重。

- 返回:

- scorefloat

self.predict(X)相对于y的 \(R^2\)。

注意事项

从版本0.23开始,当在回归器上调用

score时使用的\(R^2\)分数使用multioutput='uniform_average',以与r2_score的默认值保持一致。这会影响所有多输出回归器(除了MultiOutputRegressor)的score方法。

- set_fit_request(*, sample_weight: bool | None | str = '$UNCHANGED$') Ridge[source]#

配置是否应请求元数据以传递给

fit方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给fit。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给fit。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

fit方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。

- set_params(**params)[source]#

设置此估计器的参数。

此方法适用于简单的估计器以及嵌套对象(如

Pipeline)。后者具有<component>__<parameter>形式的参数,以便可以更新嵌套对象的每个组件。- 参数:

- **paramsdict

估计器参数。

- 返回:

- selfestimator instance

估计器实例。

- set_score_request(*, sample_weight: bool | None | str = '$UNCHANGED$') Ridge[source]#

配置是否应请求元数据以传递给

score方法。请注意,此方法仅在以下情况下相关:此估计器用作 元估计器 中的子估计器,并且通过

enable_metadata_routing=True启用了元数据路由(请参阅sklearn.set_config)。请查看 用户指南 以了解路由机制的工作原理。每个参数的选项如下:

True:请求元数据,如果提供则传递给score。如果未提供元数据,则忽略该请求。False:不请求元数据,元估计器不会将其传递给score。None:不请求元数据,如果用户提供元数据,元估计器将引发错误。str:应将元数据以给定别名而不是原始名称传递给元估计器。

默认值 (

sklearn.utils.metadata_routing.UNCHANGED) 保留现有请求。这允许您更改某些参数的请求而不更改其他参数。在版本 1.3 中新增。

- 参数:

- sample_weightstr, True, False, or None, default=sklearn.utils.metadata_routing.UNCHANGED

score方法中sample_weight参数的元数据路由。

- 返回:

- selfobject

更新后的对象。