LedoitWolf#

- class sklearn.covariance.LedoitWolf(*, store_precision=True, assume_centered=False, block_size=1000)[源]#

LedoitWolf 估计器。

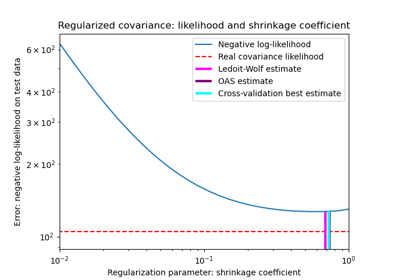

Ledoit-Wolf 是一种特殊的收缩形式,其收缩系数是根据 O. Ledoit 和 M. Wolf 在“大型协方差矩阵的良好条件估计器”(Ledoit 和 Wolf,Journal of Multivariate Analysis,第 88 卷,第 2 期,2004 年 2 月,第 365-411 页)中描述的公式计算得出的。

在用户指南中阅读更多内容。

- 参数:

- store_precisionbool, 默认=True

指定是否存储估计的精度矩阵。

- assume_centeredbool, 默认=False

如果为 True,数据在计算前不会被中心化。当处理均值几乎为零但不完全为零的数据时很有用。如果为 False(默认),数据在计算前会被中心化。

- block_sizeint, 默认=1000

在 Ledoit-Wolf 估计过程中,协方差矩阵将被分割成块的大小。这纯粹是内存优化,不影响结果。

- 属性:

- covariance_形状为 (n_features, n_features) 的 ndarray

估计的协方差矩阵。

- location_形状为 (n_features,) 的 ndarray

估计的位置,即估计的均值。

- precision_形状为 (n_features, n_features) 的 ndarray

估计的伪逆矩阵。(仅当 store_precision 为 True 时存储)

- shrinkage_float

用于计算收缩估计的凸组合系数。范围是 [0, 1]。

- n_features_in_int

拟合期间观察到的特征数量。

版本 0.24 中新增。

- feature_names_in_形状为 (

n_features_in_,) 的 ndarray 拟合期间观察到的特征名称。仅当

X的所有特征名称均为字符串时才定义。版本 1.0 中新增。

另请参阅

EllipticEnvelope用于检测高斯分布数据集中异常值的对象。

EmpiricalCovariance最大似然协方差估计器。

GraphicalLasso使用 l1-惩罚估计器进行稀疏逆协方差估计。

GraphicalLassoCV通过交叉验证选择 l1 惩罚的稀疏逆协方差。

MinCovDet最小协方差行列式(稳健的协方差估计器)。

OASOracle 近似收缩估计器。

ShrunkCovariance带收缩的协方差估计器。

注释

正则化协方差为

(1 - shrinkage) * cov + shrinkage * mu * np.identity(n_features)

其中 mu = trace(cov) / n_features,shrinkage 由 Ledoit 和 Wolf 公式给出(参见参考文献)

参考文献

“A Well-Conditioned Estimator for Large-Dimensional Covariance Matrices”, Ledoit and Wolf, Journal of Multivariate Analysis, Volume 88, Issue 2, February 2004, pages 365-411.

示例

>>> import numpy as np >>> from sklearn.covariance import LedoitWolf >>> real_cov = np.array([[.4, .2], ... [.2, .8]]) >>> np.random.seed(0) >>> X = np.random.multivariate_normal(mean=[0, 0], ... cov=real_cov, ... size=50) >>> cov = LedoitWolf().fit(X) >>> cov.covariance_ array([[0.4406, 0.1616], [0.1616, 0.8022]]) >>> cov.location_ array([ 0.0595 , -0.0075])

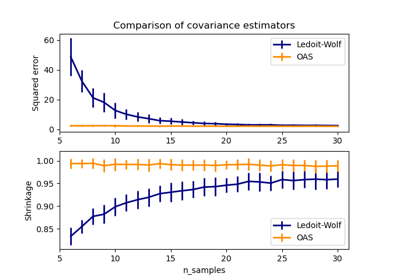

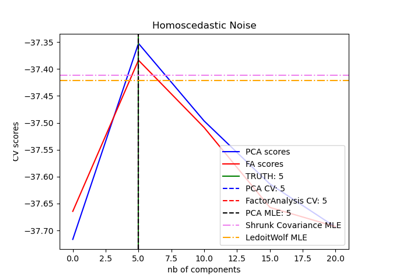

另请参阅收缩协方差估计:LedoitWolf vs OAS 和最大似然和Ledoit-Wolf vs OAS 估计以获取更详细的示例。

- error_norm(comp_cov, norm='frobenius', scaling=True, squared=True)[源]#

计算两个协方差估计器之间的均方误差。

- 参数:

- comp_cov形状为 (n_features, n_features) 的类数组

要比较的协方差。

- norm{“frobenius”, “spectral”}, 默认=”frobenius”

用于计算误差的范数类型。可用的误差类型:- 'frobenius'(默认):sqrt(tr(A^t.A)) - 'spectral':sqrt(max(eigenvalues(A^t.A)),其中 A 是误差

(comp_cov - self.covariance_)。- scalingbool, 默认=True

如果为 True(默认),则平方误差范数除以 n_features。如果为 False,则平方误差范数不重新缩放。

- squaredbool, 默认=True

是否计算平方误差范数或误差范数。如果为 True(默认),则返回平方误差范数。如果为 False,则返回误差范数。

- 返回:

- resultfloat

self和comp_cov协方差估计器之间的均方误差(Frobenius 范数意义上的)。

- fit(X, y=None)[源]#

将 Ledoit-Wolf 收缩协方差模型拟合到 X。

- 参数:

- X形状为 (n_samples, n_features) 的类数组

训练数据,其中

n_samples是样本数,n_features是特征数。- y忽略

未使用,根据 API 惯例存在。

- 返回:

- self对象

返回实例本身。

- get_metadata_routing()[源]#

获取此对象的元数据路由。

请查阅用户指南,了解路由机制的工作原理。

- 返回:

- routingMetadataRequest

一个包含路由信息的

MetadataRequest对象。

- get_params(deep=True)[源]#

获取此估计器的参数。

- 参数:

- deepbool, 默认=True

如果为 True,将返回此估计器及其包含的子估计器的参数。

- 返回:

- paramsdict

参数名称映射到其值。

- mahalanobis(X)[源]#

计算给定观测值的马哈拉诺比斯距离平方。

- 参数:

- X形状为 (n_samples, n_features) 的类数组

我们计算其马哈拉诺比斯距离的观测值。假设观测值来自与拟合中使用的数据相同的分布。

- 返回:

- dist形状为 (n_samples,) 的 ndarray

观测值的马哈拉诺比斯距离平方。

- score(X_test, y=None)[源]#

计算在估计高斯模型下

X_test的对数似然。高斯模型由其均值和协方差矩阵定义,分别由

self.location_和self.covariance_表示。X_test被假定来自与拟合中使用的数据相同的分布(包括中心化)。- 参数:

- X_test形状为 (n_samples, n_features) 的类数组

用于计算似然的测试数据,其中

n_samples是样本数,n_features是特征数。- y忽略

未使用,根据 API 惯例存在。

- 返回:

- resfloat

在以

self.location_和self.covariance_分别作为高斯模型均值和协方差矩阵估计器时,X_test的对数似然。