注意

转到末尾 下载完整示例代码。或通过 JupyterLite 或 Binder 在浏览器中运行此示例

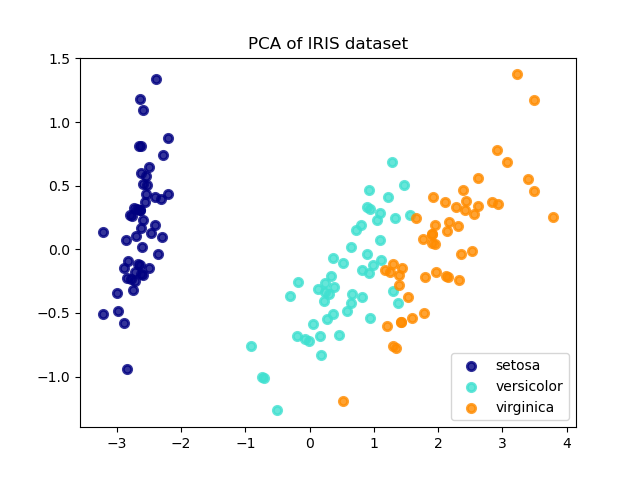

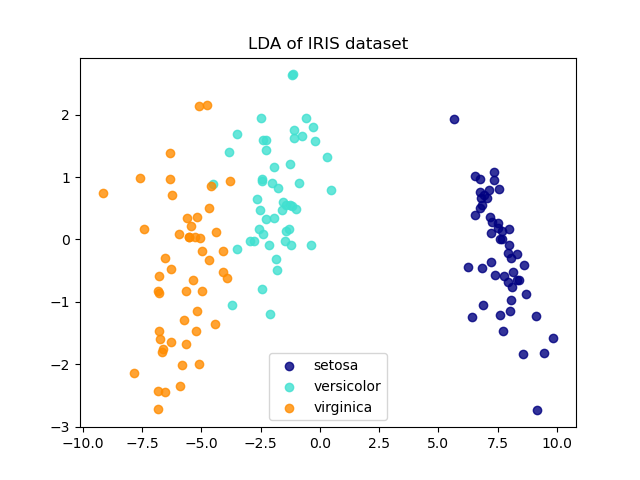

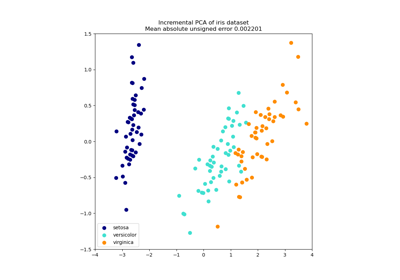

LDA 和 PCA 对鸢尾花数据集的 2D 投影比较#

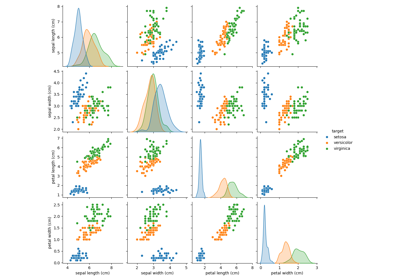

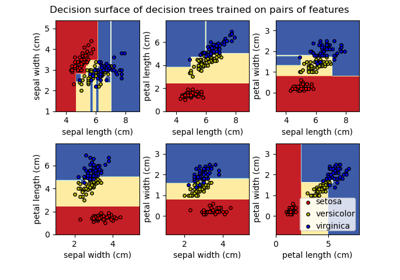

鸢尾花数据集包含 3 种鸢尾花(Setosa、Versicolour 和 Virginica),每种花有 4 个属性:萼片长度、萼片宽度、花瓣长度和花瓣宽度。

将主成分分析 (PCA) 应用于此数据,可识别出能解释数据中最大方差的属性组合(主成分,或特征空间中的方向)。这里我们在前两个主成分上绘制了不同的样本。

线性判别分析 (LDA) 尝试识别能解释类别之间最大方差的属性。特别是,与 PCA 相比,LDA 是一种有监督方法,它使用已知的类别标签。

explained variance ratio (first two components): [0.92461872 0.05306648]

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn.decomposition import PCA

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

iris = datasets.load_iris()

X = iris.data

y = iris.target

target_names = iris.target_names

pca = PCA(n_components=2)

X_r = pca.fit(X).transform(X)

lda = LinearDiscriminantAnalysis(n_components=2)

X_r2 = lda.fit(X, y).transform(X)

# Percentage of variance explained for each components

print(

"explained variance ratio (first two components): %s"

% str(pca.explained_variance_ratio_)

)

plt.figure()

colors = ["navy", "turquoise", "darkorange"]

lw = 2

for color, i, target_name in zip(colors, [0, 1, 2], target_names):

plt.scatter(

X_r[y == i, 0], X_r[y == i, 1], color=color, alpha=0.8, lw=lw, label=target_name

)

plt.legend(loc="best", shadow=False, scatterpoints=1)

plt.title("PCA of IRIS dataset")

plt.figure()

for color, i, target_name in zip(colors, [0, 1, 2], target_names):

plt.scatter(

X_r2[y == i, 0], X_r2[y == i, 1], alpha=0.8, color=color, label=target_name

)

plt.legend(loc="best", shadow=False, scatterpoints=1)

plt.title("LDA of IRIS dataset")

plt.show()

脚本总运行时间: (0 分 0.183 秒)

相关示例