注意

滚动到底部下载完整示例代码,或通过 JupyterLite 或 Binder 在浏览器中运行此示例。

决策树回归#

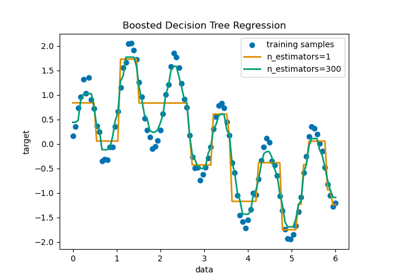

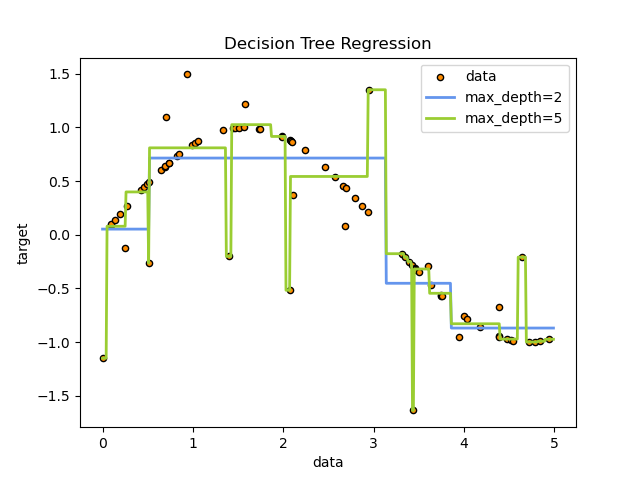

在本示例中,我们将演示更改决策树的最大深度如何影响其对数据的拟合效果。我们将在一个一维回归任务上执行此操作,并在一个多输出回归任务上执行此操作。

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

一维回归任务上的决策树#

在这里,我们在一个一维回归任务上拟合一个决策树。

决策树用于拟合带有噪声观测值的正弦曲线。因此,它学习近似正弦曲线的局部线性回归。

我们可以看到,如果树的最大深度(由 max_depth 参数控制)设置得过高,决策树会学习训练数据过于细致的细节,并从噪声中学习,即它们会过拟合。

创建随机一维数据集#

import numpy as np

rng = np.random.RandomState(1)

X = np.sort(5 * rng.rand(80, 1), axis=0)

y = np.sin(X).ravel()

y[::5] += 3 * (0.5 - rng.rand(16))

拟合回归模型#

这里我们拟合了两个不同最大深度的模型

from sklearn.tree import DecisionTreeRegressor

regr_1 = DecisionTreeRegressor(max_depth=2)

regr_2 = DecisionTreeRegressor(max_depth=5)

regr_1.fit(X, y)

regr_2.fit(X, y)

预测#

获取测试集上的预测

X_test = np.arange(0.0, 5.0, 0.01)[:, np.newaxis]

y_1 = regr_1.predict(X_test)

y_2 = regr_2.predict(X_test)

绘制结果#

import matplotlib.pyplot as plt

plt.figure()

plt.scatter(X, y, s=20, edgecolor="black", c="darkorange", label="data")

plt.plot(X_test, y_1, color="cornflowerblue", label="max_depth=2", linewidth=2)

plt.plot(X_test, y_2, color="yellowgreen", label="max_depth=5", linewidth=2)

plt.xlabel("data")

plt.ylabel("target")

plt.title("Decision Tree Regression")

plt.legend()

plt.show()

正如您所看到的,深度为 5(黄色)的模型学习了训练数据的细节,以至于对噪声过拟合。另一方面,深度为 2(蓝色)的模型很好地学习了数据的主要趋势,并且没有过拟合。在实际使用案例中,您需要确保树没有对训练数据过拟合,这可以通过交叉验证来完成。

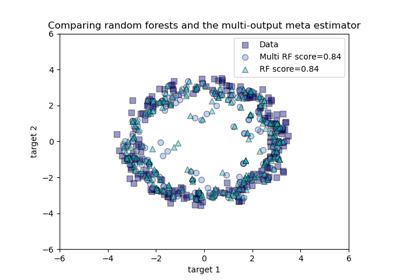

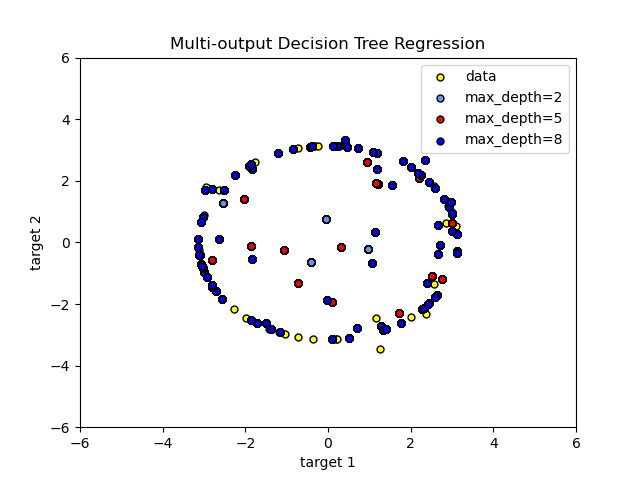

多输出目标决策树回归#

在这里,决策树用于同时预测给定单一底层特征的圆形噪声 x 和 y 观测值。因此,它学习近似圆形的局部线性回归。

我们可以看到,如果树的最大深度(由 max_depth 参数控制)设置得过高,决策树会学习训练数据过于细致的细节,并从噪声中学习,即它们会过拟合。

创建随机数据集#

拟合回归模型#

regr_1 = DecisionTreeRegressor(max_depth=2)

regr_2 = DecisionTreeRegressor(max_depth=5)

regr_3 = DecisionTreeRegressor(max_depth=8)

regr_1.fit(X, y)

regr_2.fit(X, y)

regr_3.fit(X, y)

预测#

获取测试集上的预测

X_test = np.arange(-100.0, 100.0, 0.01)[:, np.newaxis]

y_1 = regr_1.predict(X_test)

y_2 = regr_2.predict(X_test)

y_3 = regr_3.predict(X_test)

绘制结果#

plt.figure()

s = 25

plt.scatter(y[:, 0], y[:, 1], c="yellow", s=s, edgecolor="black", label="data")

plt.scatter(

y_1[:, 0],

y_1[:, 1],

c="cornflowerblue",

s=s,

edgecolor="black",

label="max_depth=2",

)

plt.scatter(y_2[:, 0], y_2[:, 1], c="red", s=s, edgecolor="black", label="max_depth=5")

plt.scatter(y_3[:, 0], y_3[:, 1], c="blue", s=s, edgecolor="black", label="max_depth=8")

plt.xlim([-6, 6])

plt.ylim([-6, 6])

plt.xlabel("target 1")

plt.ylabel("target 2")

plt.title("Multi-output Decision Tree Regression")

plt.legend(loc="best")

plt.show()

正如您所看到的,max_depth 的值越高,模型捕捉到的数据细节就越多。然而,模型也会对数据过拟合,并受到噪声的影响。

脚本总运行时间: (0 分钟 0.291 秒)

相关示例