注意

转到末尾 下载完整的示例代码或通过 JupyterLite 或 Binder 在浏览器中运行此示例。

使用分类器链进行多标签分类#

此示例展示了如何使用 ClassifierChain 来解决多标签分类问题。

解决此类任务最天真的策略是针对每个标签(即目标变量的每列)独立训练一个二元分类器。在预测时,使用二元分类器集成来组装多任务预测。

这种策略不允许对不同任务之间的关系进行建模。ClassifierChain 是元估计器(即采用内部估计器的估计器),它实现了更高级的策略。二元分类器集成被用作一个链,其中链中一个分类器的预测被用作训练下一个分类器新标签的特征。因此,这些额外的特征允许每个链利用标签之间的相关性。

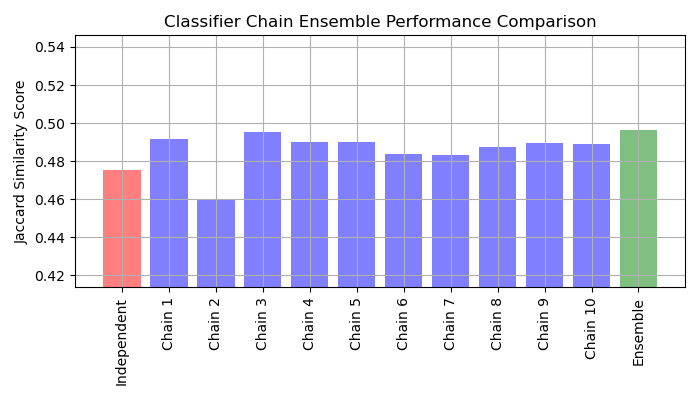

链的 Jaccard 相似度得分往往大于独立基模型集合的得分。

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

加载数据集#

对于此示例,我们使用 yeast 数据集,其中包含 2,417 个数据点,每个数据点有 103 个特征和 14 个可能的标签。每个数据点至少有一个标签。作为基线,我们首先为 14 个标签中的每一个训练一个逻辑回归分类器。为了评估这些分类器的性能,我们在保留的测试集上进行预测,并计算每个样本的 Jaccard 相似度。

import matplotlib.pyplot as plt

import numpy as np

from sklearn.datasets import fetch_openml

from sklearn.model_selection import train_test_split

# Load a multi-label dataset from https://www.openml.org/d/40597

X, Y = fetch_openml("yeast", version=4, return_X_y=True)

Y = Y == "TRUE"

X_train, X_test, Y_train, Y_test = train_test_split(X, Y, test_size=0.2, random_state=0)

拟合模型#

我们拟合由 OneVsRestClassifier 包装的 LogisticRegression 和多个 ClassifierChain 的集成。

由 OneVsRestClassifier 包装的 LogisticRegression#

由于默认情况下 LogisticRegression 无法处理具有多个目标的数据,我们需要使用 OneVsRestClassifier。拟合模型后,我们计算 Jaccard 相似度。

from sklearn.linear_model import LogisticRegression

from sklearn.metrics import jaccard_score

from sklearn.multiclass import OneVsRestClassifier

base_lr = LogisticRegression()

ovr = OneVsRestClassifier(base_lr)

ovr.fit(X_train, Y_train)

Y_pred_ovr = ovr.predict(X_test)

ovr_jaccard_score = jaccard_score(Y_test, Y_pred_ovr, average="samples")

二元分类器链#

由于每个链中的模型是随机排列的,因此链之间的性能存在显著差异。据推测,链中类的最佳排序将产生最佳性能。然而,我们先验地不知道这种排序。相反,我们可以通过对链的二元预测求平均值并应用 0.5 的阈值来构建分类器链的投票集成。集成的 Jaccard 相似度得分大于独立模型的得分,并且往往超过集成中每个链的得分(尽管这对于随机排序的链不能保证)。

from sklearn.multioutput import ClassifierChain

chains = [ClassifierChain(base_lr, order="random", random_state=i) for i in range(10)]

for chain in chains:

chain.fit(X_train, Y_train)

Y_pred_chains = np.array([chain.predict_proba(X_test) for chain in chains])

chain_jaccard_scores = [

jaccard_score(Y_test, Y_pred_chain >= 0.5, average="samples")

for Y_pred_chain in Y_pred_chains

]

Y_pred_ensemble = Y_pred_chains.mean(axis=0)

ensemble_jaccard_score = jaccard_score(

Y_test, Y_pred_ensemble >= 0.5, average="samples"

)

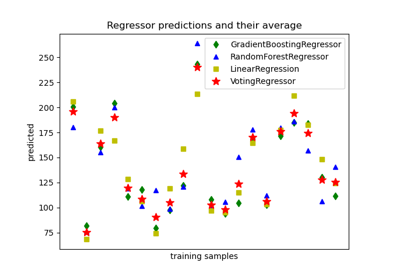

绘制结果#

绘制独立模型、每个链和集成的 Jaccard 相似度得分(请注意,此图上的垂直轴不是从 0 开始的)。

model_scores = [ovr_jaccard_score] + chain_jaccard_scores + [ensemble_jaccard_score]

model_names = (

"Independent",

"Chain 1",

"Chain 2",

"Chain 3",

"Chain 4",

"Chain 5",

"Chain 6",

"Chain 7",

"Chain 8",

"Chain 9",

"Chain 10",

"Ensemble",

)

x_pos = np.arange(len(model_names))

fig, ax = plt.subplots(figsize=(7, 4))

ax.grid(True)

ax.set_title("Classifier Chain Ensemble Performance Comparison")

ax.set_xticks(x_pos)

ax.set_xticklabels(model_names, rotation="vertical")

ax.set_ylabel("Jaccard Similarity Score")

ax.set_ylim([min(model_scores) * 0.9, max(model_scores) * 1.1])

colors = ["r"] + ["b"] * len(chain_jaccard_scores) + ["g"]

ax.bar(x_pos, model_scores, alpha=0.5, color=colors)

plt.tight_layout()

plt.show()

结果解读#

此图有三个主要的启示

由

OneVsRestClassifier包装的独立模型性能不如分类器链集成和一些单个链。这是因为逻辑回归没有对标签之间的关系进行建模。ClassifierChain利用了标签之间的相关性,但由于标签排序的随机性,它可能会产生比独立模型更差的结果。链集成表现更好,因为它不仅捕获了标签之间的关系,而且没有对它们的正确顺序做出强烈的假设。

脚本总运行时间: (0 分钟 1.655 秒)

相关示例