注意

转到末尾以下载完整示例代码或通过 JupyterLite 或 Binder 在浏览器中运行此示例。

使用堆叠法组合预测器#

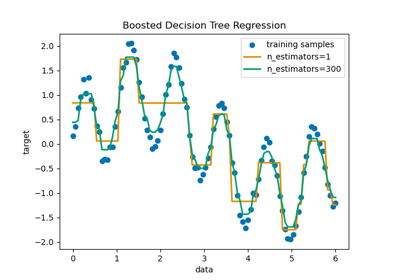

堆叠(Stacking)指的是一种混合估计器的方法。在这种策略中,一些估计器分别在训练数据上进行拟合,而一个最终估计器则使用这些基础估计器的堆叠预测结果进行训练。

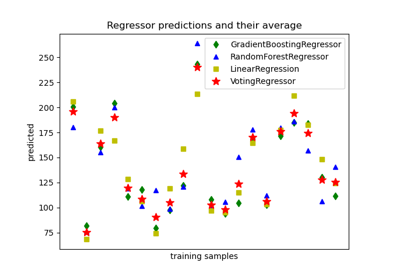

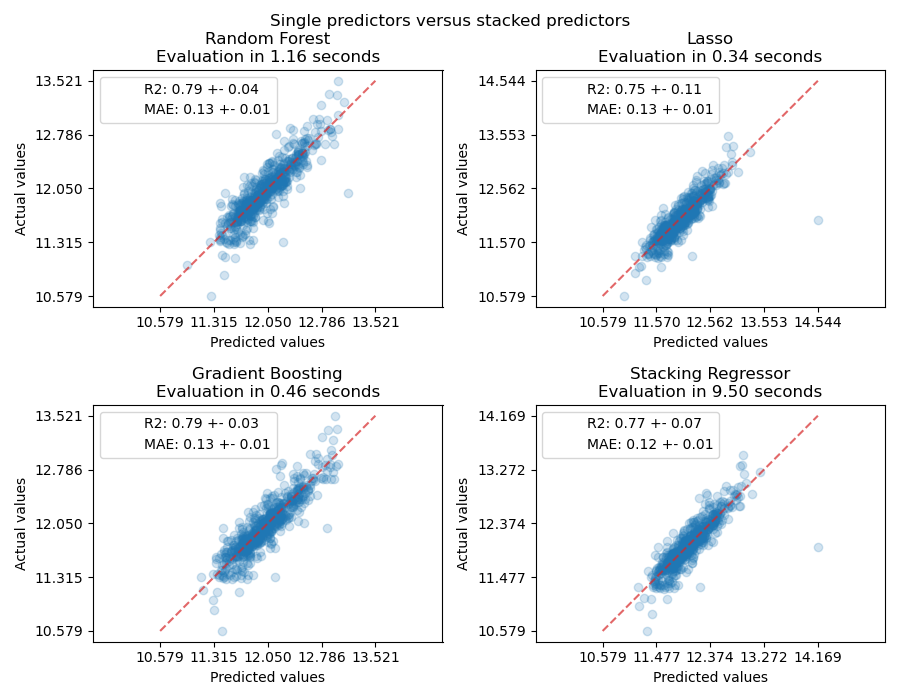

在本例中,我们演示了将不同的回归器堆叠在一起,并使用一个最终的线性惩罚回归器来输出预测结果的用例。我们将比较每个单独回归器的性能与堆叠策略的性能。堆叠略微提高了整体性能。

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

下载数据集#

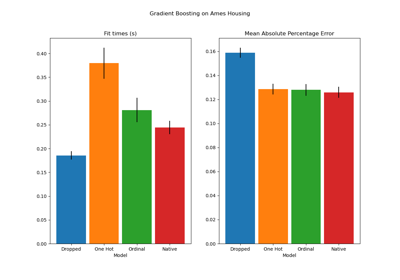

我们将使用 Ames Housing 数据集,该数据集最初由 Dean De Cock 汇编,并在 Kaggle 挑战中使用后变得广为人知。它包含爱荷华州埃姆斯市的 1460 栋住宅,每栋住宅都由 80 个特征描述。我们将使用它来预测房屋的最终对数价格。在本例中,我们将仅使用通过 GradientBoostingRegressor() 选择的 20 个最有趣的特征,并限制条目数量(在这里我们不会深入探讨如何选择最有趣的特征)。

scikit-learn 中不附带 Ames housing 数据集,因此我们将从 OpenML 获取它。

import numpy as np

from sklearn.datasets import fetch_openml

from sklearn.utils import shuffle

def load_ames_housing():

df = fetch_openml(name="house_prices", as_frame=True)

X = df.data

y = df.target

features = [

"YrSold",

"HeatingQC",

"Street",

"YearRemodAdd",

"Heating",

"MasVnrType",

"BsmtUnfSF",

"Foundation",

"MasVnrArea",

"MSSubClass",

"ExterQual",

"Condition2",

"GarageCars",

"GarageType",

"OverallQual",

"TotalBsmtSF",

"BsmtFinSF1",

"HouseStyle",

"MiscFeature",

"MoSold",

]

X = X.loc[:, features]

X, y = shuffle(X, y, random_state=0)

X = X.iloc[:600]

y = y.iloc[:600]

return X, np.log(y)

X, y = load_ames_housing()

创建用于数据预处理的管道#

在使用 Ames 数据集之前,我们仍然需要进行一些预处理。首先,我们将选择数据集中的分类和数值列,以构建管道的第一步。

from sklearn.compose import make_column_selector

cat_selector = make_column_selector(dtype_include=[object, "string"])

num_selector = make_column_selector(dtype_include=np.number)

cat_selector(X)

['HeatingQC', 'Street', 'Heating', 'MasVnrType', 'Foundation', 'ExterQual', 'Condition2', 'GarageType', 'HouseStyle', 'MiscFeature']

num_selector(X)

['YrSold', 'YearRemodAdd', 'BsmtUnfSF', 'MasVnrArea', 'MSSubClass', 'GarageCars', 'OverallQual', 'TotalBsmtSF', 'BsmtFinSF1', 'MoSold']

然后,我们需要设计取决于最终回归器的预处理管道。如果最终回归器是线性模型,则需要对类别进行独热编码。如果最终回归器是基于树的模型,则序数编码器就足够了。此外,对于线性模型,数值需要标准化,而基于树的模型可以直接处理原始数值数据。然而,两种模型都需要一个 impute 来处理缺失值。

我们将首先设计基于树的模型所需的管道。

from sklearn.compose import make_column_transformer

from sklearn.impute import SimpleImputer

from sklearn.pipeline import make_pipeline

from sklearn.preprocessing import OrdinalEncoder

cat_tree_processor = OrdinalEncoder(

handle_unknown="use_encoded_value",

unknown_value=-1,

encoded_missing_value=-2,

)

num_tree_processor = SimpleImputer(strategy="mean", add_indicator=True)

tree_preprocessor = make_column_transformer(

(num_tree_processor, num_selector), (cat_tree_processor, cat_selector)

)

tree_preprocessor

ColumnTransformer(transformers=[('simpleimputer',

SimpleImputer(add_indicator=True),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('ordinalencoder',

OrdinalEncoder(encoded_missing_value=-2,

handle_unknown='use_encoded_value',

unknown_value=-1),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>)])在 Jupyter 环境中,请重新运行此单元格以显示 HTML 表示形式或信任 notebook。在 GitHub 上,HTML 表示形式无法渲染,请尝试使用 nbviewer.org 加载此页面。

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

然后,我们将定义当最终回归器是线性模型时使用的预处理器。

from sklearn.preprocessing import OneHotEncoder, StandardScaler

cat_linear_processor = OneHotEncoder(handle_unknown="ignore")

num_linear_processor = make_pipeline(

StandardScaler(), SimpleImputer(strategy="mean", add_indicator=True)

)

linear_preprocessor = make_column_transformer(

(num_linear_processor, num_selector), (cat_linear_processor, cat_selector)

)

linear_preprocessor

ColumnTransformer(transformers=[('pipeline',

Pipeline(steps=[('standardscaler',

StandardScaler()),

('simpleimputer',

SimpleImputer(add_indicator=True))]),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('onehotencoder',

OneHotEncoder(handle_unknown='ignore'),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>)])在 Jupyter 环境中,请重新运行此单元格以显示 HTML 表示形式或信任 notebook。在 GitHub 上,HTML 表示形式无法渲染,请尝试使用 nbviewer.org 加载此页面。

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

在单个数据集上堆叠预测器#

有时很难找到在给定数据集上表现最好的模型。堆叠提供了一种替代方案,它结合了多个学习器的输出,而无需专门选择一个模型。堆叠的性能通常接近于最佳模型,有时甚至可以优于每个单独模型的预测性能。

在这里,我们结合了 3 个学习器(线性和非线性),并使用岭回归器将它们的输出组合在一起。

注意

虽然我们将使用上一节中为 3 个学习器编写的处理器创建新的管道,但最终估计器 RidgeCV() 不需要对数据进行预处理,因为它将使用来自 3 个学习器的已预处理输出。

from sklearn.linear_model import LassoCV

lasso_pipeline = make_pipeline(linear_preprocessor, LassoCV())

lasso_pipeline

Pipeline(steps=[('columntransformer',

ColumnTransformer(transformers=[('pipeline',

Pipeline(steps=[('standardscaler',

StandardScaler()),

('simpleimputer',

SimpleImputer(add_indicator=True))]),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('onehotencoder',

OneHotEncoder(handle_unknown='ignore'),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>)])),

('lassocv', LassoCV())])在 Jupyter 环境中,请重新运行此单元格以显示 HTML 表示形式或信任 notebook。在 GitHub 上,HTML 表示形式无法渲染,请尝试使用 nbviewer.org 加载此页面。

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

参数

from sklearn.ensemble import RandomForestRegressor

rf_pipeline = make_pipeline(tree_preprocessor, RandomForestRegressor(random_state=42))

rf_pipeline

Pipeline(steps=[('columntransformer',

ColumnTransformer(transformers=[('simpleimputer',

SimpleImputer(add_indicator=True),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('ordinalencoder',

OrdinalEncoder(encoded_missing_value=-2,

handle_unknown='use_encoded_value',

unknown_value=-1),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>)])),

('randomforestregressor',

RandomForestRegressor(random_state=42))])在 Jupyter 环境中,请重新运行此单元格以显示 HTML 表示形式或信任 notebook。在 GitHub 上,HTML 表示形式无法渲染,请尝试使用 nbviewer.org 加载此页面。

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

参数

from sklearn.ensemble import HistGradientBoostingRegressor

gbdt_pipeline = make_pipeline(

tree_preprocessor, HistGradientBoostingRegressor(random_state=0)

)

gbdt_pipeline

Pipeline(steps=[('columntransformer',

ColumnTransformer(transformers=[('simpleimputer',

SimpleImputer(add_indicator=True),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('ordinalencoder',

OrdinalEncoder(encoded_missing_value=-2,

handle_unknown='use_encoded_value',

unknown_value=-1),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>)])),

('histgradientboostingregressor',

HistGradientBoostingRegressor(random_state=0))])在 Jupyter 环境中,请重新运行此单元格以显示 HTML 表示形式或信任 notebook。在 GitHub 上,HTML 表示形式无法渲染,请尝试使用 nbviewer.org 加载此页面。

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

参数

from sklearn.ensemble import StackingRegressor

from sklearn.linear_model import RidgeCV

estimators = [

("Random Forest", rf_pipeline),

("Lasso", lasso_pipeline),

("Gradient Boosting", gbdt_pipeline),

]

stacking_regressor = StackingRegressor(estimators=estimators, final_estimator=RidgeCV())

stacking_regressor

StackingRegressor(estimators=[('Random Forest',

Pipeline(steps=[('columntransformer',

ColumnTransformer(transformers=[('simpleimputer',

SimpleImputer(add_indicator=True),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('ordinalencoder',

OrdinalEncoder(encoded_missing_value=-2,

handle_unknown='use_encoded_value',

unknown_v...

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>),

('ordinalencoder',

OrdinalEncoder(encoded_missing_value=-2,

handle_unknown='use_encoded_value',

unknown_value=-1),

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>)])),

('histgradientboostingregressor',

HistGradientBoostingRegressor(random_state=0))]))],

final_estimator=RidgeCV())在 Jupyter 环境中,请重新运行此单元格以显示 HTML 表示形式或信任 notebook。在 GitHub 上,HTML 表示形式无法渲染,请尝试使用 nbviewer.org 加载此页面。

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

参数

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6d10>

参数

<sklearn.compose._column_transformer.make_column_selector object at 0x7fb4868f6010>

参数

参数

参数

测量并绘制结果#

现在我们可以使用 Ames Housing 数据集进行预测。我们检查每个单独预测器以及回归器堆栈的性能。

import time

import matplotlib.pyplot as plt

from sklearn.metrics import PredictionErrorDisplay

from sklearn.model_selection import cross_val_predict, cross_validate

fig, axs = plt.subplots(2, 2, figsize=(9, 7))

axs = np.ravel(axs)

for ax, (name, est) in zip(

axs, estimators + [("Stacking Regressor", stacking_regressor)]

):

scorers = {"R2": "r2", "MAE": "neg_mean_absolute_error"}

start_time = time.time()

scores = cross_validate(

est, X, y, scoring=list(scorers.values()), n_jobs=-1, verbose=0

)

elapsed_time = time.time() - start_time

y_pred = cross_val_predict(est, X, y, n_jobs=-1, verbose=0)

scores = {

key: (

f"{np.abs(np.mean(scores[f'test_{value}'])):.2f} +- "

f"{np.std(scores[f'test_{value}']):.2f}"

)

for key, value in scorers.items()

}

display = PredictionErrorDisplay.from_predictions(

y_true=y,

y_pred=y_pred,

kind="actual_vs_predicted",

ax=ax,

scatter_kwargs={"alpha": 0.2, "color": "tab:blue"},

line_kwargs={"color": "tab:red"},

)

ax.set_title(f"{name}\nEvaluation in {elapsed_time:.2f} seconds")

for name, score in scores.items():

ax.plot([], [], " ", label=f"{name}: {score}")

ax.legend(loc="upper left")

plt.suptitle("Single predictors versus stacked predictors")

plt.tight_layout()

plt.subplots_adjust(top=0.9)

plt.show()

堆叠回归器将结合不同回归器的优势。然而,我们也看到训练堆叠回归器在计算上要昂贵得多。

脚本总运行时间: (0 minutes 19.441 seconds)

相关示例