注意

转到末尾以下载完整示例代码或通过 JupyterLite 或 Binder 在浏览器中运行此示例。

使用 k-means 聚类文本文档#

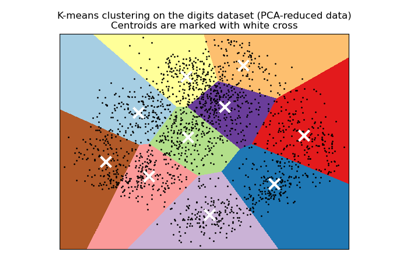

此示例展示了如何使用 scikit-learn API,通过词袋方法按主题对文档进行聚类。

演示了两种算法,即 KMeans 及其更具可伸缩性的变体 MiniBatchKMeans。此外,还使用潜在语义分析来降维并发现数据中的潜在模式。

此示例使用两种不同的文本向量化器:TfidfVectorizer 和 HashingVectorizer。有关向量化器的更多信息以及它们的处理时间比较,请参阅示例 notebook FeatureHasher 和 DictVectorizer 比较。

有关通过监督学习方法进行文档分析的信息,请参阅示例脚本 使用稀疏特征对文本文档进行分类。

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

加载文本数据#

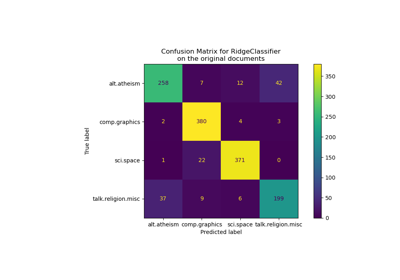

我们从20 newsgroups 文本数据集加载数据,该数据集包含大约 18,000 条关于 20 个主题的新闻组帖子。出于说明目的并降低计算成本,我们只选择 4 个主题的子集,总共约 3,400 个文档。要了解这些主题的重叠情况,请参阅示例 使用稀疏特征对文本文档进行分类。

请注意,默认情况下,文本样本包含一些消息元数据,例如 "headers"(标题)、"footers"(签名)和 "quotes"(对其他帖子的引用)。我们使用 fetch_20newsgroups 的 remove 参数来删除这些特征,从而使聚类问题更合理。

import numpy as np

from sklearn.datasets import fetch_20newsgroups

categories = [

"alt.atheism",

"talk.religion.misc",

"comp.graphics",

"sci.space",

]

dataset = fetch_20newsgroups(

remove=("headers", "footers", "quotes"),

subset="all",

categories=categories,

shuffle=True,

random_state=42,

)

labels = dataset.target

unique_labels, category_sizes = np.unique(labels, return_counts=True)

true_k = unique_labels.shape[0]

print(f"{len(dataset.data)} documents - {true_k} categories")

3387 documents - 4 categories

量化聚类结果的质量#

在本节中,我们定义一个函数来使用多种指标对不同的聚类管道进行评分。

聚类算法本质上是无监督学习方法。然而,由于我们恰好拥有此特定数据集的类标签,因此可以使用利用这种“监督”基本事实信息的评估指标来量化所得聚类的质量。此类指标的示例如下:

同质性(homogeneity),量化簇包含的成员属于单个类的程度;

完整性(completeness),量化给定类的成员被分配到相同簇的程度;

V-measure,完整性和同质性的调和平均值;

兰德指数(Rand-Index),衡量数据点对根据聚类算法的结果和基本事实类分配一致分组的频率;

调整兰德指数(Adjusted Rand-Index),一种经随机调整的兰德指数,使得随机聚类分配的 ARI 期望值为 0.0。

如果基本事实标签未知,则只能使用模型结果本身进行评估。在这种情况下,轮廓系数(Silhouette Coefficient)会派上用场。有关如何操作的示例,请参阅 使用轮廓分析选择 KMeans 聚类中的簇数。

有关更多参考信息,请参阅 聚类性能评估。

from collections import defaultdict

from time import time

from sklearn import metrics

evaluations = []

evaluations_std = []

def fit_and_evaluate(km, X, name=None, n_runs=5):

name = km.__class__.__name__ if name is None else name

train_times = []

scores = defaultdict(list)

for seed in range(n_runs):

km.set_params(random_state=seed)

t0 = time()

km.fit(X)

train_times.append(time() - t0)

scores["Homogeneity"].append(metrics.homogeneity_score(labels, km.labels_))

scores["Completeness"].append(metrics.completeness_score(labels, km.labels_))

scores["V-measure"].append(metrics.v_measure_score(labels, km.labels_))

scores["Adjusted Rand-Index"].append(

metrics.adjusted_rand_score(labels, km.labels_)

)

scores["Silhouette Coefficient"].append(

metrics.silhouette_score(X, km.labels_, sample_size=2000)

)

train_times = np.asarray(train_times)

print(f"clustering done in {train_times.mean():.2f} ± {train_times.std():.2f} s ")

evaluation = {

"estimator": name,

"train_time": train_times.mean(),

}

evaluation_std = {

"estimator": name,

"train_time": train_times.std(),

}

for score_name, score_values in scores.items():

mean_score, std_score = np.mean(score_values), np.std(score_values)

print(f"{score_name}: {mean_score:.3f} ± {std_score:.3f}")

evaluation[score_name] = mean_score

evaluation_std[score_name] = std_score

evaluations.append(evaluation)

evaluations_std.append(evaluation_std)

对文本特征进行 K-means 聚类#

此示例中使用了两种特征提取方法:

TfidfVectorizer使用内存中的词汇表(一个 Python 字典)将最频繁的词映射到特征索引,从而计算词频(稀疏)矩阵。然后使用逆文档频率 (IDF) 向量对词频进行重新加权,该向量在整个语料库中按特征收集。HashingVectorizer将词频散列到固定的维度空间,可能存在冲突。然后对词频向量进行归一化,使其 l2 范数等于 1(投影到欧几里得单位球体上),这对于 k-means 在高维空间中工作似乎很重要。

此外,可以使用降维对这些提取的特征进行后处理。我们将在下文中探讨这些选择对聚类质量的影响。

使用 TfidfVectorizer 进行特征提取#

我们首先使用字典向量化器以及 TfidfVectorizer 提供的 IDF 归一化来对评估器进行基准测试。

from sklearn.feature_extraction.text import TfidfVectorizer

vectorizer = TfidfVectorizer(

max_df=0.5,

min_df=5,

stop_words="english",

)

t0 = time()

X_tfidf = vectorizer.fit_transform(dataset.data)

print(f"vectorization done in {time() - t0:.3f} s")

print(f"n_samples: {X_tfidf.shape[0]}, n_features: {X_tfidf.shape[1]}")

vectorization done in 0.333 s

n_samples: 3387, n_features: 7929

在忽略出现在超过 50% 文档中的术语(由 max_df=0.5 设置)以及未出现在至少 5 个文档中的术语(由 min_df=5 设置)之后,唯一的术语数 n_features 约为 8,000。我们还可以将 X_tfidf 矩阵的稀疏度量化为非零条目占总元素数的比例。

print(f"{X_tfidf.nnz / np.prod(X_tfidf.shape):.3f}")

0.007

我们发现 X_tfidf 矩阵中约有 0.7% 的条目是非零的。

使用 k-means 聚类稀疏数据#

由于 KMeans 和 MiniBatchKMeans 都优化非凸目标函数,因此不能保证它们的聚类对于给定的随机初始化是最佳的。更进一步地说,在稀疏的高维数据(例如使用词袋方法向量化的文本)上,k-means 可以在极其孤立的数据点上初始化质心。这些数据点可能一直保持它们自己的质心。

以下代码说明了前述现象有时如何导致高度不平衡的簇,具体取决于随机初始化:

from sklearn.cluster import KMeans

for seed in range(5):

kmeans = KMeans(

n_clusters=true_k,

max_iter=100,

n_init=1,

random_state=seed,

).fit(X_tfidf)

cluster_ids, cluster_sizes = np.unique(kmeans.labels_, return_counts=True)

print(f"Number of elements assigned to each cluster: {cluster_sizes}")

print()

print(

"True number of documents in each category according to the class labels: "

f"{category_sizes}"

)

Number of elements assigned to each cluster: [ 481 675 1785 446]

Number of elements assigned to each cluster: [1689 638 480 580]

Number of elements assigned to each cluster: [ 1 1 1 3384]

Number of elements assigned to each cluster: [1887 311 332 857]

Number of elements assigned to each cluster: [ 291 673 1771 652]

True number of documents in each category according to the class labels: [799 973 987 628]

为避免此问题,一种可能性是增加具有独立随机初始化的运行次数 n_init。在这种情况下,将选择具有最佳惯性(k-means 的目标函数)的聚类。

kmeans = KMeans(

n_clusters=true_k,

max_iter=100,

n_init=5,

)

fit_and_evaluate(kmeans, X_tfidf, name="KMeans\non tf-idf vectors")

clustering done in 0.17 ± 0.04 s

Homogeneity: 0.349 ± 0.010

Completeness: 0.398 ± 0.009

V-measure: 0.372 ± 0.009

Adjusted Rand-Index: 0.203 ± 0.017

Silhouette Coefficient: 0.007 ± 0.000

所有这些聚类评估指标的最大值为 1.0(对于完美的聚类结果)。值越高越好。调整兰德指数接近 0.0 的值对应于随机标记。从上面的分数可以看出,聚类分配确实远高于随机水平,但总体质量肯定可以提高。

请记住,类标签可能无法准确反映文档主题,因此使用标签的指标不一定是评估聚类管道质量的最佳方法。

使用 LSA 执行降维#

只要首先降低向量化空间的维度以使 k-means 更稳定,仍然可以使用 n_init=1。为此,我们使用 TruncatedSVD,它适用于词频/tf-idf 矩阵。由于 SVD 结果未归一化,我们重新进行归一化以提高 KMeans 结果。使用 SVD 降低 TF-IDF 文档向量的维度在信息检索和文本挖掘文献中通常被称为潜在语义分析 (LSA)。

from sklearn.decomposition import TruncatedSVD

from sklearn.pipeline import make_pipeline

from sklearn.preprocessing import Normalizer

lsa = make_pipeline(TruncatedSVD(n_components=100), Normalizer(copy=False))

t0 = time()

X_lsa = lsa.fit_transform(X_tfidf)

explained_variance = lsa[0].explained_variance_ratio_.sum()

print(f"LSA done in {time() - t0:.3f} s")

print(f"Explained variance of the SVD step: {explained_variance * 100:.1f}%")

LSA done in 0.336 s

Explained variance of the SVD step: 18.4%

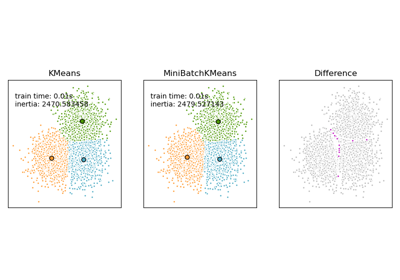

使用单个初始化意味着 KMeans 和 MiniBatchKMeans 的处理时间都会减少。

kmeans = KMeans(

n_clusters=true_k,

max_iter=100,

n_init=1,

)

fit_and_evaluate(kmeans, X_lsa, name="KMeans\nwith LSA on tf-idf vectors")

clustering done in 0.02 ± 0.00 s

Homogeneity: 0.398 ± 0.011

Completeness: 0.427 ± 0.025

V-measure: 0.412 ± 0.017

Adjusted Rand-Index: 0.321 ± 0.018

Silhouette Coefficient: 0.029 ± 0.001

我们可以观察到,对文档的 LSA 表示进行聚类明显更快(既因为 n_init=1,也因为 LSA 特征空间的维度小得多)。此外,所有聚类评估指标都有所改善。我们使用 MiniBatchKMeans 重复实验。

from sklearn.cluster import MiniBatchKMeans

minibatch_kmeans = MiniBatchKMeans(

n_clusters=true_k,

n_init=1,

init_size=1000,

batch_size=1000,

)

fit_and_evaluate(

minibatch_kmeans,

X_lsa,

name="MiniBatchKMeans\nwith LSA on tf-idf vectors",

)

clustering done in 0.02 ± 0.00 s

Homogeneity: 0.333 ± 0.084

Completeness: 0.351 ± 0.066

V-measure: 0.341 ± 0.076

Adjusted Rand-Index: 0.290 ± 0.060

Silhouette Coefficient: 0.026 ± 0.004

每个簇的热门术语#

由于 TfidfVectorizer 可以反转,我们可以识别簇中心,这提供了每个簇最具影响力的词语的直觉。有关与每个目标类最具预测性的词语的比较,请参阅示例脚本 使用稀疏特征对文本文档进行分类。

original_space_centroids = lsa[0].inverse_transform(kmeans.cluster_centers_)

order_centroids = original_space_centroids.argsort()[:, ::-1]

terms = vectorizer.get_feature_names_out()

for i in range(true_k):

print(f"Cluster {i}: ", end="")

for ind in order_centroids[i, :10]:

print(f"{terms[ind]} ", end="")

print()

Cluster 0: thanks graphics image know files file program looking software does

Cluster 1: space launch orbit nasa shuttle earth moon like mission just

Cluster 2: god jesus bible believe christian faith people say does christians

Cluster 3: think don people just say know like time did does

HashingVectorizer#

可以使用 HashingVectorizer 实例进行另一种向量化,它不提供 IDF 加权,因为这是一个无状态模型(fit 方法不执行任何操作)。当需要 IDF 加权时,可以通过将 HashingVectorizer 输出管道化到 TfidfTransformer 实例来添加。在这种情况下,我们还将 LSA 添加到管道中,以减少哈希向量空间的维度和稀疏度。

from sklearn.feature_extraction.text import HashingVectorizer, TfidfTransformer

lsa_vectorizer = make_pipeline(

HashingVectorizer(stop_words="english", n_features=50_000),

TfidfTransformer(),

TruncatedSVD(n_components=100, random_state=0),

Normalizer(copy=False),

)

t0 = time()

X_hashed_lsa = lsa_vectorizer.fit_transform(dataset.data)

print(f"vectorization done in {time() - t0:.3f} s")

vectorization done in 1.647 s

可以观察到 LSA 步骤需要相对较长的时间来拟合,特别是对于哈希向量。原因是哈希空间通常很大(在此示例中设置为 n_features=50_000)。正如示例 notebook FeatureHasher 和 DictVectorizer 比较中所示,可以尝试降低特征数量,但代价是具有更高比例的哈希冲突特征。

我们现在在这些经过哈希-LSA 降维的数据上拟合并评估 kmeans 和 minibatch_kmeans 实例:

fit_and_evaluate(kmeans, X_hashed_lsa, name="KMeans\nwith LSA on hashed vectors")

clustering done in 0.02 ± 0.00 s

Homogeneity: 0.390 ± 0.008

Completeness: 0.436 ± 0.012

V-measure: 0.411 ± 0.010

Adjusted Rand-Index: 0.322 ± 0.014

Silhouette Coefficient: 0.030 ± 0.001

fit_and_evaluate(

minibatch_kmeans,

X_hashed_lsa,

name="MiniBatchKMeans\nwith LSA on hashed vectors",

)

clustering done in 0.02 ± 0.00 s

Homogeneity: 0.359 ± 0.053

Completeness: 0.385 ± 0.059

V-measure: 0.371 ± 0.055

Adjusted Rand-Index: 0.315 ± 0.046

Silhouette Coefficient: 0.029 ± 0.002

两种方法都获得了良好的结果,与在传统 LSA 向量(没有哈希)上运行相同模型的结果相似。

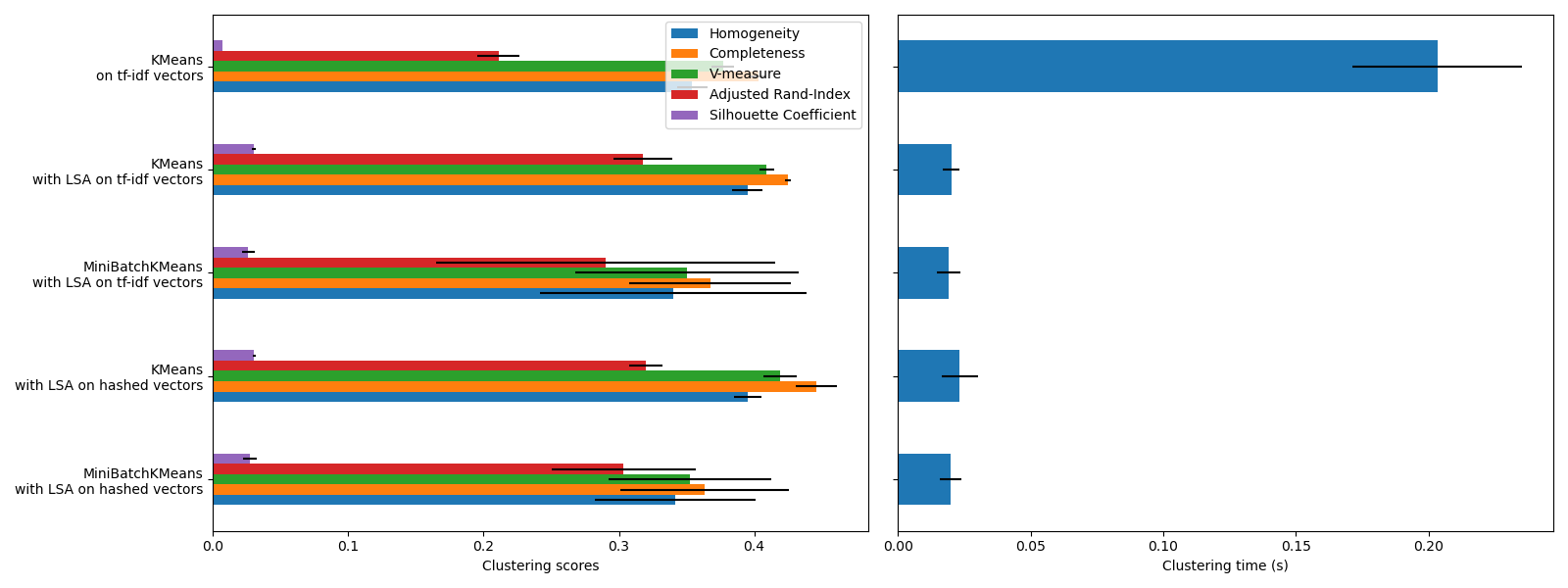

聚类评估摘要#

import matplotlib.pyplot as plt

import pandas as pd

fig, (ax0, ax1) = plt.subplots(ncols=2, figsize=(16, 6), sharey=True)

df = pd.DataFrame(evaluations[::-1]).set_index("estimator")

df_std = pd.DataFrame(evaluations_std[::-1]).set_index("estimator")

df.drop(

["train_time"],

axis="columns",

).plot.barh(ax=ax0, xerr=df_std)

ax0.set_xlabel("Clustering scores")

ax0.set_ylabel("")

df["train_time"].plot.barh(ax=ax1, xerr=df_std["train_time"])

ax1.set_xlabel("Clustering time (s)")

plt.tight_layout()

KMeans 和 MiniBatchKMeans 在高维数据集(例如文本数据)上受到维度灾难现象的影响。这就是为什么使用 LSA 后总体分数有所提高的原因。使用 LSA 降维数据还可以提高稳定性并减少聚类时间,但请记住 LSA 步骤本身需要很长时间,特别是对于哈希向量。

轮廓系数定义在 0 和 1 之间。在所有情况下,我们都获得了接近 0 的值(即使在使用 LSA 后有所改善),因为它的定义需要测量距离,这与 V-measure 和调整兰德指数等其他评估指标不同,后者仅基于簇分配而不是距离。请注意,严格来说,由于它们所隐含的距离概念不同,不应比较不同维度空间中的轮廓系数。

同质性、完整性以及 v-measure 指标没有提供关于随机标记的基线:这意味着根据样本、簇和基本事实类的数量,完全随机的标记不一定会产生相同的值。特别是,随机标记不会产生零分,尤其是在簇数量很大的情况下。当样本数量超过一千且簇数量少于 10 个时,可以安全地忽略此问题,这在本示例中就是这种情况。对于较小的样本量或较大的簇数量,使用调整指数(例如调整兰德指数 (ARI))更安全。有关随机标记影响的演示,请参阅示例 聚类性能评估中的随机调整。

误差条的大小表明,对于这个相对较小的数据集,MiniBatchKMeans 不如 KMeans 稳定。当样本数量大得多时,使用它更有趣,但与传统的 k-means 算法相比,它可能会导致聚类质量略有下降。

脚本总运行时间: (0 minutes 6.559 seconds)

相关示例