注意

转到末尾以下载完整示例代码或通过 JupyterLite 或 Binder 在浏览器中运行此示例。

主成分回归 vs 偏最小二乘回归#

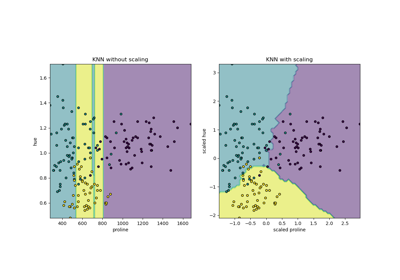

本示例在玩具数据集上比较了主成分回归(PCR)和偏最小二乘回归(PLS)。我们的目标是说明当目标与数据中方差较低的某些方向强相关时,PLS 如何能优于 PCR。

PCR 是一种由两步组成的回归器:首先,将 PCA 应用于训练数据,可能执行降维;然后,在转换后的样本上训练一个回归器(例如线性回归器)。在 PCA 中,转换是纯粹无监督的,这意味着没有使用关于目标的信息。因此,在某些数据集中,当目标与方差较低的*方向*强相关时,PCR 的表现可能不佳。实际上,PCA 的降维将数据投影到一个较低维度的空间中,其中沿每个轴的投影数据方差被贪婪地最大化。尽管方差较低的方向对目标具有最大的预测能力,但它们将被丢弃,最终的回归器将无法利用它们。

PLS 既是转换器也是回归器,它与 PCR 非常相似:它也在将线性回归器应用于转换后的数据之前对样本应用降维。与 PCR 的主要区别在于 PLS 转换是监督式的。因此,正如我们将在此示例中看到的,它不会受到我们刚刚提到的问题的影响。

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

数据#

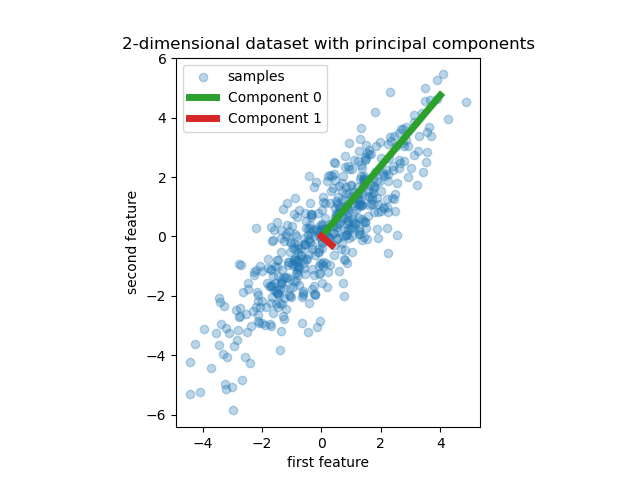

我们首先创建一个具有两个特征的简单数据集。在我们深入研究 PCR 和 PLS 之前,我们拟合一个 PCA 估计器来显示此数据集的两个主成分,即解释数据中最多方差的两个方向。

import matplotlib.pyplot as plt

import numpy as np

from sklearn.decomposition import PCA

rng = np.random.RandomState(0)

n_samples = 500

cov = [[3, 3], [3, 4]]

X = rng.multivariate_normal(mean=[0, 0], cov=cov, size=n_samples)

pca = PCA(n_components=2).fit(X)

plt.scatter(X[:, 0], X[:, 1], alpha=0.3, label="samples")

for i, (comp, var) in enumerate(zip(pca.components_, pca.explained_variance_)):

comp = comp * var # scale component by its variance explanation power

plt.plot(

[0, comp[0]],

[0, comp[1]],

label=f"Component {i}",

linewidth=5,

color=f"C{i + 2}",

)

plt.gca().set(

aspect="equal",

title="2-dimensional dataset with principal components",

xlabel="first feature",

ylabel="second feature",

)

plt.legend()

plt.show()

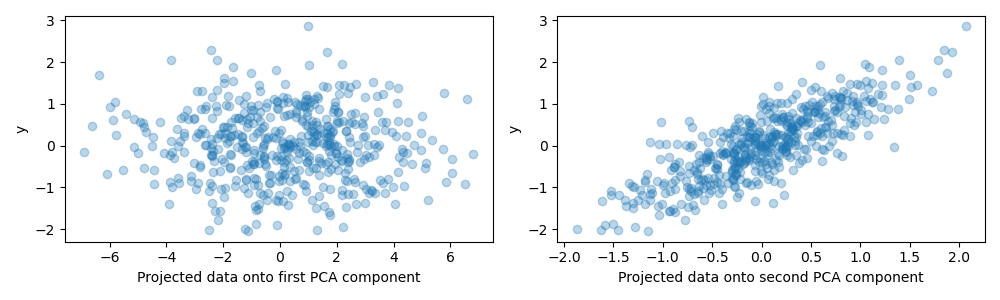

为了本示例的目的,我们现在定义目标 y,使其与方差较小的方向强相关。为此,我们将 X 投影到第二个分量上,并向其中添加一些噪声。

y = X.dot(pca.components_[1]) + rng.normal(size=n_samples) / 2

fig, axes = plt.subplots(1, 2, figsize=(10, 3))

axes[0].scatter(X.dot(pca.components_[0]), y, alpha=0.3)

axes[0].set(xlabel="Projected data onto first PCA component", ylabel="y")

axes[1].scatter(X.dot(pca.components_[1]), y, alpha=0.3)

axes[1].set(xlabel="Projected data onto second PCA component", ylabel="y")

plt.tight_layout()

plt.show()

投影到一个分量上和预测能力#

我们现在创建两个回归器:PCR 和 PLS,为了说明目的,我们将分量数设置为 1。在将数据馈送到 PCR 的 PCA 步骤之前,我们首先对其进行标准化,这是良好实践所推荐的。PLS 估计器具有内置的缩放功能。

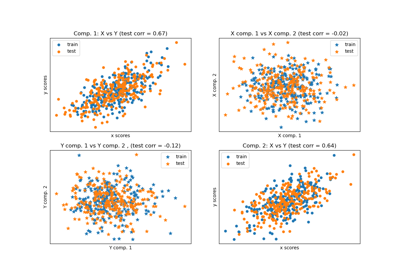

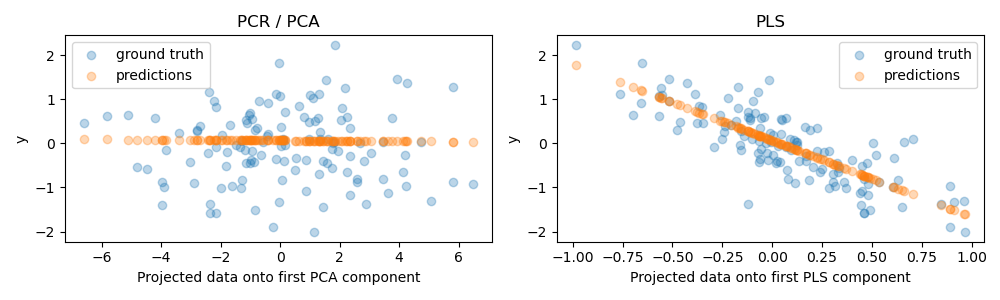

对于这两个模型,我们绘制了投影到第一个分量上的数据与目标的关系图。在这两种情况下,这个投影数据都是回归器将用作训练数据的内容。

from sklearn.cross_decomposition import PLSRegression

from sklearn.decomposition import PCA

from sklearn.linear_model import LinearRegression

from sklearn.model_selection import train_test_split

from sklearn.pipeline import make_pipeline

from sklearn.preprocessing import StandardScaler

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=rng)

pcr = make_pipeline(StandardScaler(), PCA(n_components=1), LinearRegression())

pcr.fit(X_train, y_train)

pca = pcr.named_steps["pca"] # retrieve the PCA step of the pipeline

pls = PLSRegression(n_components=1)

pls.fit(X_train, y_train)

fig, axes = plt.subplots(1, 2, figsize=(10, 3))

axes[0].scatter(pca.transform(X_test), y_test, alpha=0.3, label="ground truth")

axes[0].scatter(

pca.transform(X_test), pcr.predict(X_test), alpha=0.3, label="predictions"

)

axes[0].set(

xlabel="Projected data onto first PCA component", ylabel="y", title="PCR / PCA"

)

axes[0].legend()

axes[1].scatter(pls.transform(X_test), y_test, alpha=0.3, label="ground truth")

axes[1].scatter(

pls.transform(X_test), pls.predict(X_test), alpha=0.3, label="predictions"

)

axes[1].set(xlabel="Projected data onto first PLS component", ylabel="y", title="PLS")

axes[1].legend()

plt.tight_layout()

plt.show()

正如预期的那样,PCR 的无监督 PCA 转换丢弃了第二个分量,即方差最低的方向,尽管它是最具预测性的方向。这是因为 PCA 是一种完全无监督的转换,导致投影数据对目标的预测能力较低。

另一方面,PLS 回归器设法捕捉到方差最低方向的影响,这归功于它在转换过程中使用了目标信息:它可以识别出这个方向实际上是最具预测性的。我们注意到第一个 PLS 分量与目标呈负相关,这是因为特征向量的符号是任意的。

我们还打印了两个估计器的 R-平方分数,这进一步证实了在这种情况下 PLS 是比 PCR 更好的替代方案。负 R-平方表明 PCR 的表现比简单预测目标均值的回归器更差。

print(f"PCR r-squared {pcr.score(X_test, y_test):.3f}")

print(f"PLS r-squared {pls.score(X_test, y_test):.3f}")

PCR r-squared -0.026

PLS r-squared 0.658

最后,我们注意到具有 2 个分量的 PCR 表现与 PLS 一样好:这是因为在这种情况下,PCR 能够利用对目标具有最大预测能力的第二个分量。

pca_2 = make_pipeline(PCA(n_components=2), LinearRegression())

pca_2.fit(X_train, y_train)

print(f"PCR r-squared with 2 components {pca_2.score(X_test, y_test):.3f}")

PCR r-squared with 2 components 0.673

脚本总运行时间: (0 分钟 0.443 秒)

相关示例