注意

跳到末尾以下载完整的示例代码。或者通过 JupyterLite 或 Binder 在浏览器中运行此示例

scikit-learn 0.24 发布亮点#

我们很高兴地宣布 scikit-learn 0.24 发布!本次发布增加了许多错误修复和改进,以及一些新的关键功能。下面我们将详细介绍本次发布的一些主要功能。要获取所有更改的详尽列表,请参阅发布说明。

安装最新版本(使用 pip)

pip install --upgrade scikit-learn

或使用 conda

conda install -c conda-forge scikit-learn

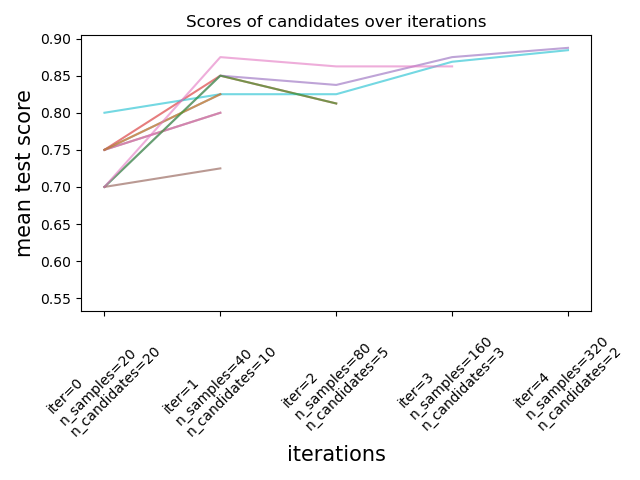

用于调优超参数的逐次减半估计器#

Successive Halving 是一种最先进的方法,现已可用于探索参数空间并找出其最佳组合。HalvingGridSearchCV 和 HalvingRandomSearchCV 可作为 GridSearchCV 和 RandomizedSearchCV 的直接替代品。Successive Halving 是一种迭代选择过程,如下图所示。第一次迭代使用少量资源运行,资源通常对应于训练样本的数量,但也可以是任意整数参数,例如随机森林中的 n_estimators。只有一部分参数候选被选中进行下一次迭代,下一次迭代将使用增加的分配资源量运行。只有一小部分候选将持续到迭代过程结束,最佳参数候选是在最后一次迭代中得分最高的那个。

在用户指南中阅读更多信息(注意:Successive Halving 估计器仍处于实验阶段)。

import numpy as np

from scipy.stats import randint

from sklearn.datasets import make_classification

from sklearn.ensemble import RandomForestClassifier

from sklearn.experimental import enable_halving_search_cv # noqa: F401

from sklearn.model_selection import HalvingRandomSearchCV

rng = np.random.RandomState(0)

X, y = make_classification(n_samples=700, random_state=rng)

clf = RandomForestClassifier(n_estimators=10, random_state=rng)

param_dist = {

"max_depth": [3, None],

"max_features": randint(1, 11),

"min_samples_split": randint(2, 11),

"bootstrap": [True, False],

"criterion": ["gini", "entropy"],

}

rsh = HalvingRandomSearchCV(

estimator=clf, param_distributions=param_dist, factor=2, random_state=rng

)

rsh.fit(X, y)

rsh.best_params_

{'bootstrap': True, 'criterion': 'gini', 'max_depth': None, 'max_features': 10, 'min_samples_split': 10}

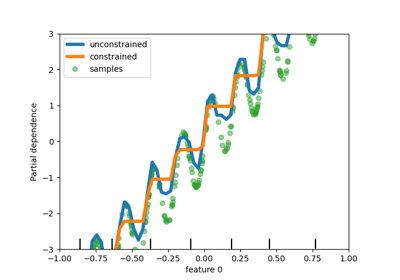

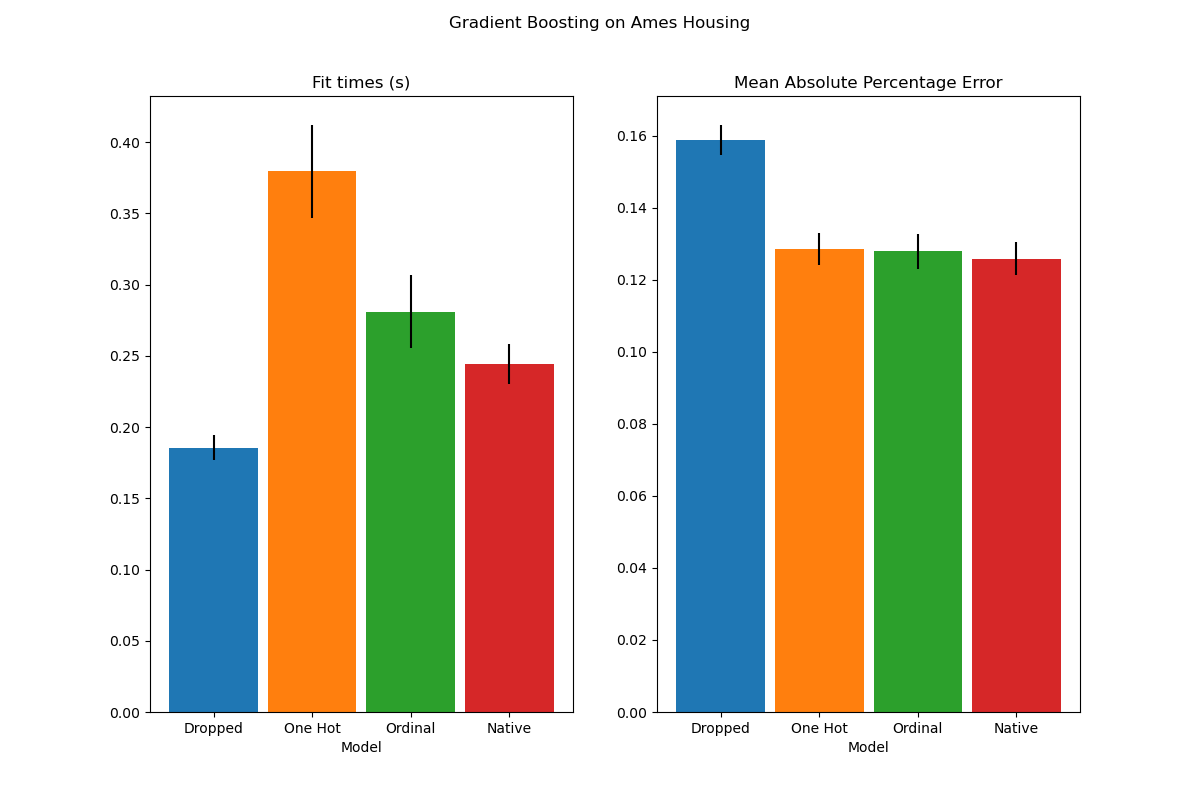

HistGradientBoosting 估计器对分类特征的原生支持#

HistGradientBoostingClassifier 和 HistGradientBoostingRegressor 现在原生支持分类特征:它们可以考虑对无序的分类数据进行分割。在用户指南中阅读更多信息。

该图显示,对分类特征的新原生支持所产生的拟合时间与将类别视为有序量(即简单地进行序数编码)的模型相当。原生支持也比独热编码和序数编码更具表达力。但是,要使用新的 categorical_features 参数,仍然需要像本示例中演示的那样在管道中预处理数据。

HistGradientBoosting 估计器性能改进#

ensemble.HistGradientBoostingRegressor 和 ensemble.HistGradientBoostingClassifier 在调用 fit 期间的内存占用已显著改善。此外,直方图初始化现在并行完成,从而略微提高了速度。请参阅基准测试页面了解更多信息。

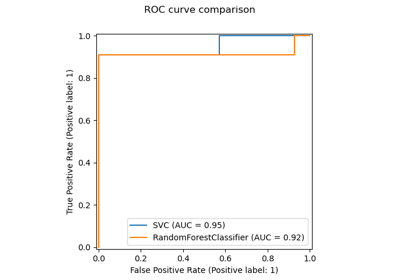

新的自训练元估计器#

现在可以将基于Yarowski 算法的新自训练实现与任何实现predict_proba的分类器一起使用。子分类器将作为半监督分类器,允许它从未标记数据中学习。在用户指南中阅读更多信息。

import numpy as np

from sklearn import datasets

from sklearn.semi_supervised import SelfTrainingClassifier

from sklearn.svm import SVC

rng = np.random.RandomState(42)

iris = datasets.load_iris()

random_unlabeled_points = rng.rand(iris.target.shape[0]) < 0.3

iris.target[random_unlabeled_points] = -1

svc = SVC(probability=True, gamma="auto")

self_training_model = SelfTrainingClassifier(svc)

self_training_model.fit(iris.data, iris.target)

新的 SequentialFeatureSelector 转换器#

一个新的迭代特征选择转换器已可用:SequentialFeatureSelector。顺序特征选择可以一次添加一个特征(前向选择)或从可用特征列表中删除特征(后向选择),基于交叉验证得分最大化。请参阅用户指南。

from sklearn.datasets import load_iris

from sklearn.feature_selection import SequentialFeatureSelector

from sklearn.neighbors import KNeighborsClassifier

X, y = load_iris(return_X_y=True, as_frame=True)

feature_names = X.columns

knn = KNeighborsClassifier(n_neighbors=3)

sfs = SequentialFeatureSelector(knn, n_features_to_select=2)

sfs.fit(X, y)

print(

"Features selected by forward sequential selection: "

f"{feature_names[sfs.get_support()].tolist()}"

)

Features selected by forward sequential selection: ['sepal length (cm)', 'petal width (cm)']

新的 PolynomialCountSketch 核近似函数#

新的 PolynomialCountSketch 在与线性模型一起使用时,近似于特征空间的多项式展开,但比 PolynomialFeatures 使用的内存少得多。

from sklearn.datasets import fetch_covtype

from sklearn.kernel_approximation import PolynomialCountSketch

from sklearn.linear_model import LogisticRegression

from sklearn.model_selection import train_test_split

from sklearn.pipeline import make_pipeline

from sklearn.preprocessing import MinMaxScaler

X, y = fetch_covtype(return_X_y=True)

pipe = make_pipeline(

MinMaxScaler(),

PolynomialCountSketch(degree=2, n_components=300),

LogisticRegression(max_iter=1000),

)

X_train, X_test, y_train, y_test = train_test_split(

X, y, train_size=5000, test_size=10000, random_state=42

)

pipe.fit(X_train, y_train).score(X_test, y_test)

0.7369

作为比较,这是相同数据线性基线的得分

linear_baseline = make_pipeline(MinMaxScaler(), LogisticRegression(max_iter=1000))

linear_baseline.fit(X_train, y_train).score(X_test, y_test)

0.7141

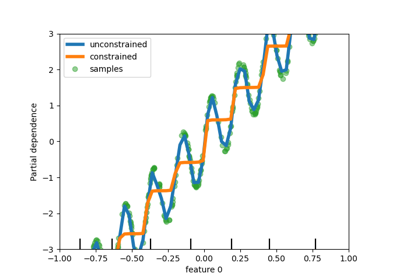

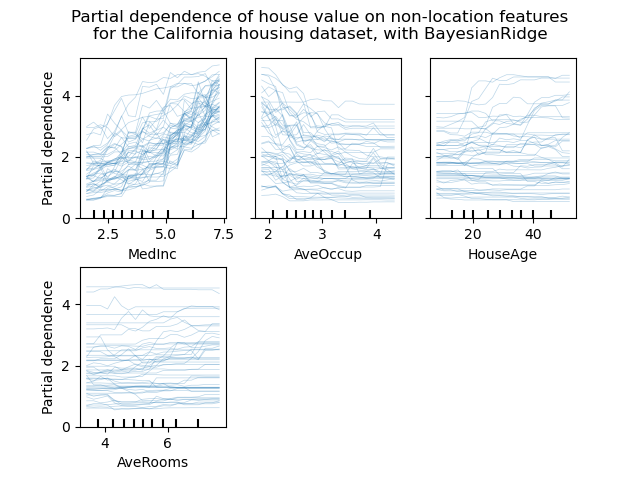

个体条件期望图#

一种新的部分依赖图现已可用:个体条件期望 (ICE) 图。ICE 图单独显示每个样本的预测对特征的依赖性,每个样本一条线。请参阅用户指南

from sklearn.datasets import fetch_california_housing

from sklearn.ensemble import RandomForestRegressor

# from sklearn.inspection import plot_partial_dependence

from sklearn.inspection import PartialDependenceDisplay

X, y = fetch_california_housing(return_X_y=True, as_frame=True)

features = ["MedInc", "AveOccup", "HouseAge", "AveRooms"]

est = RandomForestRegressor(n_estimators=10)

est.fit(X, y)

# plot_partial_dependence has been removed in version 1.2. From 1.2, use

# PartialDependenceDisplay instead.

# display = plot_partial_dependence(

display = PartialDependenceDisplay.from_estimator(

est,

X,

features,

kind="individual",

subsample=50,

n_jobs=3,

grid_resolution=20,

random_state=0,

)

display.figure_.suptitle(

"Partial dependence of house value on non-location features\n"

"for the California housing dataset, with BayesianRidge"

)

display.figure_.subplots_adjust(hspace=0.3)

DecisionTreeRegressor 的新泊松分裂准则#

泊松回归估计的集成从 0.23 版本继续。DecisionTreeRegressor 现在支持新的 'poisson' 分裂准则。如果您的目标是计数或频率,将 criterion="poisson" 设置可能是一个不错的选择。

import numpy as np

from sklearn.model_selection import train_test_split

from sklearn.tree import DecisionTreeRegressor

n_samples, n_features = 1000, 20

rng = np.random.RandomState(0)

X = rng.randn(n_samples, n_features)

# positive integer target correlated with X[:, 5] with many zeros:

y = rng.poisson(lam=np.exp(X[:, 5]) / 2)

X_train, X_test, y_train, y_test = train_test_split(X, y, random_state=rng)

regressor = DecisionTreeRegressor(criterion="poisson", random_state=0)

regressor.fit(X_train, y_train)

新的文档改进#

添加了新的示例和文档页面,持续努力提高对机器学习实践的理解

脚本总运行时间: (0 分 12.897 秒)

相关示例