注意

前往末尾 下载完整示例代码,或通过JupyterLite或Binder在浏览器中运行此示例

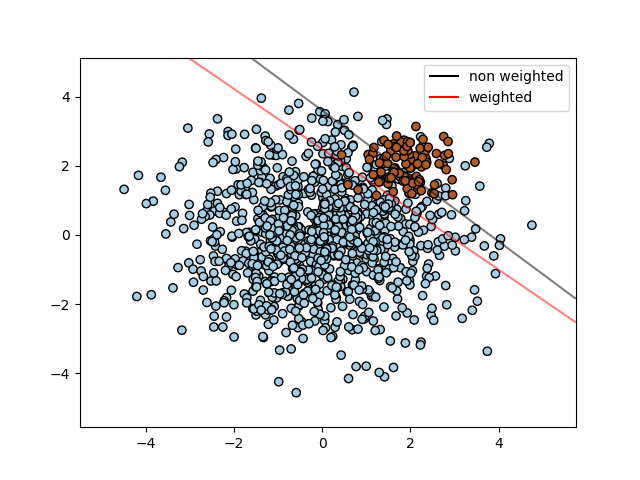

SVM:不平衡类别的分离超平面#

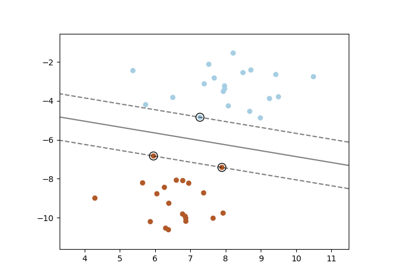

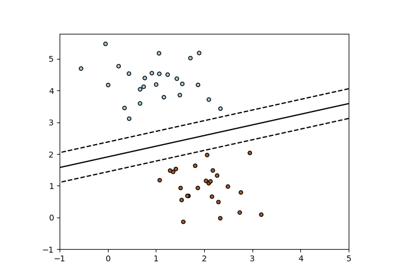

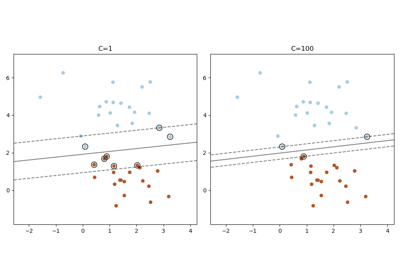

使用SVC为不平衡类别找到最优分离超平面。

我们首先使用普通SVC找到分离平面,然后(虚线)绘制自动纠正不平衡类别的分离超平面。

注意

这个示例也可以通过将SVC(kernel="linear")替换为SGDClassifier(loss="hinge")来工作。将SGDClassifier的loss参数设置为hinge将产生与线性核SVC类似的行为。

例如,可以尝试使用SVC的替代方案

clf = SGDClassifier(n_iter=100, alpha=0.01)

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

import matplotlib.lines as mlines

import matplotlib.pyplot as plt

from sklearn import svm

from sklearn.datasets import make_blobs

from sklearn.inspection import DecisionBoundaryDisplay

# we create two clusters of random points

n_samples_1 = 1000

n_samples_2 = 100

centers = [[0.0, 0.0], [2.0, 2.0]]

clusters_std = [1.5, 0.5]

X, y = make_blobs(

n_samples=[n_samples_1, n_samples_2],

centers=centers,

cluster_std=clusters_std,

random_state=0,

shuffle=False,

)

# fit the model and get the separating hyperplane

clf = svm.SVC(kernel="linear", C=1.0)

clf.fit(X, y)

# fit the model and get the separating hyperplane using weighted classes

wclf = svm.SVC(kernel="linear", class_weight={1: 10})

wclf.fit(X, y)

# plot the samples

plt.scatter(X[:, 0], X[:, 1], c=y, cmap=plt.cm.Paired, edgecolors="k")

# plot the decision functions for both classifiers

ax = plt.gca()

disp = DecisionBoundaryDisplay.from_estimator(

clf,

X,

plot_method="contour",

colors="k",

levels=[0],

alpha=0.5,

linestyles=["-"],

ax=ax,

)

# plot decision boundary and margins for weighted classes

wdisp = DecisionBoundaryDisplay.from_estimator(

wclf,

X,

plot_method="contour",

colors="r",

levels=[0],

alpha=0.5,

linestyles=["-"],

ax=ax,

)

plt.legend(

[

mlines.Line2D([], [], color="k", label="non weighted"),

mlines.Line2D([], [], color="r", label="weighted"),

],

["non weighted", "weighted"],

loc="upper right",

)

plt.show()

脚本总运行时间: (0 分钟 0.157 秒)

相关示例