注意

转到末尾 下载完整的示例代码或通过 JupyterLite 或 Binder 在浏览器中运行此示例。

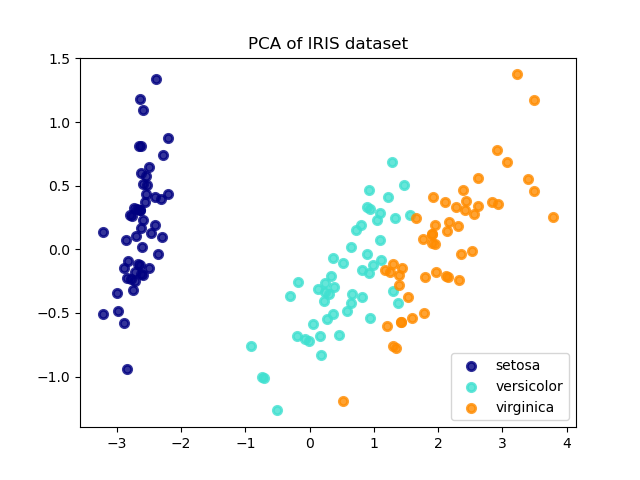

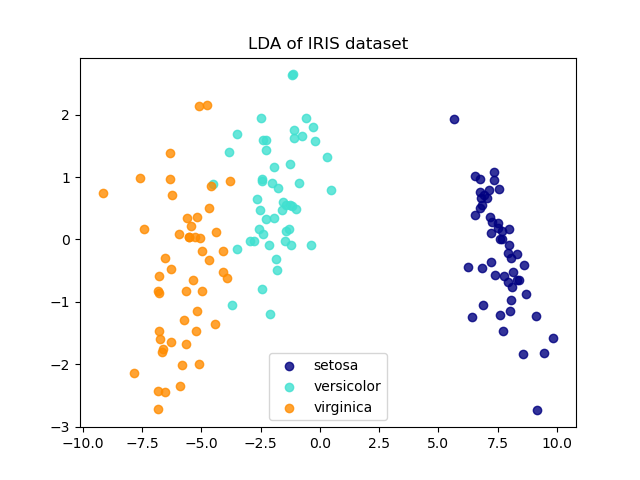

鸢尾花数据集的 LDA 与 PCA 2D 投影比较#

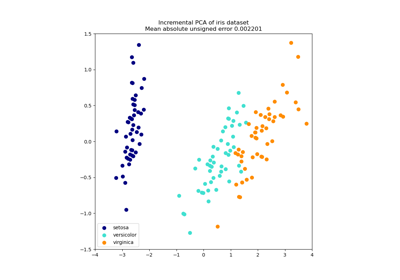

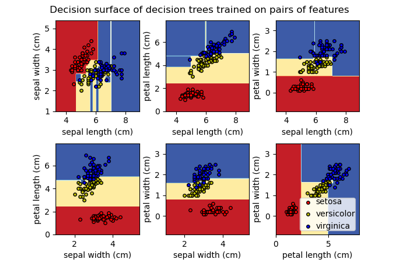

鸢尾花数据集代表了 3 种鸢尾花(Setosa、Versicolour 和 Virginica),具有 4 个属性:萼片长度、萼片宽度、花瓣长度和花瓣宽度。

应用于此数据的主成分分析(PCA)识别出数据中方差最大的属性组合(主成分,或特征空间中的方向)。在这里,我们在前两个主成分上绘制了不同的样本。

线性判别分析(LDA)试图识别出_类间_方差最大的属性。特别是,与 PCA 不同,LDA 是一种有监督的方法,它使用已知的类标签。

explained variance ratio (first two components): [0.92461872 0.05306648]

# Authors: The scikit-learn developers

# SPDX-License-Identifier: BSD-3-Clause

import matplotlib.pyplot as plt

from sklearn import datasets

from sklearn.decomposition import PCA

from sklearn.discriminant_analysis import LinearDiscriminantAnalysis

iris = datasets.load_iris()

X = iris.data

y = iris.target

target_names = iris.target_names

pca = PCA(n_components=2)

X_r = pca.fit(X).transform(X)

lda = LinearDiscriminantAnalysis(n_components=2)

X_r2 = lda.fit(X, y).transform(X)

# Percentage of variance explained for each components

print(

"explained variance ratio (first two components): %s"

% str(pca.explained_variance_ratio_)

)

plt.figure()

colors = ["navy", "turquoise", "darkorange"]

lw = 2

for color, i, target_name in zip(colors, [0, 1, 2], target_names):

plt.scatter(

X_r[y == i, 0], X_r[y == i, 1], color=color, alpha=0.8, lw=lw, label=target_name

)

plt.legend(loc="best", shadow=False, scatterpoints=1)

plt.title("PCA of IRIS dataset")

plt.figure()

for color, i, target_name in zip(colors, [0, 1, 2], target_names):

plt.scatter(

X_r2[y == i, 0], X_r2[y == i, 1], alpha=0.8, color=color, label=target_name

)

plt.legend(loc="best", shadow=False, scatterpoints=1)

plt.title("LDA of IRIS dataset")

plt.show()

脚本总运行时间: (0 分钟 0.174 秒)

相关示例